前几章

40.概化问题:从培训样本到验证

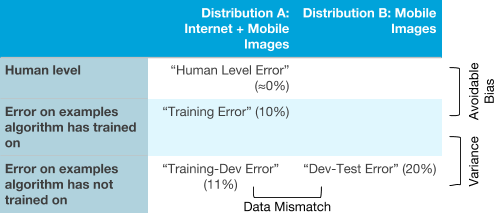

假设您在训练样本和验证样本的分布不同的情况下应用ML。例如,训练样本包含来自Internet的图像+移动应用程序的图像,而测试和验证样本仅来自移动应用程序。但是,该算法无法很好地发挥作用:在验证和测试样本中,其误差要比我们希望的高得多。以下是一些可能的原因:

- 该算法在测试样本上的效果较差,这是由于训练样本分布中存在高(可避免)偏差的问题

- 该算法在训练集上质量很高,但是无法将其工作推广到与训练集具有相似分布的数据,这是他之前从未见过的。这是高度分散的情况。

- 该算法很好地将其工作推广到与训练样本相同的分布中的新数据,但是无法应对(概括)从另一分布中获得的验证和测试样品的分布。这表明由于训练样本的分布与验证样本和测试样本的分布不同而引起的数据不一致

例如,假设人类对猫的识别水平几乎是理想的。您关于它的算法显示:

- 训练样本中有1%的误差

- 来自与训练样本相同分布的数据的误差为1.5%,但在训练过程中未显示给算法

- 验证和测试样品有10%的误差

. , . , .

, , , . , , : , , « », .

:

- . , ( + ). , ( ).

- : , ( + ). , ; , .

- : , , , . (, )

- : . ( )

, :

5-7 « ».

41. ,

( ≈0%) , , , 0%.

, :

? , . , , .

, :

, . .. . .

. , , , .

:

. , .

, , :

, . Y : , , , , . , .

. ( , ), , . , ( B) , . . , ( A B).

确定了算法遇到最困难的错误类型后,可以更合理地决定是专注于减少偏差,减少分散,还是需要为应对数据不一致而感到困惑。

延续