2018年是旨在解决文本处理问题(或更准确地说,处理自然语言(NLP))的机器学习模型发展的转折点。关于如何呈现单词和句子以最准确地提取它们的语义和它们之间的关系的概念性理解正在迅速发展。此外,NLP社区推广了非常强大的工具,这些工具可以在其模型和管道中免费下载和使用。这个转折点也称为NLP的ImageNet时刻,指的是几年前的时刻,当时类似的发展大大加速了计算机视觉问题领域中机器学习的发展。

(ULM-FiT与Korzhik无关,但没有发生更好的事情)

– BERT', , NLP. BERT – , NLP-. , , BERT', . , , , .

BERT'. 1: ( ); 2: .

BERT , NLP-, , : Semi-supervised Sequence learning ( – Andrew Dai Quoc Le), ELMo ( – Matthew Peters AI2 UW CSE), ULMFiT ( – fast.ai Jeremy Howard Sebastian Ruder), OpenAI Transformer ( – OpenAI Radford, Narasimhan, Salimans, Sutskever) (Vaswani et al).

, , BERT'. , , .

:

BERT – . :

, , (classifier) BERT' . (fine-tuning), Semi-supervised Sequence Learning ULMFiT.

, : , . . («» « »).

BERT':

- (sentiment analysis)

- (fact-checking):

- : . : «» (Claim) « » (Not Claim)

- / :

- : (Claim sentence). : «» «»

- Full Fact – , . , , ( , , , )

- :

, BERT', , .

BERT' :

- BERT BASE () – OpenAI Transformer;

- BERT LARGE () – , (state of the art), .

, BERT – . . , – BERT’ , .

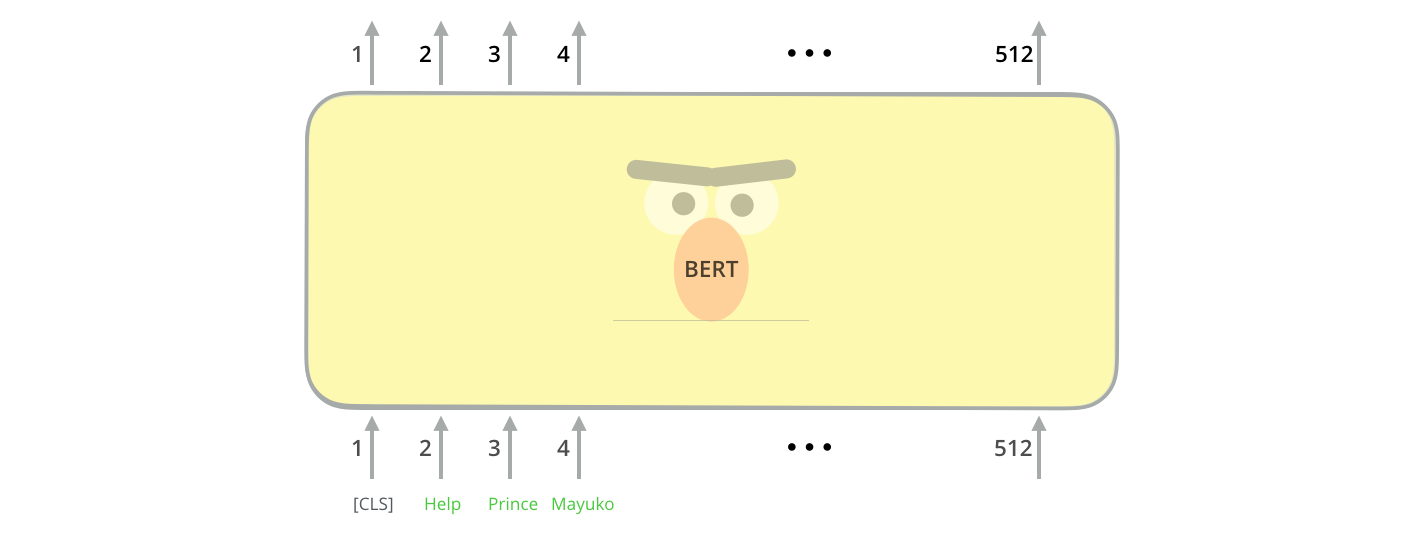

BERT' ( « » (Transformer Blocks)): 12 24 . (768 1024 ) «» (attention heads)(12 16 ), , (6 , 512 , 8 «» ).

[CLS] , . CLS .

, , BERT , . (self-attention) , .

, ( , ). .

hidden_size (768 BERT'). , , ( [CLS]).

. , .

(, «», « », « », «» .), .

, , , VGGNet .

. , NLP- , : Word2Vec GloVe. , , , .

, . Word2Vec , ( ), , (.. , «» – «» «» – «»), (, , «» «» , «» «»).

, , , . , Word2Vec GloVe. GloVe «stick» ( – 200):

«stick» GloVe – 200 ( 2 ).

.

ELMo:

GloVe, «stick» . « », – NLP- ( Peters et. al., 2017, McCann et. al., 2017 Peters et. al., 2018 ELMo). – « «stick» , . , – , , ?». (contextualized word-embeddings).

.

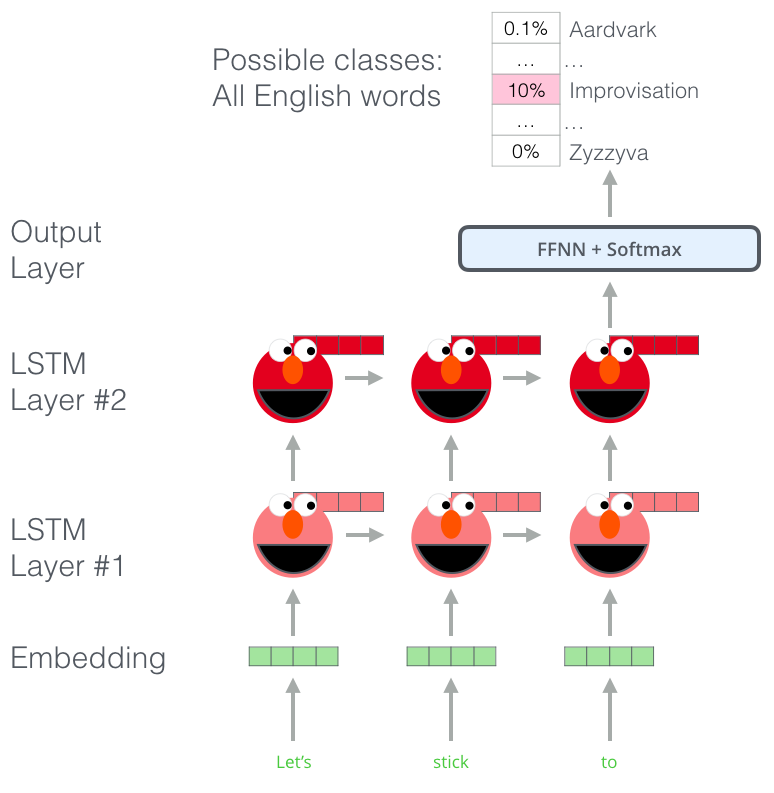

, , ELMo , . (bi-directional LSTM), .

ELMo NLP. ELMo LSTM , , .

ELMo?

ELMo – , (language modeling). , , .

ELMo: «Let's stick to», – . . , . , , , , «hang», «out» ( «hang out»), «camera».

, LSTM - ELMo. , .

, ELMo LSTM – , «» , .

ELMo

ELMo ( ) ( ).

ULM-FiT: NLP

ULM-FiT , – . ULM-FiT .

NLP , , , .

, , , , NLP- LSTM. .

- . ? , (.. , )?

, , NLP-. . : , ( ).

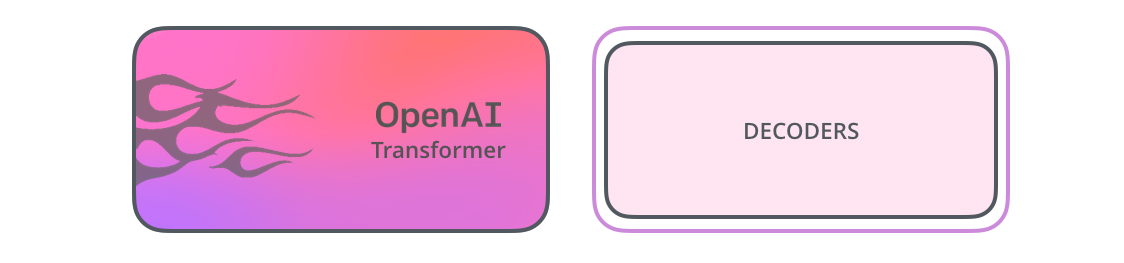

OpenAI Transformer

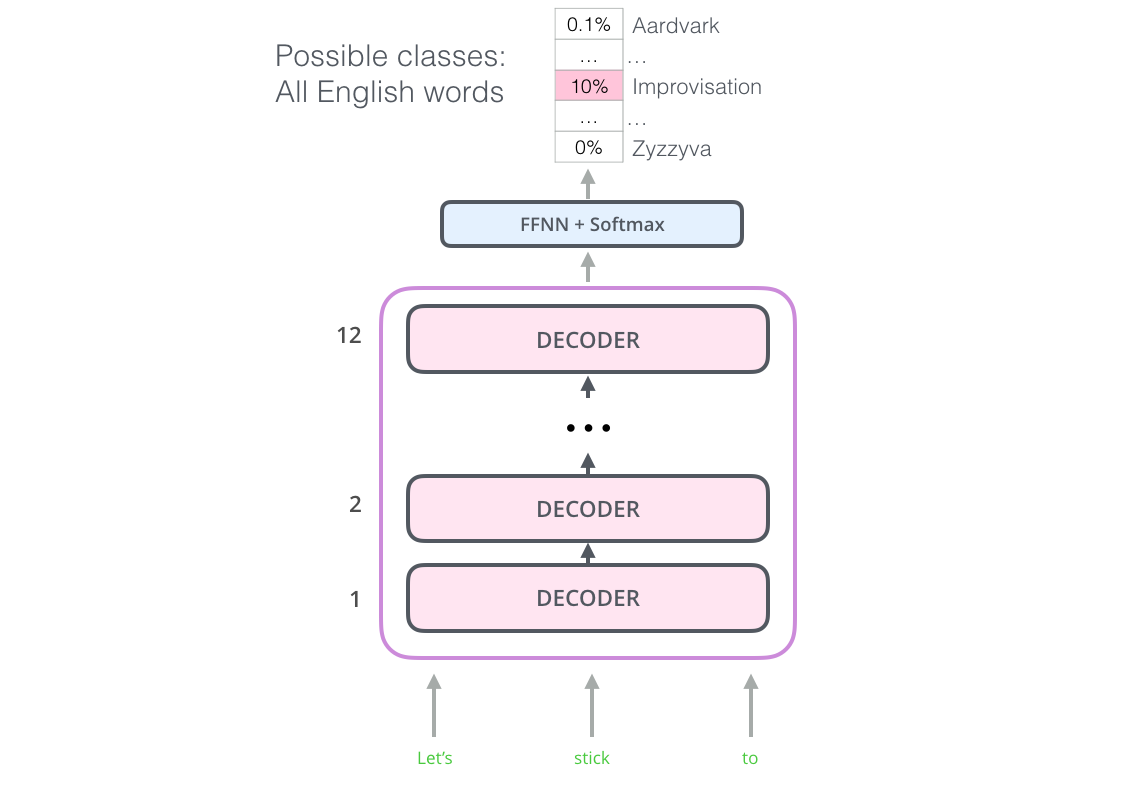

12 . - , . , ( ).

: , . 7 . , .. , – , , .

OpenAI Transformer 7000

, OpenAI Transformer , . ( «» « »):

OpenAI , . :

, ?

BERT:

OpenAI Transformer , . - LSTM . ELMo , OpenAI Transformer . , , ( – « , »)?

« », – .

(masked language model)

« », – .

« !» – . – « , .»

« », – .

BERT «» 15% .

– , BERT , « » (masked language model) ( «-»).

15% , BERT , . .

OpenAI Transformer, , - (, ? , ?).

, BERT , : ( ); , ?

, BERT – . , .. BERT WordPieces, – .

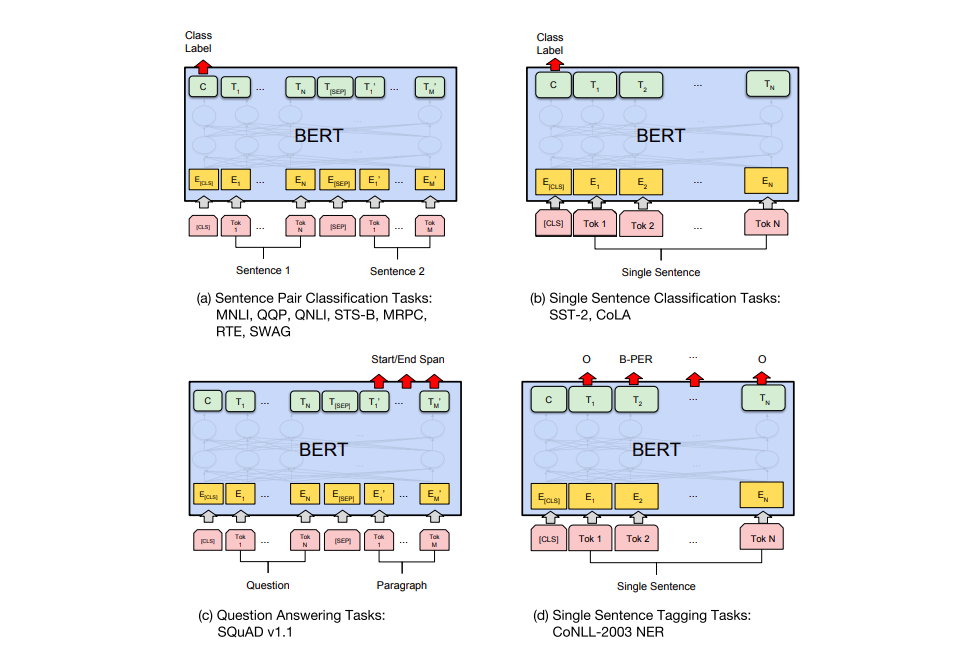

BERT' .

a) : MNLI, QQP, QNLI, STS-B, MRPC, RTE, SWAG; b) : SST-2, CoLA; c) - : SQuAD v1.1; d) : CoNLL-2003 NER.

BERT

– BERT. ELMo, BERT' . – , , , , (named-entity recognition).

? . 6 ( , 96,4):

- BERT'

BERT – BERT FineTuning with Cloud TPUs, Google Colab. Cloud TPU, , .. BERT' TPU, CPU GPU.

– BERT':

PyTorch- BERT'. AllenNLP BERT'a .