Kompleksitas penyajian data untuk pembelajaran mendalam semakin meningkat setiap hari. Graph Neural Networks ( GNNs ) telah menjadi salah satu terobosan beberapa tahun terakhir. Tapi mengapa tepatnya grafik semakin populer dalam pembelajaran mesin?

Tujuan akhir narasi saya adalah presentasi umum grafik dalam teknik pembelajaran mesin. Artikel ini tidak berpura-pura sebagai karya ilmiah yang sepenuhnya menggambarkan kekuatan penuh grafik, tetapi hanya memperkenalkan pembaca ke dunia yang luar biasa dan kompleks ini. Publikasi ini sempurna, baik untuk para profesional yang berjuang keras yang belum terbiasa dengan presentasi grafik dalam pembelajaran yang mendalam, dan untuk pemula di bidang ini.

pengantar

Secara otomatis menyoroti fitur-fitur penting yang diperlukan untuk menyelesaikan masalah adalah salah satu alasan utama keberhasilan penggunaan pembelajaran mesin. Tetapi secara tradisional, ketika bekerja dengan grafik, pendekatan pembelajaran mesin mengandalkan heuristik yang ditentukan pengguna untuk mengekstraksi fitur pengkodean informasi grafik struktural. Namun demikian, tren beberapa tahun terakhir telah berubah: semakin banyak pendekatan yang muncul di mana mereka secara otomatis belajar membuat kode struktur grafik dalam investasi dimensi rendah menggunakan metode pembelajaran mendalam dan pengurangan dimensi non-linear.

Dalam pembelajaran mesin pada grafik, dua masalah utama dapat dibedakan: penyertaan informasi tentang struktur grafik dalam model (yaitu, cara sederhana untuk menyandikan informasi ini dalam vektor fitur) dan pengurangan dimensi vektor fitur.

( ), . , , .

?

, , : ?

— . , , ( ) [1], [2], ( [3], [4] [5]), [6] [7].

CV/ML , , . , , [8].

, . . , , , .

, (embeddings), . , , , , (), . , , . , .

, . , , . , , , .

, (direct encoding), . . , , -. , , , .

DeepWalk node2vec . , . , .

( ). (DNGR SDNE), , [9].

, , , — ( ) , .

(.1). :

, , , ( , ). .

, . , ( , ). , , , , .

, , . , , . (, )

- , , / . ; ( ) , ( ). , .

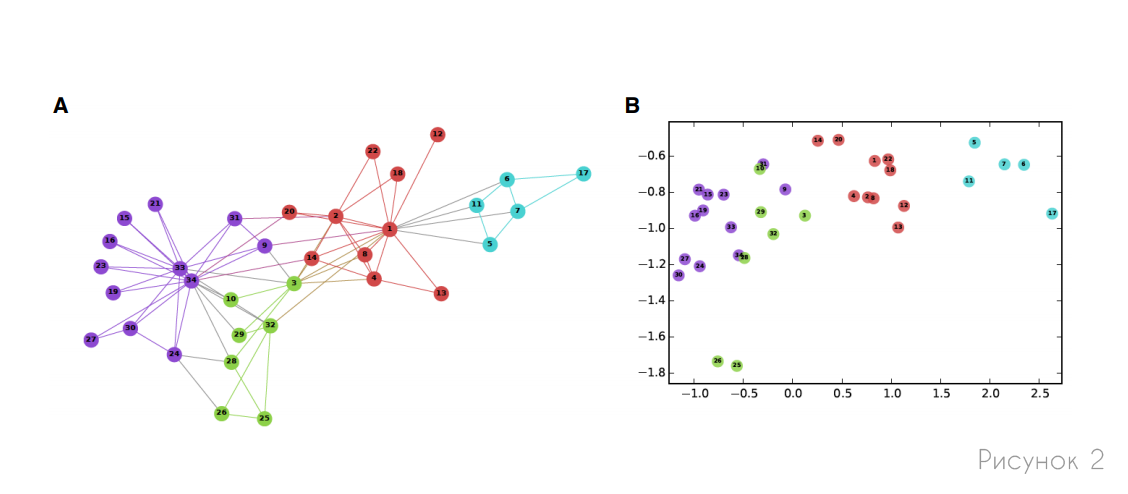

, , , . , (, ) . 2 , , .

, — , , ( ):

— , :

. , , . , , . , :

— , . , , 1, 0. . ( 1) :

— , (.. ) .

, -, , . , , , , , .

seq2seq , , . , seq2seq, GNN [10].

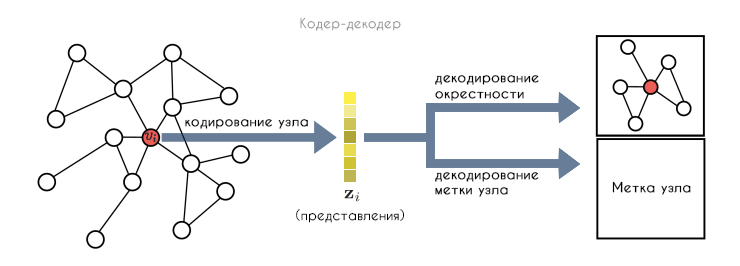

, :

- : , .

- ENC, . , .

- DEC, .

- , , .

. , . , .

, , . , , (.3). , , , .

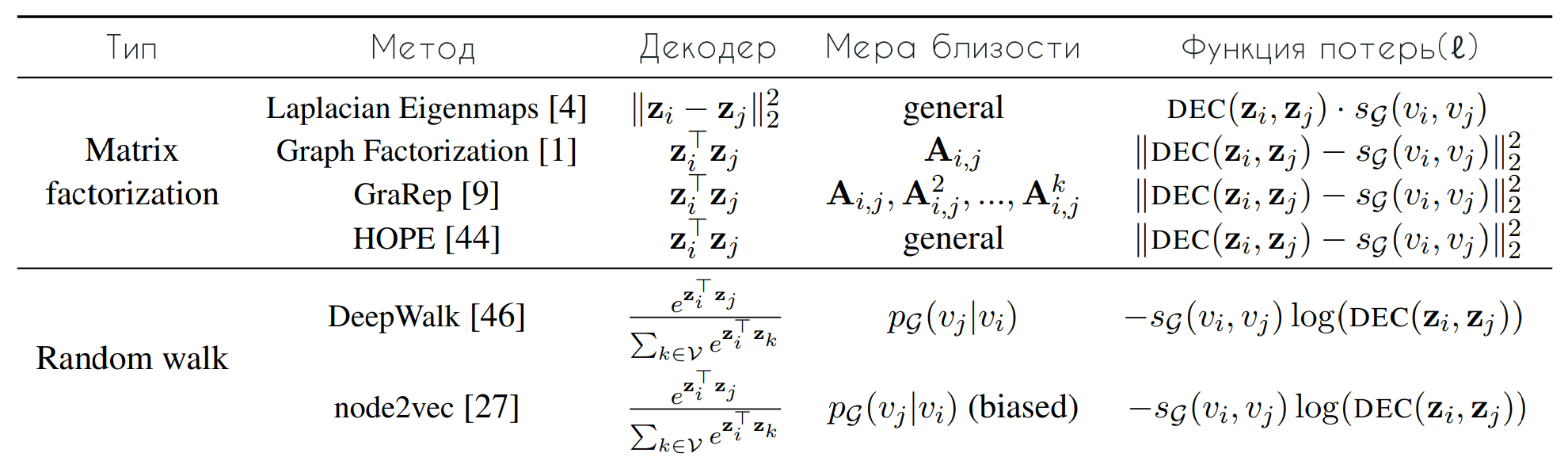

DeepWalk node2vec, , , . , , . , , :

— , , . , . , :

, (.. . — ( (2) ). , DeepWalk node2vec (3). DeepWalk softmax , . , node2vec (3), : , , " ".

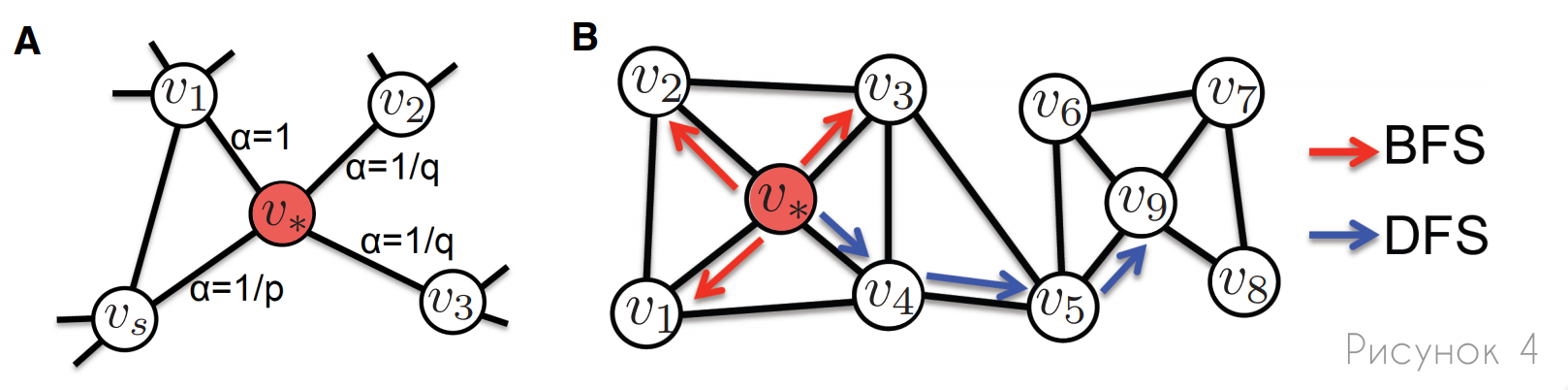

, node2vec DeepWalk , , . , node2vec : , (.4). , . , node2vec , .

A: , node2vec , p q. , , (α) , .

B: , (BFS) (DFS). , BFS, , , . , , DFS, .

, . , :

- (.. ). , , .

- . (, ), .

- . , , ( , ). , , , , .

/ . -, , , .

(DNGR) (SDNE) , : , . , — , (.5). DNGR SDNE , .

, ( — ). . DNGR SDNE , , :

, :

, , ( ), , . SDNE, DNGR, : , (.5).

SDNE DNGR , , , . DNGR , , DeepWalk node2vec. SDNE , .

, SDNE DNGR , ( ), - . , .

, . . , , , [9], . , .

. , , , , , , .

, , , .

. (. ), ( ). . , , , , , , — , , , . , , , .

. , , - , , . , , , , .

. , , , . , , , . , .

. , , . , , . , , , . , , , , .

, — . , , .

[1] — W. L. Hamilton, Z. Ying, and J. Leskovec, "Inductive representation learning on large graphs," NIPS 2017, pp. 1024–1034, 2017.

[2] — T. N. Kipf and M. Welling, "Semi-supervised classification with graph convolutional networks," ICLR 2017, 2017.

[3] — A. Sanchez-Gonzalez, N. Heess, J. T. Springenberg, J. Merel, M. Riedmiller, R. Hadsell, and P. Battaglia, "Graph networks as learnable physics engines for inference and control," arXiv

preprint arXiv:1806.01242, 2018.

[4] — P. Battaglia, R. Pascanu, M. Lai, D. J. Rezende et al., "Interaction networks for learning about objects, relations and physics," in NIPS 2016, 2016, pp. 4502–4510.

[5] — A. Fout, J. Byrd, B. Shariat, and A. Ben-Hur, "Protein interface prediction using graph convolutional networks," in NIPS 2017, 2017, pp. 6530–6539.

[6] — T. Hamaguchi, H. Oiwa, M. Shimbo, and Y. Matsumoto, "Knowledge transfer for out-of-knowledge-base entities: A graph neural network approach," in IJCAI 2017, 2017, pp. 1802–1808.

[7] — H. Dai, E. B. Khalil, Y. Zhang, B. Dilkina, and L. Song, "Learning combinatorial optimization algorithms over graphs," arXiv preprint arXiv:1704.01665, 2017.

[8] — X. Liang, X. Shen, J. Feng, F. Lin, S. Yan, "Semantic Object Parsing with Graph LSTM", arXiv:1603.07063v1 [cs.CV] 23 Mar 2016.

[9] — Z. Wu, S. Pan, F. Chen, G. Long, C. Zhang, Philip S. Yu, "A Comprehensive Survey on Graph Neural Networks", arXiv:1901.00596v4 [cs.LG] 4 Dec 2019.

[10] - P. Veličković, G. Cucurull, A. Casanova, A. Romero, P. Liò, Y. Bengio, “Graph Attention Networks”, arXiv: 1710.10903v3 [stat.ML] 4 Feb 2018.

Referensi

Grafik Neural Networks: Tinjauan Metode dan Representasi Aplikasi

Belajar pada Grafik: Metode dan Aplikasi