वर्ष 2018 पाठ प्रसंस्करण समस्याओं (या, अधिक सही ढंग से, प्राकृतिक भाषा प्रसंस्करण (एनएलपी)) को हल करने के उद्देश्य से मशीन लर्निंग मॉडल के विकास के लिए एक महत्वपूर्ण बिंदु था। अपने अर्थ संबंधी अर्थों और उनके बीच संबंधों के सबसे सटीक निष्कर्षण के लिए शब्दों और वाक्यों को कैसे प्रस्तुत किया जाए, इसकी एक वैचारिक समझ तेजी से बढ़ रही है। इसके अलावा, एनएलपी समुदाय अविश्वसनीय रूप से शक्तिशाली उपकरण को बढ़ावा देता है जिसे डाउनलोड किया जा सकता है और उनके मॉडल और पाइपलाइनों में मुफ्त में उपयोग किया जा सकता है। इस टिपिंग पॉइंट को एनएलपी का इमेजनेट पल भी कहा जाता है , कई साल पहले के उस क्षण का जिक्र, जब इसी तरह के विकास ने कंप्यूटर विज़न समस्याओं के क्षेत्र में मशीन लर्निंग के विकास को काफी तेज कर दिया था।

(ULM-FiT का कोझिक से कोई लेना देना नहीं है, लेकिन कुछ बेहतर नहीं हुआ)

– BERT', , NLP. BERT – , NLP-. , , BERT', . , , , .

BERT'. 1: ( ); 2: .

BERT , NLP-, , : Semi-supervised Sequence learning ( – Andrew Dai Quoc Le), ELMo ( – Matthew Peters AI2 UW CSE), ULMFiT ( – fast.ai Jeremy Howard Sebastian Ruder), OpenAI Transformer ( – OpenAI Radford, Narasimhan, Salimans, Sutskever) (Vaswani et al).

, , BERT'. , , .

:

BERT – . :

, , (classifier) BERT' . (fine-tuning), Semi-supervised Sequence Learning ULMFiT.

, : , . . («» « »).

BERT':

- (sentiment analysis)

- (fact-checking):

- : . : «» (Claim) « » (Not Claim)

- / :

- : (Claim sentence). : «» «»

- Full Fact – , . , , ( , , , )

- :

, BERT', , .

BERT' :

- BERT BASE () – OpenAI Transformer;

- BERT LARGE () – , (state of the art), .

, BERT – . . , – BERT’ , .

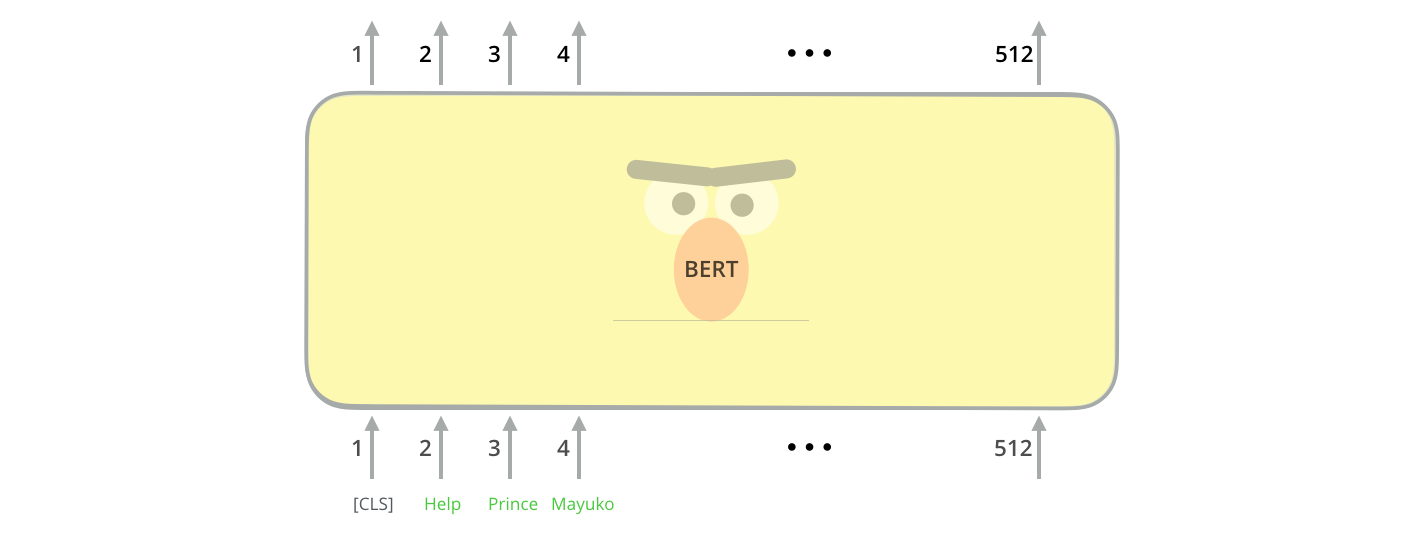

BERT' ( « » (Transformer Blocks)): 12 24 . (768 1024 ) «» (attention heads)(12 16 ), , (6 , 512 , 8 «» ).

[CLS] , . CLS .

, , BERT , . (self-attention) , .

, ( , ). .

hidden_size (768 BERT'). , , ( [CLS]).

. , .

(, «», « », « », «» .), .

, , , VGGNet .

. , NLP- , : Word2Vec GloVe. , , , .

, . Word2Vec , ( ), , (.. , «» – «» «» – «»), (, , «» «» , «» «»).

, , , . , Word2Vec GloVe. GloVe «stick» ( – 200):

«stick» GloVe – 200 ( 2 ).

.

ELMo:

GloVe, «stick» . « », – NLP- ( Peters et. al., 2017, McCann et. al., 2017 Peters et. al., 2018 ELMo). – « «stick» , . , – , , ?». (contextualized word-embeddings).

.

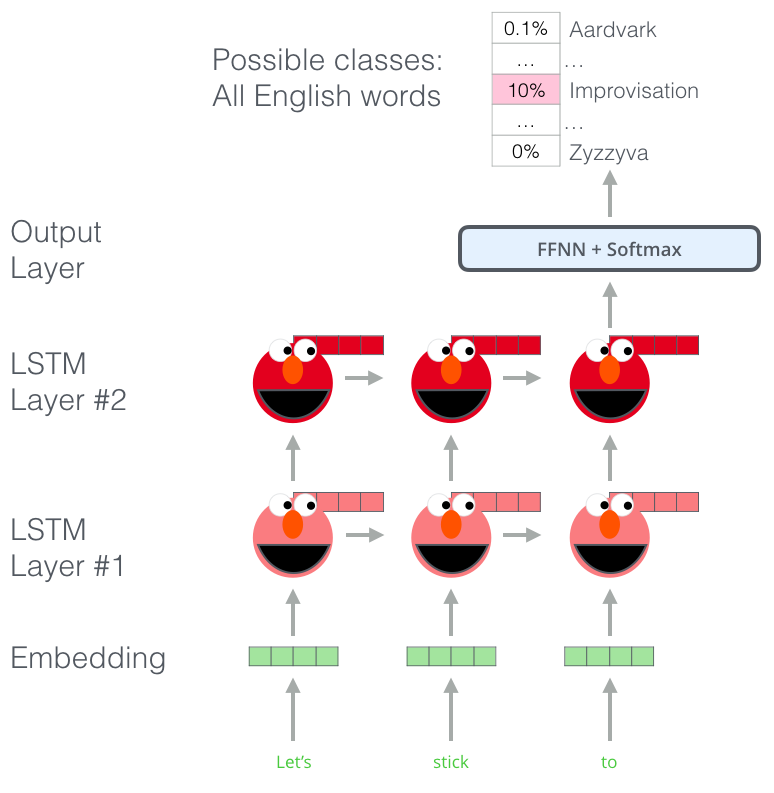

, , ELMo , . (bi-directional LSTM), .

ELMo NLP. ELMo LSTM , , .

ELMo?

ELMo – , (language modeling). , , .

ELMo: «Let's stick to», – . . , . , , , , «hang», «out» ( «hang out»), «camera».

, LSTM - ELMo. , .

, ELMo LSTM – , «» , .

ELMo

ELMo ( ) ( ).

ULM-FiT: NLP

ULM-FiT , – . ULM-FiT .

NLP , , , .

, , , , NLP- LSTM. .

- . ? , (.. , )?

, , NLP-. . : , ( ).

OpenAI Transformer

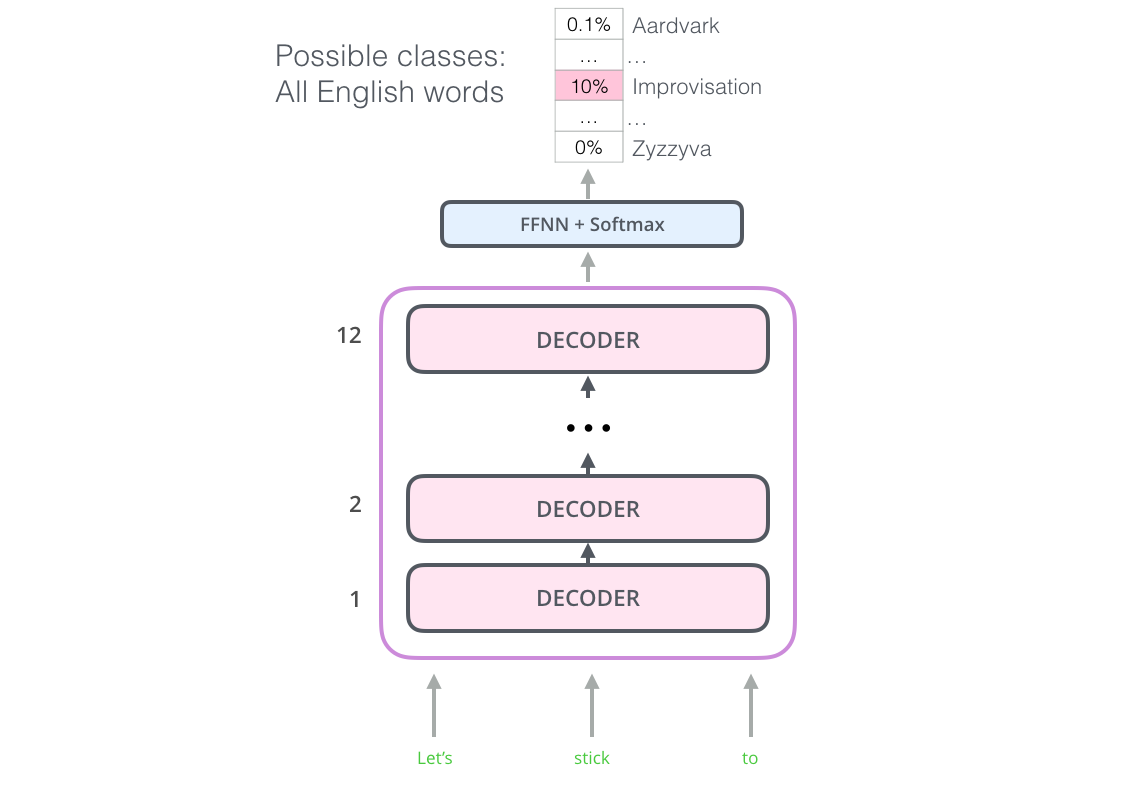

12 . - , . , ( ).

: , . 7 . , .. , – , , .

OpenAI Transformer 7000

, OpenAI Transformer , . ( «» « »):

OpenAI , . :

, ?

BERT:

OpenAI Transformer , . - LSTM . ELMo , OpenAI Transformer . , , ( – « , »)?

« », – .

(masked language model)

« », – .

« !» – . – « , .»

« », – .

BERT «» 15% .

– , BERT , « » (masked language model) ( «-»).

15% , BERT , . .

OpenAI Transformer, , - (, ? , ?).

, BERT , : ( ); , ?

, BERT – . , .. BERT WordPieces, – .

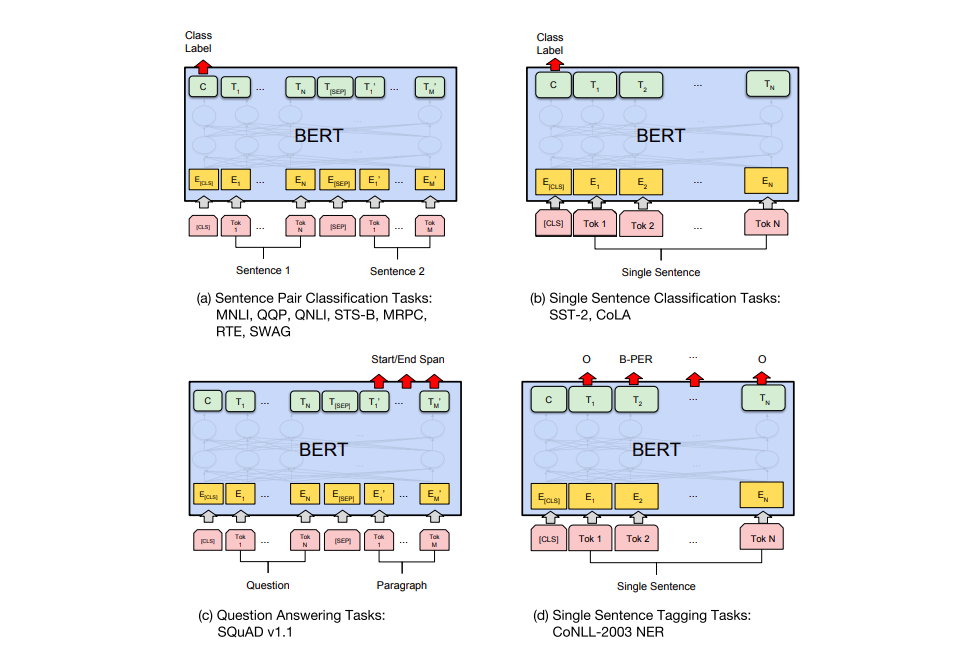

BERT' .

a) : MNLI, QQP, QNLI, STS-B, MRPC, RTE, SWAG; b) : SST-2, CoLA; c) - : SQuAD v1.1; d) : CoNLL-2003 NER.

BERT

– BERT. ELMo, BERT' . – , , , , (named-entity recognition).

? . 6 ( , 96,4):

- BERT'

BERT – BERT FineTuning with Cloud TPUs, Google Colab. Cloud TPU, , .. BERT' TPU, CPU GPU.

– BERT':

PyTorch- BERT'. AllenNLP BERT'a .