chapitres précédents

40. Problèmes de généralisation: de l'échantillon de formation à la validation

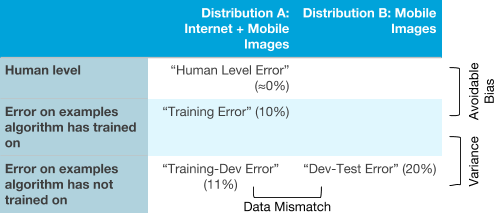

Supposons que vous appliquez ML dans des conditions où la distribution des échantillons de formation et de validation est différente. Par exemple, un exemple de formation contient des images provenant d'Internet + des images d'une application mobile, et des échantillons de test et de validation uniquement à partir d'une application mobile. Cependant, l'algorithme ne fonctionne pas très bien: il a une erreur beaucoup plus élevée dans les échantillons de validation et de test que nous le souhaiterions. Voici quelques raisons possibles:

- L'algorithme fonctionne mal sur l'échantillon de test et cela est dû au problème de biais élevé (évitable) dans la distribution de l'échantillon d'apprentissage

- L'algorithme est de haute qualité sur l'ensemble d'apprentissage, mais ne peut pas généraliser son travail à des données ayant une distribution similaire avec l'ensemble d'apprentissage, qu'il n'avait jamais vu auparavant. Il s'agit d'un cas de dispersion élevée.

- L'algorithme généralise bien son travail aux nouvelles données de la même distribution que l'échantillon d'apprentissage, mais ne peut pas faire face (généraliser) à la distribution des échantillons de validation et de test qui sont obtenus à partir d'une autre distribution. Cela indique une incohérence des données résultant de la différence dans la distribution de l'échantillon d'apprentissage par rapport aux distributions des échantillons de validation et d'essai

Par exemple, supposons que le niveau humain de reconnaissance des chats soit presque idéal. Votre algorithme le montre:

- Erreur de 1% dans l'échantillon de formation

- Erreur de 1,5% pour les données provenant de la même distribution que l'échantillon d'apprentissage, mais qui n'ont pas été montrées à l'algorithme pendant l'entraînement

- Erreur de 10% sur les échantillons de validation et de test

. , . , .

, , , . , , : , , « », .

:

- . , ( + ). , ( ).

- : , ( + ). , ; , .

- : , , , . (, )

- : . ( )

, :

5-7 « ».

41. ,

( ≈0%) , , , 0%.

, :

? , . , , .

, :

, . .. . .

. , , , .

:

. , .

, , :

, . Y : , , , , . , .

. ( , ), , . , ( B) , . . , ( A B).

Après avoir déterminé les types d'erreurs avec lesquelles l'algorithme rencontre le plus de difficultés, il est possible de décider plus raisonnablement s'il faut se concentrer sur la réduction du biais, la réduction de la dispersion ou si vous devez être intrigué par la lutte contre l'incohérence des données.

continuation