Les deux dernières années de mon temps libre, j'ai fait du triathlon. Ce sport est très populaire dans de nombreux pays du monde, en particulier aux États-Unis, en Australie et en Europe. Gagner actuellement une popularité rapide en Russie et dans les pays de la CEI. Il s'agit d'impliquer des amateurs, pas des professionnels. Contrairement à la simple natation dans la piscine, au vélo et au jogging le matin, le triathlon implique de participer à des compétitions et de se préparer systématiquement pour eux, même sans être un professionnel. Certes, parmi vos amis, il y a déjà au moins un «homme de fer» ou quelqu'un qui prévoit d'en devenir un. Massivité, une variété de distances et de conditions, trois sports en un - tout cela a le potentiel de former une grande quantité de données. Chaque année, plusieurs centaines de compétitions de triathlon ont lieu dans le monde, auxquelles participent plusieurs centaines de milliers de personnes.Les compétitions sont organisées par plusieurs organisateurs. Chacun d'eux, bien sûr, publie les résultats à part entière. Mais pour les athlètes de Russie et de certains pays de la CEI, l'équipetristats.ru recueille tous les résultats en un seul endroit - sur son site Web du même nom. Cela rend très pratique la recherche de résultats, aussi bien les vôtres que vos amis et rivaux, ou même vos idoles. Mais pour moi, cela a également permis d'analyser un grand nombre de résultats par programme. Résultats publiés sur trilife: lire .Ce fut mon premier projet de ce type, car ce n'est que récemment que j'ai commencé à faire l'analyse de données en principe, ainsi qu'à utiliser python. Par conséquent, je veux vous parler de la mise en œuvre technique de ce travail, d'autant plus que dans le processus, diverses nuances sont apparues, nécessitant parfois une approche particulière. Il s'agira de la mise au rebut, de l'analyse, des types et formats de casting, de la restauration de données incomplètes, de la création d'un échantillon représentatif, de la visualisation, de la vectorisation et même du calcul parallèle.Le volume s'est avéré important, j'ai donc tout divisé en cinq parties afin de pouvoir doser les informations et me rappeler par où commencer après la pause.Avant de poursuivre, il est préférable de lire d'abord mon article avec les résultats de l'étude, car ici décrit essentiellement la cuisine pour sa création. Cela prend 10-15 minutes.As-tu lu? Alors allons-y!

Les deux dernières années de mon temps libre, j'ai fait du triathlon. Ce sport est très populaire dans de nombreux pays du monde, en particulier aux États-Unis, en Australie et en Europe. Gagner actuellement une popularité rapide en Russie et dans les pays de la CEI. Il s'agit d'impliquer des amateurs, pas des professionnels. Contrairement à la simple natation dans la piscine, au vélo et au jogging le matin, le triathlon implique de participer à des compétitions et de se préparer systématiquement pour eux, même sans être un professionnel. Certes, parmi vos amis, il y a déjà au moins un «homme de fer» ou quelqu'un qui prévoit d'en devenir un. Massivité, une variété de distances et de conditions, trois sports en un - tout cela a le potentiel de former une grande quantité de données. Chaque année, plusieurs centaines de compétitions de triathlon ont lieu dans le monde, auxquelles participent plusieurs centaines de milliers de personnes.Les compétitions sont organisées par plusieurs organisateurs. Chacun d'eux, bien sûr, publie les résultats à part entière. Mais pour les athlètes de Russie et de certains pays de la CEI, l'équipetristats.ru recueille tous les résultats en un seul endroit - sur son site Web du même nom. Cela rend très pratique la recherche de résultats, aussi bien les vôtres que vos amis et rivaux, ou même vos idoles. Mais pour moi, cela a également permis d'analyser un grand nombre de résultats par programme. Résultats publiés sur trilife: lire .Ce fut mon premier projet de ce type, car ce n'est que récemment que j'ai commencé à faire l'analyse de données en principe, ainsi qu'à utiliser python. Par conséquent, je veux vous parler de la mise en œuvre technique de ce travail, d'autant plus que dans le processus, diverses nuances sont apparues, nécessitant parfois une approche particulière. Il s'agira de la mise au rebut, de l'analyse, des types et formats de casting, de la restauration de données incomplètes, de la création d'un échantillon représentatif, de la visualisation, de la vectorisation et même du calcul parallèle.Le volume s'est avéré important, j'ai donc tout divisé en cinq parties afin de pouvoir doser les informations et me rappeler par où commencer après la pause.Avant de poursuivre, il est préférable de lire d'abord mon article avec les résultats de l'étude, car ici décrit essentiellement la cuisine pour sa création. Cela prend 10-15 minutes.As-tu lu? Alors allons-y!Partie 1. Gratter et analyser

Éléments fournis

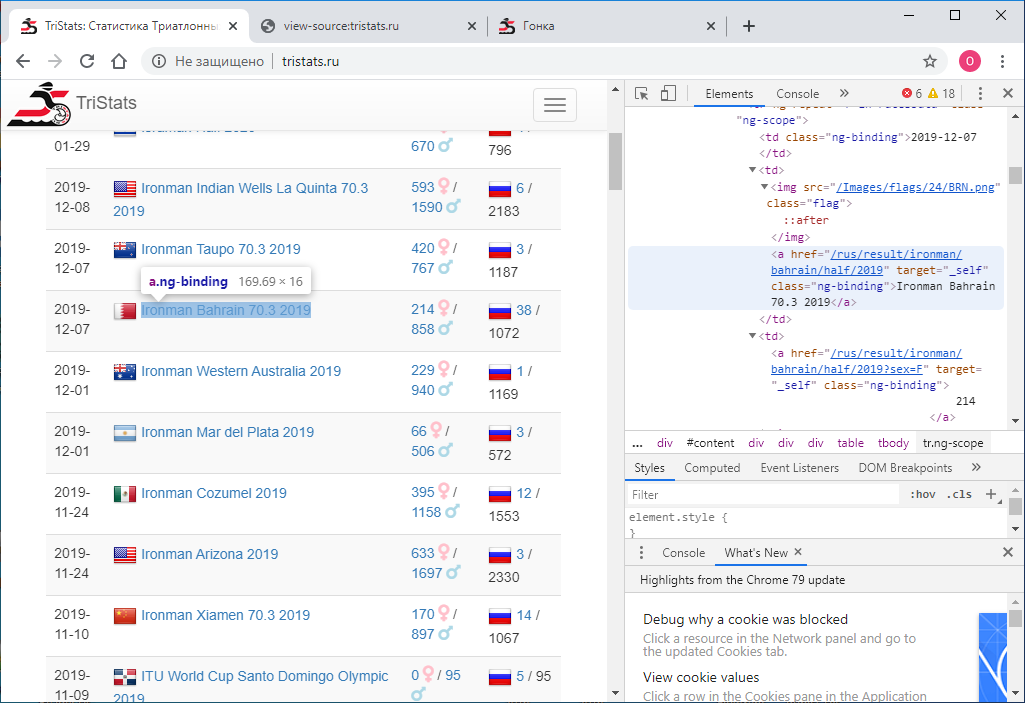

: site Web tristats.ru . Il existe deux types de tableaux qui nous intéressent. Il s'agit en fait d'un tableau récapitulatif de toutes les courses et d'un protocole des résultats de chacune d'elles.

La tâche numéro un consistait à obtenir ces données par programme et à les enregistrer pour un traitement ultérieur. Il se trouve qu'à ce moment-là, j'étais nouveau dans les technologies Web et que je ne savais donc pas immédiatement comment procéder. J'ai commencé en conséquence avec ce que je savais - regardez le code de la page. Cela peut être fait en utilisant le bouton droit de la souris ou la touche F12 .

La tâche numéro un consistait à obtenir ces données par programme et à les enregistrer pour un traitement ultérieur. Il se trouve qu'à ce moment-là, j'étais nouveau dans les technologies Web et que je ne savais donc pas immédiatement comment procéder. J'ai commencé en conséquence avec ce que je savais - regardez le code de la page. Cela peut être fait en utilisant le bouton droit de la souris ou la touche F12 . Le menu dans Chrome contient deux options: Afficher le code de la page et Afficher le code . Pas la division la plus évidente. Naturellement, ils donnent des résultats différents. Celui qui affiche le code, c'est exactement la même chose que F12 - la représentation html directement textuelle de ce qui est affiché dans le navigateur est élément par élément.

Le menu dans Chrome contient deux options: Afficher le code de la page et Afficher le code . Pas la division la plus évidente. Naturellement, ils donnent des résultats différents. Celui qui affiche le code, c'est exactement la même chose que F12 - la représentation html directement textuelle de ce qui est affiché dans le navigateur est élément par élément. À son tour, l' affichage du code de la page donne le code source de la page. Aussi html , mais il n'y a pas de données, seulement les noms des scripts JS qui les déchargent. D'accord.

À son tour, l' affichage du code de la page donne le code source de la page. Aussi html , mais il n'y a pas de données, seulement les noms des scripts JS qui les déchargent. D'accord. Maintenant, nous devons comprendre comment utiliser python pour enregistrer le code de chaque page dans un fichier texte distinct. J'essaye ceci:

Maintenant, nous devons comprendre comment utiliser python pour enregistrer le code de chaque page dans un fichier texte distinct. J'essaye ceci:import requests

r = requests.get(url='http://tristats.ru/')

print(r.content)

Et je reçois ... le code source. Mais j'ai besoin du résultat de son exécution. Après avoir étudié, cherché et demandé autour, j'ai réalisé que j'avais besoin d'un outil pour automatiser les actions du navigateur, par exemple, le sélénium . Je l'ai mis. Et aussi ChromeDriver pour travailler avec Google Chrome . Ensuite, je l'ai utilisé comme suit:from selenium import webdriver

from selenium.webdriver.chrome.service import Service

service = Service(r'C:\ChromeDriver\chromedriver.exe')

service.start()

driver = webdriver.Remote(service.service_url)

driver.get('http://www.tristats.ru/')

print(driver.page_source)

driver.quit()

Ce code lance une fenêtre de navigateur et ouvre une page dedans à l'url spécifiée. En conséquence, nous obtenons déjà du code html avec les données souhaitées. Mais il y a un hic. Le résultat est seulement 100 inscriptions, et le nombre total de courses est presque de 2000. Comment? Le fait est qu'au départ, seules les 100 premières entrées sont affichées dans le navigateur, et seulement si vous faites défiler tout en bas de la page, les 100 suivantes sont chargées, etc. Par conséquent, il est nécessaire d'implémenter le défilement par programmation. Pour ce faire, utilisez la commande:driver.execute_script("window.scrollTo(0, document.body.scrollHeight);")

Et à chaque défilement, nous vérifierons si le code de la page chargée a changé ou non. S'il n'a pas changé, nous vérifierons la fiabilité plusieurs fois, par exemple 10, puis la page entière est chargée et vous pouvez arrêter. Entre les parchemins, nous fixons le délai à une seconde afin que la page ait le temps de se charger. (Même si elle n'a pas le temps, nous avons une réserve - encore neuf secondes).Et le code complet ressemblera à ceci:from selenium import webdriver

from selenium.webdriver.chrome.service import Service

import time

service = Service(r'C:\ChromeDriver\chromedriver.exe')

service.start()

driver = webdriver.Remote(service.service_url)

driver.get('http://www.tristats.ru/')

prev_html = ''

scroll_attempt = 0

while scroll_attempt < 10:

driver.execute_script("window.scrollTo(0, document.body.scrollHeight);")

time.sleep(1)

if prev_html == driver.page_source:

scroll_attempt += 1

else:

prev_html = driver.page_source

scroll_attempt = 0

with open(r'D:\tri\summary.txt', 'w') as f:

f.write(prev_html)

driver.quit()

Nous avons donc un fichier html avec un tableau récapitulatif de toutes les races. Besoin de l'analyser. Pour ce faire, utilisez la bibliothèque lxml .from lxml import html

On trouve d'abord toutes les lignes du tableau. Pour déterminer le signe d'une chaîne, il suffit de regarder le fichier html dans un éditeur de texte. Il peut s'agir, par exemple, «tr ng-repeat = 'r in racesData' class = 'ng-scope'» ou d'un fragment qui ne se trouve plus dans aucune balise.

Il peut s'agir, par exemple, «tr ng-repeat = 'r in racesData' class = 'ng-scope'» ou d'un fragment qui ne se trouve plus dans aucune balise.with open(r'D:\tri\summary.txt', 'r') as f:

sum_html = f.read()

tree = html.fromstring(sum_html)

rows = tree.findall(".//*[@ng-repeat='r in racesData']")

nous commençons ensuite le cadre de données pandas et chaque élément de chaque ligne du tableau est écrit dans ce cadre de données.import pandas as pd

rs = pd.DataFrame(columns=['date','name','link','males','females','rus','total'], index=range(len(rows)))

Afin de comprendre où chaque élément spécifique est caché, il vous suffit de regarder le code html de l'un des éléments de nos lignes dans le même éditeur de texte.<tr ng-repeat="r in racesData" class="ng-scope">

<td class="ng-binding">2015-04-26</td>

<td>

<img src="/Images/flags/24/USA.png" class="flag">

<a href="/rus/result/ironman/texas/half/2015" target="_self" class="ng-binding">Ironman Texas 70.3 2015</a>

</td>

<td>

<a href="/rus/result/ironman/texas/half/2015?sex=F" target="_self" class="ng-binding">605</a>

<i class="fas fa-venus fa-lg" style="color:Pink"></i>

/

<a href="/rus/result/ironman/texas/half/2015?sex=M" target="_self" class="ng-binding">1539</a>

<i class="fas fa-mars fa-lg" style="color:LightBlue"></i>

</td>

<td class="ng-binding">

<img src="/Images/flags/24/rus.png" class="flag">

<a ng-if="r.CountryCount > 0" href="/rus/result/ironman/texas/half/2015?country=rus" target="_self" class="ng-binding ng-scope">2</a>

/ 2144

</td>

</tr>

Le moyen le plus simple de naviguer en code dur pour les enfants ici est qu'il n'y en a pas beaucoup.for i in range(len(rows)):

rs.loc[i,'date'] = rows[i].getchildren()[0].text.strip()

rs.loc[i,'name'] = rows[i].getchildren()[1].getchildren()[1].text.strip()

rs.loc[i,'link'] = rows[i].getchildren()[1].getchildren()[1].attrib['href'].strip()

rs.loc[i,'males'] = rows[i].getchildren()[2].getchildren()[2].text.strip()

rs.loc[i,'females'] = rows[i].getchildren()[2].getchildren()[0].text.strip()

rs.loc[i,'rus'] = rows[i].getchildren()[3].getchildren()[3].text.strip()

rs.loc[i,'total'] = rows[i].getchildren()[3].text_content().split('/')[1].strip()

Voici le résultat: Enregistrez ce bloc de données dans un fichier. J'utilise des cornichons , mais ça pourrait être csv , ou autre chose.import pickle as pkl

with open(r'D:\tri\summary.pkl', 'wb') as f:

pkl.dump(df,f)

À ce stade, toutes les données sont de type chaîne. Nous nous convertirons plus tard. La chose la plus importante dont nous avons besoin maintenant est des liens. Nous les utiliserons pour gratter les protocoles de toutes les races. Nous le faisons à l'image et à la manière dont cela a été fait pour le tableau croisé dynamique. Dans le cycle de toutes les courses pour chacune, nous allons ouvrir la page par référence, faire défiler et obtenir le code de la page. Dans le tableau récapitulatif, nous avons des informations sur le nombre total de participants à la course - total, nous allons l'utiliser pour comprendre jusqu'à quel point vous devez continuer à faire défiler. Pour ce faire, nous allons directement en train de gratter chaque page déterminer le nombre d'enregistrements dans le tableau et le comparer avec la valeur attendue du total. Dès qu'il est égal, nous avons défilé jusqu'à la fin et vous pouvez passer à la prochaine course. Nous avons également défini un délai d'expiration de 60 secondes. A mangé pendant ce temps, on n'arrive pas au total , on passe à la prochaine course. Le code de page sera enregistré dans un fichier. Nous allons enregistrer les fichiers de toutes les courses dans un dossier et les nommer par le nom des courses, c'est-à-dire par la valeur dans la colonne des événements du tableau récapitulatif. Pour éviter un conflit de noms, il est nécessaire que toutes les races aient des noms différents dans le tableau croisé dynamique. Vérifiez ça:df[df.duplicated(subset = 'event', keep=False)]

service.start()

driver = webdriver.Remote(service.service_url)

timeout = 60

for index, row in df.iterrows():

try:

driver.get('http://www.tristats.ru' + row['link'])

start = time.time()

while True:

driver.execute_script("window.scrollTo(0, document.body.scrollHeight);")

time.sleep(1)

race_html = driver.page_source

tree = html.fromstring(race_html)

race_rows = tree.findall(".//*[@ng-repeat='r in resultsData']")

if len(race_rows) == int(row['total']):

break

if time.time() - start > timeout:

print('timeout')

break

with open(os.path.join(r'D:\tri\races', row['event'] + '.txt'), 'w') as f:

f.write(race_html)

except:

traceback.print_exc()

time.sleep(1)

driver.quit()

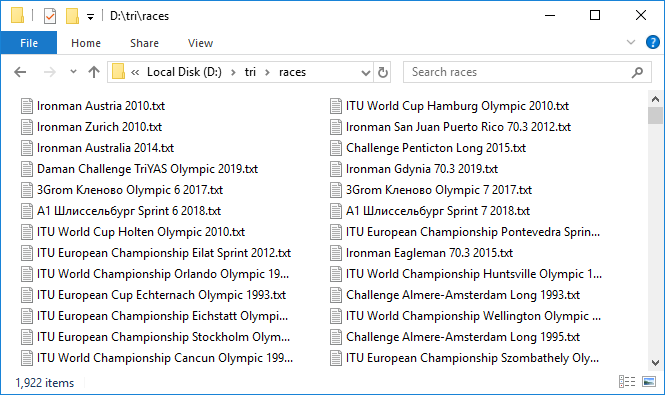

C'est un long processus. Mais lorsque tout est mis en place et que ce mécanisme lourd commence à tourner, en ajoutant des fichiers de données les uns après les autres, une sensation d'excitation agréable vient. Seuls environ trois protocoles sont chargés par minute, très lentement. Laissé tourner pour la nuit. Cela a pris environ 10 heures. Le matin, la plupart des protocoles ont été téléchargés. Comme cela se produit généralement lorsque vous travaillez avec un réseau, quelques-uns échouent. Les a rapidement repris avec une deuxième tentative. Nous avons donc 1 922 fichiers avec une capacité totale de près de 3 Go. Cool! Mais la gestion de près de 300 courses s'est terminée par un temps mort. Que se passe-t-il? Vérifiez de manière sélective, il s'avère qu'en effet la valeur totale du tableau croisé dynamique et le nombre d'entrées dans le protocole de course que nous avons vérifié peuvent ne pas coïncider. C'est triste, car il n'est pas clair quelle est la raison de cet écart. Soit cela est dû au fait que tout le monde ne finira pas, soit à une sorte de bogue dans la base de données. En général, le premier signal d'imperfection des données. Dans tous les cas, nous vérifions ceux dans lesquels le nombre d'entrées est de 100 ou 0, ce sont les candidats les plus suspects. Il y en avait huit. Téléchargez-les à nouveau sous contrôle strict. Soit dit en passant, dans deux d'entre eux, il y a en fait 100 entrées.Eh bien, nous avons toutes les données. Nous passons à l'analyse. Encore une fois, dans un cycle, nous allons parcourir chaque course, lire le fichier et enregistrer le contenu dans un pandas DataFrame . Nous allons combiner ces trames de données dans un dict , dans lequel les noms des courses sont les clés - c'est-à-dire les valeurs d' événement du tableau croisé dynamique ou les noms des fichiers avec le code html des pages de course, ils coïncident.

Nous avons donc 1 922 fichiers avec une capacité totale de près de 3 Go. Cool! Mais la gestion de près de 300 courses s'est terminée par un temps mort. Que se passe-t-il? Vérifiez de manière sélective, il s'avère qu'en effet la valeur totale du tableau croisé dynamique et le nombre d'entrées dans le protocole de course que nous avons vérifié peuvent ne pas coïncider. C'est triste, car il n'est pas clair quelle est la raison de cet écart. Soit cela est dû au fait que tout le monde ne finira pas, soit à une sorte de bogue dans la base de données. En général, le premier signal d'imperfection des données. Dans tous les cas, nous vérifions ceux dans lesquels le nombre d'entrées est de 100 ou 0, ce sont les candidats les plus suspects. Il y en avait huit. Téléchargez-les à nouveau sous contrôle strict. Soit dit en passant, dans deux d'entre eux, il y a en fait 100 entrées.Eh bien, nous avons toutes les données. Nous passons à l'analyse. Encore une fois, dans un cycle, nous allons parcourir chaque course, lire le fichier et enregistrer le contenu dans un pandas DataFrame . Nous allons combiner ces trames de données dans un dict , dans lequel les noms des courses sont les clés - c'est-à-dire les valeurs d' événement du tableau croisé dynamique ou les noms des fichiers avec le code html des pages de course, ils coïncident.rd = {}

for e in rs['event']:

place = []

... sex = [], name=..., country, group, place_in_group, swim, t1, bike, t2, run

result = []

with open(os.path.join(r'D:\tri\races', e + '.txt'), 'r')

race_html = f.read()

tree = html.fromstring(race_html)

rows = tree.findall(".//*[@ng-repeat='r in resultsData']")

for j in range(len(rows)):

row = rows[j]

parts = row.text_content().split('\n')

parts = [r.strip() for r in parts if r.strip() != '']

place.append(parts[0])

if len([a for a in row.findall('.//i')]) > 0:

sex.append([a for a in row.findall('.//i')][0].attrib['ng-if'][10:-1])

else:

sex.append('')

name.append(parts[1])

if len(parts) > 10:

country.append(parts[2].strip())

k=0

else:

country.append('')

k=1

group.append(parts[3-k])

... place_in_group.append(...), swim.append ..., t1, bike, t2, run

result.append(parts[10-k])

race = pd.DataFrame()

race['place'] = place

... race['sex'] = sex, race['name'] = ..., 'country', 'group', 'place_in_group', 'swim', ' t1', 'bike', 't2', 'run'

race['result'] = result

rd[e] = race

with open(r'D:\tri\details.pkl', 'wb') as f:

pkl.dump(rd,f)

for index, row in rs.iterrows():

e = row['event']

with open(os.path.join(r'D:\tri\races', e + '.txt'), 'r') as f:

race_html = f.read()

tree = html.fromstring(race_html)

header_elem = [tb for tb in tree.findall('.//tbody') if tb.getchildren()[0].getchildren()[0].text == ''][0]

location = header_elem.getchildren()[1].getchildren()[1].text.strip()

rs.loc[index, 'loc'] = location

with open(r'D:\tri\summary1.pkl', 'wb') as f:

pkl.dump(df,f)

Partie 2. Casting et formatage des types

Nous avons donc téléchargé toutes les données et les avons placées dans les trames de données. Cependant, toutes les valeurs sont de type str . Cela s'applique à la date, aux résultats, à l'emplacement et à tous les autres paramètres. Tous les paramètres doivent être convertis dans les types appropriés.Commençons par le tableau croisé dynamique.date et l'heure

événement , loc et lien seront laissés tels quels. date convertie en pandas datetime comme suit:rs['date'] = pd.to_datetime(rs['date'])

Les autres sont convertis en un type entier:cols = ['males', 'females', 'rus', 'total']

rs[cols] = rs[cols].astype(int)

Tout s'est bien passé, aucune erreur n'est survenue. Donc tout va bien - sauf:with open(r'D:\tri\summary2.pkl', 'wb') as f:

pkl.dump(rs, f)

Maintenant, les trames de données de course. Étant donné que toutes les races sont plus pratiques et plus rapides à traiter en même temps, et pas une à la fois, nous les collecterons dans un grand bloc de données ar (abrégé pour tous les enregistrements ) en utilisant la méthode concat .ar = pd.concat(rd)

ar contient 1 416 365 entrées.Convertissez maintenant place et place en groupe en une valeur entière.ar[['place', 'place in group']] = ar[['place', 'place in group']].astype(int))

Ensuite, nous traitons les colonnes avec des valeurs temporaires. Nous les moulerons dans le type Timedelta des pandas . Mais pour que la conversion réussisse, vous devez préparer correctement les données. Vous pouvez voir que certaines valeurs inférieures à une heure vont sans spécifier le conseil. Besoin de l'ajouter.for col in ['swim', 't1', 'bike', 't2', 'run', 'result']:

strlen = ar[col].str.len()

ar.loc[strlen==5, col] = '0:' + ar.loc[strlen==5, col]

ar.loc[strlen==4, col] = '0:0' + ar.loc[strlen==4, col]

Maintenant, les temps, les chaînes restantes, ressemblent à ceci: Convertir en Timedelta :for col in ['swim', 't1', 'bike', 't2', 'run', 'result']:

ar[col] = pd.to_timedelta(ar[col])

Sol

Passez. Vérifiez que dans la colonne sexe il n'y a que les valeurs de M et F :ar['sex'].unique()

Out: ['M', 'F', '']

En fait, il y a toujours une chaîne vide, c'est-à-dire que le sexe n'est pas spécifié. Voyons combien de tels cas:len(ar[ar['sex'] == ''])

Out: 2538

Pas tant que ça, c'est bien. À l'avenir, nous essaierons de réduire encore cette valeur. En attendant, laissez la colonne sexe telle quelle sous forme de lignes. Nous enregistrerons le résultat avant de passer à des transformations plus sérieuses et risquées. Afin de maintenir la continuité entre les fichiers, nous transformons la trame de données combinée ar en dictionnaire de trames de données rd :for event in ar.index.get_level_values(0).unique():

rd[event] = ar.loc[event]

with open(r'D:\tri\details1.pkl', 'wb') as f:

pkl.dump(rd,f)

Soit dit en passant, en raison de la conversion des types de certaines colonnes, la taille des fichiers est passée de 367 Ko à 295 Ko pour le tableau croisé dynamique et de 251 Mo à 168 Mo pour les protocoles de course.Code postal

Voyons maintenant le pays.ar['country'].unique()

Out: ['CRO', 'CZE', 'SLO', 'SRB', 'BUL', 'SVK', 'SWE', 'BIH', 'POL', 'MK', 'ROU', 'GRE', 'FRA', 'HUN', 'NOR', 'AUT', 'MNE', 'GBR', 'RUS', 'UAE', 'USA', 'GER', 'URU', 'CRC', 'ITA', 'DEN', 'TUR', 'SUI', 'MEX', 'BLR', 'EST', 'NED', 'AUS', 'BGI', 'BEL', 'ESP', 'POR', 'UKR', 'CAN', 'IRL', 'JPN', 'HKG', 'JEY', 'SGP', 'BRA', 'QAT', 'LUX', 'RSA', 'NZL', 'LAT', 'PHI', 'KSA', 'SEY', 'MAS', 'OMA', 'ARG', 'ECU', 'THA', 'JOR', 'BRN', 'CIV', 'FIN', 'IRN', 'BER', 'LBA', 'KUW', 'LTU', 'SRI', 'HON', 'INA', 'LBN', 'PAN', 'EGY', 'MLT', 'WAL', 'ISL', 'CYP', 'DOM', 'IND', 'VIE', 'MRI', 'AZE', 'MLD', 'LIE', 'VEN', 'ALG', 'SYR', 'MAR', 'KZK', 'PER', 'COL', 'IRQ', 'PAK', 'CZK', 'KAZ', 'CHN', 'NEP', 'ISR', 'MKD', 'FRO', 'BAN', 'ARU', 'CPV', 'ALB', 'BIZ', 'TPE', 'KGZ', 'BNN', 'CUB', 'SNG', 'VTN', 'THI', 'PRG', 'KOR', 'RE', 'TW', 'VN', 'MOL', 'FRE', 'AND', 'MDV', 'GUA', 'MON', 'ARM', 'F.I.TRI.', 'BAHREIN', 'SUECIA', 'REPUBLICA CHECA', 'BRASIL', 'CHI', 'MDA', 'TUN', 'NDL', 'Danish(Dane)', 'Welsh', 'Austrian', 'Unknown', 'AFG', 'Argentinean', 'Pitcairn', 'South African', 'Greenland', 'ESTADOS UNIDOS', 'LUXEMBURGO', 'SUDAFRICA', 'NUEVA ZELANDA', 'RUMANIA', 'PM', 'BAH', 'LTV', 'ESA', 'LAB', 'GIB', 'GUT', 'SAR', 'ita', 'aut', 'ger', 'esp', 'gbr', 'hun', 'den', 'usa', 'sui', 'slo', 'cze', 'svk', 'fra', 'fin', 'isr', 'irn', 'irl', 'bel', 'ned', 'sco', 'pol', 'SMR', 'mex', 'STEEL T BG', 'KINO MANA', 'IVB', 'TCH', 'SCO', 'KEN', 'BAS', 'ZIM', 'Joe', 'PUR', 'SWZ', 'Mark', 'WLS', 'MYA', 'BOT', 'REU', 'NAM', 'NCL', 'BOL', 'GGY', 'ISV', 'TWN', 'GUM', 'FIJ', 'COK', 'NGR', 'IRI', 'GAB', 'ANT', 'GEO', 'COG', 'sue', 'SUD', 'BAR', 'CAY', 'BO', 'VE', 'AX', 'MD', 'PAR', 'UM', 'SEN', 'NIG', 'RWA', 'YEM', 'PLE', 'GHA', 'ITU', 'UZB', 'MGL', 'MAC', 'DMA', 'TAH', 'TTO', 'AHO', 'JAM', 'SKN', 'GRN', 'PRK', 'NFK', 'SOL', 'Sandy', 'SAM', 'PNG', 'SGS', 'Suchy, Jorg', 'SOG', 'GEQ', 'BVT', 'DJI', 'CHA', 'ANG', 'YUG', 'IOT', 'HAI', 'SJM', 'CUW', 'BHU', 'ERI', 'FLK', 'HMD', 'GUF', 'ESH', 'sandy', 'UMI', 'selsmark, 'Alise', 'Eddie', '31/3, Colin', 'CC', '', '', '', '', '', ' ', '', '', '', '-', '', 'GRL', 'UGA', 'VAT', 'ETH', 'ASA', 'PYF', 'ATA', 'ALA', 'MTQ', 'ZZ', 'CXR', 'AIA', 'TJK', 'GUY', 'KR', 'PF', 'BN', 'MO', 'LA', 'CAM', 'NCA', 'ZAM', 'MAD', 'TOG', 'VIR', 'ATF', 'VAN', 'SLE', 'GLP', 'SCG', 'LAO', 'IMN', 'BUR', 'IR', 'SY', 'CMR', 'GBS', 'SUR', 'MOZ', 'BLM', 'MSR', 'CAF', 'BEN', 'COD', 'CCK', 'TUV', 'TGA', 'GI', 'XKX', 'NRU', 'NC', 'LBR', 'TAN', 'VIN', 'SSD', 'GP', 'PS', 'IM', 'JE', '', 'MLI', 'FSM', 'LCA', 'GMB', 'MHL', 'NH', 'FL', 'CT', 'UT', 'AQ', 'Korea', 'Taiwan', 'NewCaledonia', 'Czech Republic', 'PLW', 'BRU', 'RUN', 'NIU', 'KIR', 'SOM', 'TKM', 'SPM', 'BDI', 'COM', 'TCA', 'SHN', 'DO2', 'DCF', 'PCN', 'MNP', 'MYT', 'SXM', 'MAF', 'GUI', 'AN', 'Slovak republic', 'Channel Islands', 'Reunion', 'Wales', 'Scotland', 'ica', 'WLF', 'D', 'F', 'I', 'B', 'L', 'E', 'A', 'S', 'N', 'H', 'R', 'NU', 'BES', 'Bavaria', 'TLS', 'J', 'TKL', 'Tirol"', 'P', '?????', 'EU', 'ES-IB', 'ES-CT', '', 'SOO', 'LZE', '', '', '', '', '', '']

412 valeurs uniques.Fondamentalement, un pays est indiqué par un code alphabétique à trois chiffres en majuscules. Mais apparemment, pas toujours. En fait, il existe une norme internationale ISO 3166 , dans laquelle pour tous les pays, y compris même ceux qui n'existent plus, les codes à trois et à deux chiffres correspondants sont prescrits. Pour python, l' une des implémentations de cette norme peut être trouvée dans le paquet pycountry . Voici comment ça fonctionne:import pycountry as pyco

pyco.countries.get(alpha_3 = 'RUS')

Out: Country(alpha_2='RU', alpha_3='RUS', name='Russian Federation', numeric='643')

Ainsi, nous allons vérifier tous les codes à trois chiffres, conduisant à des majuscules, qui donnent une réponse dans countries.get (...) et historical_countries.get (...) :valid_a3 = [c for c in ar['country'].unique() if pyco.countries.get(alpha_3 = c.upper()) != None or pyco.historic_countries.get(alpha_3 = c.upper()) != None])

Il y en avait 190 sur 412, soit moins de la moitié.Pour les 222 restants (nous désignons leur liste par tofix ), nous créerons un dictionnaire de correspondance de correctifs , dans lequel la clé sera le nom d'origine et la valeur sera un code à trois chiffres selon la norme ISO.tofix = list(set(ar['country'].unique()) - set(valid_a3))

Tout d'abord, vérifiez les codes à deux chiffres avec pycountry.countries.get (alpha_2 = ...) , ce qui conduit à des majuscules:for icc in tofix:

if pyco.countries.get(alpha_2 = icc.upper()) != None:

fix[icc] = pyco.countries.get(alpha_2 = icc.upper()).alpha_3

else:

if pyco.historic_countries.get(alpha_2 = icc.upper()) != None:

fix[icc] = pyco.historic_countries.get(alpha_2 = icc.upper()).alpha_3

Ensuite, les noms complets via pycountry.countries.get (nom = ...), pycountry.countries.get (common_name = ...) , les menant à la forme str.title () :for icc in tofix:

if pyco.countries.get(common_name = icc.title()) != None:

fix[icc] = pyco.countries.get(common_name = icc.title()).alpha_3

else:

if pyco.countries.get(name = icc.title()) != None:

fix[icc] = pyco.countries.get(name = icc.title()).alpha_3

else:

if pyco.historic_countries.get(name = icc.title()) != None:

fix[icc] = pyco.historic_countries.get(name = icc.title()).alpha_3

Ainsi, nous réduisons le nombre de valeurs non reconnues à 190. Encore beaucoup: vous remarquerez peut-être qu'il existe encore de nombreux codes à trois chiffres, mais ce n'est pas un ISO. Et alors? Il s'avère qu'il existe une autre norme - olympique . Malheureusement, son implémentation n'est pas incluse dans pycountry et vous devez chercher autre chose. La solution a été trouvée sous la forme d'un fichier csv sur datahub.io . Placez le contenu de ce fichier dans un DataFrame pandas appelé cdf . ioc - Comité olympique international (CIO)['URU', '', 'PAR', 'SUECIA', 'KUW', 'South African', '', 'Austrian', 'ISV', 'H', 'SCO', 'ES-CT', ', 'GUI', 'BOT', 'SEY', 'BIZ', 'LAB', 'PUR', ' ', 'Scotland', '', '', 'TCH', 'TGA', 'UT', 'BAH', 'GEQ', 'NEP', 'TAH', 'ica', 'FRE', 'E', 'TOG', 'MYA', '', 'Danish (Dane)', 'SAM', 'TPE', 'MON', 'ger', 'Unknown', 'sui', 'R', 'SUI', 'A', 'GRN', 'KZK', 'Wales', '', 'GBS', 'ESA', 'Bavaria', 'Czech Republic', '31/3, Colin', 'SOL', 'SKN', '', 'MGL', 'XKX', 'WLS', 'MOL', 'FIJ', 'CAY', 'ES-IB', 'BER', 'PLE', 'MRI', 'B', 'KSA', '', '', 'LAT', 'GRE', 'ARU', '', 'THI', 'NGR', 'MAD', 'SOG', 'MLD', '?????', 'AHO', 'sco', 'UAE', 'RUMANIA', 'CRO', 'RSA', 'NUEVA ZELANDA', 'KINO MANA', 'PHI', 'sue', 'Tirol"', 'IRI', 'POR', 'CZK', 'SAR', 'D', 'BRASIL', 'DCF', 'HAI', 'ned', 'N', 'BAHREIN', 'VTN', 'EU', 'CAM', 'Mark', 'BUL', 'Welsh', 'VIN', 'HON', 'ESTADOS UNIDOS', 'I', 'GUA', 'OMA', 'CRC', 'PRG', 'NIG', 'BHU', 'Joe', 'GER', 'RUN', 'ALG', '', 'Channel Islands', 'Reunion', 'REPUBLICA CHECA', 'slo', 'ANG', 'NewCaledonia', 'GUT', 'VIE', 'ASA', 'BAR', 'SRI', 'L', '', 'J', 'BAS', 'LUXEMBURGO', 'S', 'CHI', 'SNG', 'BNN', 'den', 'F.I.TRI.', 'STEEL T BG', 'NCA', 'Slovak republic', 'MAS', 'LZE', '-', 'F', 'BRU', '', 'LBA', 'NDL', 'DEN', 'IVB', 'BAN', 'Sandy', 'ZAM', 'sandy', 'Korea', 'SOO', 'BGI', '', 'LTV', 'selsmark, Alise', 'TAN', 'NED', '', 'Suchy, Jorg', 'SLO', 'SUDAFRICA', 'ZIM', 'Eddie', 'INA', '', 'SUD', 'VAN', 'FL', 'P', 'ITU', 'ZZ', 'Argentinean', 'CHA', 'DO2', 'WAL']

len(([x for x in tofix if x.upper() in list(cdf['ioc'])]))

Out: 82

Parmi les codes à trois chiffres de tofix, 82 IOC correspondants ont été trouvés. Ajoutez-les à notre dictionnaire correspondant.for icc in tofix:

if icc.upper() in list(cdf['ioc']):

ind = cdf[cdf['ioc'] == icc.upper()].index[0]

fix[icc] = cdf.loc[ind, 'iso3']

Il reste 108 valeurs brutes. Ils sont terminés manuellement, se tournant parfois vers Google pour obtenir de l'aide. Mais même le contrôle manuel ne résout pas complètement le problème. Il reste 49 valeurs qui sont déjà impossibles à interpréter. La plupart de ces valeurs ne sont probablement que des erreurs de données.{'BGI': 'BRB', 'WAL': 'GBR', 'MLD': 'MDA', 'KZK': 'KAZ', 'CZK': 'CZE', 'BNN': 'BEN', 'SNG': 'SGP', 'VTN': 'VNM', 'THI': 'THA', 'PRG': 'PRT', 'MOL': 'MDA', 'FRE': 'FRA', 'F.I.TRI.': 'ITA', 'BAHREIN': 'BHR', 'SUECIA': 'SWE', 'REPUBLICA CHECA': 'CZE', 'BRASIL': 'BRA', 'NDL': 'NLD', 'Danish (Dane)': 'DNK', 'Welsh': 'GBR', 'Austrian': 'AUT', 'Argentinean': 'ARG', 'South African': 'ZAF', 'ESTADOS UNIDOS': 'USA', 'LUXEMBURGO': 'LUX', 'SUDAFRICA': 'ZAF', 'NUEVA ZELANDA': 'NZL', 'RUMANIA': 'ROU', 'sco': 'GBR', 'SCO': 'GBR', 'WLS': 'GBR', '': 'IND', '': 'IRL', '': 'ARM', '': 'BGR', '': 'SRB', ' ': 'BLR', '': 'GBR', '': 'FRA', '': 'HND', '-': 'CRI', '': 'AZE', 'Korea': 'KOR', 'NewCaledonia': 'FRA', 'Czech Republic': 'CZE', 'Slovak republic': 'SVK', 'Channel Islands': 'FRA', 'Reunion': 'FRA', 'Wales': 'GBR', 'Scotland': 'GBR', 'Bavaria': 'DEU', 'Tirol"': 'AUT', '': 'KGZ', '': 'BLR', '': 'BLR', '': 'BLR', '': 'RUS', '': 'BLR', '': 'RUS'}

unfixed = [x for x in tofix if x not in fix.keys()]

Out: ['', 'H', 'ES-CT', 'LAB', 'TCH', 'UT', 'TAH', 'ica', 'E', 'Unknown', 'R', 'A', '31/3, Colin', 'XKX', 'ES-IB','B','SOG','?????','KINO MANA','sue','SAR','D', 'DCF', 'N', 'EU', 'Mark', 'I', 'Joe', 'RUN', 'GUT', 'L', 'J', 'BAS', 'S', 'STEEL T BG', 'LZE', 'F', 'Sandy', 'DO2', 'sandy', 'SOO', 'LTV', 'selsmark, Alise', 'Suchy, Jorg' 'Eddie', 'FL', 'P', 'ITU', 'ZZ']

Ces clés auront une chaîne vide dans le dictionnaire correspondant.for cc in unfixed:

fix[cc] = ''

Enfin, nous ajoutons aux codes du dictionnaire correspondants qui sont valides mais écrits en minuscules.for cc in valid_a3:

if cc.upper() != cc:

fix[cc] = cc.upper()

Il est maintenant temps d'appliquer les remplacements trouvés. Pour enregistrer les données initiales de comparaison plus loin, copier le pays colonne à cru du pays . Ensuite, en utilisant le dictionnaire de correspondance créé, nous corrigeons les valeurs de la colonne pays qui ne correspondent pas à ISO.for cc in fix:

ind = ar[ar['country'] == cc].index

ar.loc[ind,'country'] = fix[cc]

Ici, bien sûr, on ne peut pas se passer de vectorisation, le tableau compte près d'un million et demi de lignes. Mais selon le dictionnaire, nous faisons un cycle, mais comment d'autre? Vérifiez le nombre d'enregistrements modifiés:len(ar[ar['country'] != ar['country raw']])

Out: 315955

c'est-à-dire plus de 20% du total.ar[ar['country'] != ar['country raw']].sample(10)

len(ar[ar['country'] == ''])

Out: 3221

Il s'agit du nombre d'enregistrements sans pays ou avec un pays informel. Le nombre de pays uniques est passé de 412 à 250. Les voici: Désormais, il n'y a plus d'écart. Nous enregistrons le résultat dans un nouveau fichier details2.pkl , après avoir reconverti la trame de données combinée en un dictionnaire de trames de données, comme cela a été fait précédemment.['', 'ABW', 'AFG', 'AGO', 'AIA', 'ALA', 'ALB', 'AND', 'ANT', 'ARE', 'ARG', 'ARM', 'ASM', 'ATA', 'ATF', 'AUS', 'AUT', 'AZE', 'BDI', 'BEL', 'BEN', 'BES', 'BGD', 'BGR', 'BHR', 'BHS', 'BIH', 'BLM', 'BLR', 'BLZ', 'BMU', 'BOL', 'BRA', 'BRB', 'BRN', 'BTN', 'BUR', 'BVT', 'BWA', 'CAF', 'CAN', 'CCK', 'CHE', 'CHL', 'CHN', 'CIV', 'CMR', 'COD', 'COG', 'COK', 'COL', 'COM', 'CPV', 'CRI', 'CTE', 'CUB', 'CUW', 'CXR', 'CYM', 'CYP', 'CZE', 'DEU', 'DJI', 'DMA', 'DNK', 'DOM', 'DZA', 'ECU', 'EGY', 'ERI', 'ESH', 'ESP', 'EST', 'ETH', 'FIN', 'FJI', 'FLK', 'FRA', 'FRO', 'FSM', 'GAB', 'GBR', 'GEO', 'GGY', 'GHA', 'GIB', 'GIN', 'GLP', 'GMB', 'GNB', 'GNQ', 'GRC', 'GRD', 'GRL', 'GTM', 'GUF', 'GUM', 'GUY', 'HKG', 'HMD', 'HND', 'HRV', 'HTI', 'HUN', 'IDN', 'IMN', 'IND', 'IOT', 'IRL', 'IRN', 'IRQ', 'ISL', 'ISR', 'ITA', 'JAM', 'JEY', 'JOR', 'JPN', 'KAZ', 'KEN', 'KGZ', 'KHM', 'KIR', 'KNA', 'KOR', 'KWT', 'LAO', 'LBN', 'LBR', 'LBY', 'LCA', 'LIE', 'LKA', 'LTU', 'LUX', 'LVA', 'MAC', 'MAF', 'MAR', 'MCO', 'MDA', 'MDG', 'MDV', 'MEX', 'MHL', 'MKD', 'MLI', 'MLT', 'MMR', 'MNE', 'MNG', 'MNP', 'MOZ', 'MSR', 'MTQ', 'MUS', 'MYS', 'MYT', 'NAM', 'NCL', 'NER', 'NFK', 'NGA', 'NHB', 'NIC', 'NIU', 'NLD', 'NOR', 'NPL', 'NRU', 'NZL', 'OMN', 'PAK', 'PAN', 'PCN', 'PER', 'PHL', 'PLW', 'PNG', 'POL', 'PRI', 'PRK', 'PRT', 'PRY', 'PSE', 'PYF', 'QAT', 'REU', 'ROU', 'RUS', 'RWA', 'SAU', 'SCG', 'SDN', 'SEN', 'SGP', 'SGS', 'SHN', 'SJM', 'SLB', 'SLE', 'SLV', 'SMR', 'SOM', 'SPM', 'SRB', 'SSD', 'SUR', 'SVK', 'SVN', 'SWE', 'SWZ', 'SXM', 'SYC', 'SYR', 'TCA', 'TCD', 'TGO', 'THA', 'TJK', 'TKL', 'TKM', 'TLS', 'TON', 'TTO', 'TUN', 'TUR', 'TUV', 'TWN', 'TZA', 'UGA', 'UKR', 'UMI', 'URY', 'USA', 'UZB', 'VAT', 'VCT', 'VEN', 'VGB', 'VIR', 'VNM', 'VUT', 'WLF', 'WSM', 'YEM', 'YUG', 'ZAF', 'ZMB', 'ZWE']

Emplacement

Rappelons maintenant que la mention des pays figure également dans le tableau croisé dynamique, dans la colonne loc . Il doit également être ramené à un aspect standard. Voici une histoire légèrement différente: ni l'ISO ni les codes olympiques ne sont visibles. Tout est décrit sous une forme assez libre. La ville, le pays et les autres composants de l'adresse sont répertoriés avec une virgule et dans un ordre aléatoire. Quelque part en premier lieu, quelque part en dernier. pycountry n'aidera pas ici. Et il y a beaucoup de records - pour la course de 1922 525 emplacements uniques (dans sa forme originale). Mais ici, un outil approprié a été trouvé. C'est la géopie , à savoir le géolocalisateur Nominatim . Cela fonctionne comme ceci:from geopy.geocoders import Nominatim

geolocator = Nominatim(user_agent='triathlon results researcher')

geolocator.geocode(' , , ', language='en')

Out: Location( , – , , Altaysky District, Altai Krai, Siberian Federal District, Russia, (51.78897945, 85.73956296106752, 0.0))

Sur demande, sous une forme aléatoire, il donne une réponse structurée - adresse et coordonnées. Si vous définissez la langue, comme ici - l'anglais, alors ce qu'elle peut - se traduira. Tout d'abord, nous avons besoin du nom standard du pays pour une traduction ultérieure dans le code ISO. Il prend juste la dernière place dans la propriété d' adresse . Étant donné que le géolocalisateur envoie une demande au serveur à chaque fois, ce processus n'est pas rapide et prend 500 minutes pour 500 enregistrements. De plus, il arrive que la réponse ne vienne pas. Dans ce cas, une deuxième demande aide parfois. Dans ma première réponse, je n'ai pas reçu 130 demandes. La plupart d'entre eux ont été traités avec deux nouvelles tentatives. Cependant, 34 noms n'ont pas été traités, même par plusieurs nouvelles tentatives. Les voici:['Tongyeong, Korea, Korea, South', 'Constanta, Mamaia, Romania, Romania', 'Weihai, China, China', '. , .', 'Odaiba Marin Park, Tokyo, Japan, Japan', 'Sweden, Smaland, Kalmar', 'Cholpon-Ata city, Resort Center "Kapriz", Kyrgyzstan', 'Luxembourg, Region Moselle, Moselle', 'Chita Peninsula, Japan', 'Kraichgau Region, Germany', 'Jintang, Chengdu, Sichuan Province, China, China', 'Madrid, Spain, Spain', 'North American Pro Championship, St. George, Utah, USA', 'Milan Idroscalo Linate, Italy', 'Dexing, Jiangxi Province, China, China', 'Mooloolaba, Australia, Australia', 'Nathan Benderson Park (NBP), 5851 Nathan Benderson Circle, Sarasota, FL 34235., United States', 'Strathclyde Country Park, North Lanarkshire, Glasgow, Great Britain', 'Quijing, China', 'United States of America , Hawaii, Kohala Coast', 'Buffalo City, East London, South Africa', 'Spain, Vall de Cardener', ', . ', 'Asian TriClub Championship, Hefei, China', 'Taizhou, Jiangsu Province, China, China', ', , «»', 'Buffalo, Gallagher Beach, Furhmann Blvd, United States', 'North American Pro Championship | St. George, Utah, USA', 'Weihai, Shandong, China, China', 'Tarzo - Revine Lago, Italy', 'Lausanee, Switzerland', 'Queenstown, New Zealand, New Zealand', 'Makuhari, Japan, Japan', 'Szombathlely, Hungary']

On peut voir que dans beaucoup, il y a une double mention du pays, et cela interfère en fait. En général, j'ai dû traiter manuellement ces noms restants et les adresses standard ont été obtenues pour tous. De plus, à partir de ces adresses, j'ai sélectionné un pays et j'ai écrit ce pays dans une nouvelle colonne du tableau croisé dynamique. Comme, comme je l'ai dit, travailler avec geopy n'est pas rapide, j'ai décidé d'enregistrer immédiatement les coordonnées de l'emplacement - latitude et longitude. Ils seront utiles plus tard pour la visualisation sur la carte. Après cela, en utilisant pyco.countries.get (name = '...'). Alpha_3 a recherché le pays par son nom et lui a attribué un code à trois chiffres.Distance

Une autre action importante qui doit être effectuée sur le tableau croisé dynamique consiste à déterminer la distance pour chaque course. Cela nous est utile pour calculer les vitesses à l'avenir. Dans le triathlon, il y a quatre distances principales - sprint, olympique, semi-fer et fer. Vous pouvez voir que dans les noms des courses, il y a généralement une indication de la distance - ce sont Sprint , Olympic , Half , Full Words . De plus, différents organisateurs ont leurs propres désignations de distances. La moitié de l'Ironman, par exemple, est désignée comme 70,3 - par le nombre de miles de distance, l'Olympic - 5150 par le nombre de kilomètres (51,5), et le fer peut être désigné comme Fullou, en général, comme un manque d'explication - par exemple, Ironman Arizona 2019 . Ironman - il est fer! Dans Challenge, la distance du fer est désignée comme longue et la distance semi- fer est désignée comme moyenne . Notre IronStar russe signifie plein comme 226 , et moitié comme 113 - par le nombre de kilomètres, mais généralement les mots plein et demi sont également présents. Appliquez maintenant toutes ces connaissances et marquez toutes les races conformément aux mots-clés présents dans les noms.sprints = rs.loc[[i for i in rs.index if 'sprint' in rs.loc[i, 'event'].lower()]]

olympics1 = rs.loc[[i for i in rs.index if 'olympic' in rs.loc[i, 'event'].lower()]]

olympics2 = rs.loc[[i for i in rs.index if '5150' in rs.loc[i, 'event'].lower()]]

olympics = pd.concat([olympics1, olympics2])

rsd = pd.concat([sprints, olympics, halfs, fulls])

En rsd, il s'est avéré 1 925 records, soit trois de plus que le nombre total de courses, donc certains tombaient sous deux critères. Regardons-les:rsd[rsd.duplicated(keep=False)]['event'].sort_index()

olympics.drop(65)

Nous ferons de même avec l'intersection Ironman Dun Laoghaire Full Swim 70.3 2019 Voici le meilleur temps à 4h00. C'est typique de la moitié. Supprimez l'enregistrement avec l'index 85 des pleins .fulls.drop(85)

Nous allons maintenant noter les informations de distance dans le bloc de données principal et voir ce qui s'est passé:rs['dist'] = ''

rs.loc[sprints.index,'dist'] = 'sprint'

rs.loc[olympics.index,'dist'] = 'olympic'

rs.loc[halfs.index,'dist'] = 'half'

rs.loc[fulls.index,'dist'] = 'full'

rs.sample(10)

len(rs[rs['dist'] == ''])

Out: 0

Et découvrez nos problèmes, ambigus:rs.loc[[38,65,82],['event','dist']]

pkl.dump(rs, open(r'D:\tri\summary5.pkl', 'wb'))

Les groupes d'âge

Revenons maintenant aux protocoles de course.Nous avons déjà analysé le sexe, le pays et les résultats du participant, et les avons amenés à une forme standard. Mais il restait encore deux colonnes - le groupe et, en fait, le nom lui-même. Commençons par les groupes. Dans le triathlon, il est habituel de diviser les participants par groupes d'âge. Un groupe de professionnels se distingue également souvent. En fait, le décalage est dans chacun de ces groupes séparément - les trois premières places de chaque groupe sont attribuées. En groupe, la qualification est sélectionnée pour les championnats, par exemple sur Konu.Combinez tous les enregistrements et voyez quels groupes existent généralement.rd = pkl.load(open(r'D:\tri\details2.pkl', 'rb'))

ar = pd.concat(rd)

ar['group'].unique()

Il s'est avéré qu'il y avait un grand nombre de groupes - 581. Une centaine de personnes sélectionnées au hasard ressemble à ceci: Voyons quels sont les plus nombreux:['MSenior', 'FAmat.', 'M20', 'M65-59', 'F25-29', 'F18-22', 'M75-59', 'MPro', 'F24', 'MCORP M', 'F21-30', 'MSenior 4', 'M40-50', 'FAWAD', 'M16-29', 'MK40-49', 'F65-70', 'F65-70', 'M12-15', 'MK18-29', 'M50up', 'FSEMIFINAL 2 PRO', 'F16', 'MWhite', 'MOpen 25-29', 'F', 'MPT TRI-2', 'M16-24', 'FQUALIFIER 1 PRO', 'F15-17', 'FSEMIFINAL 2 JUNIOR', 'FOpen 60-64', 'M75-80', 'F60-69', 'FJUNIOR A', 'F17-18', 'FAWAD BLIND', 'M75-79', 'M18-29', 'MJUN19-23', 'M60-up', 'M70', 'MPTS5', 'F35-40', "M'S PT1", 'M50-54', 'F65-69', 'F17-20', 'MP4', 'M16-29', 'F18up', 'MJU', 'MPT4', 'MPT TRI-3', 'MU24-39', 'MK35-39', 'F18-20', "M'S", 'F50-55', 'M75-80', 'MXTRI', 'F40-45', 'MJUNIOR B', 'F15', 'F18-19', 'M20-29', 'MAWAD PC4', 'M30-37', 'F21-30', 'Mpro', 'MSEMIFINAL 1 JUNIOR', 'M25-34', 'MAmat.', 'FAWAD PC5', 'FA', 'F50-60', 'FSenior 1', 'M80-84', 'FK45-49', 'F75-79', 'M<23', 'MPTS3', 'M70-75', 'M50-60', 'FQUALIFIER 3 PRO', 'M9', 'F31-40', 'MJUN16-19', 'F18-19', 'M PARA', 'F35-44', 'MParaathlete', 'F18-34', 'FA', 'FAWAD PC2', 'FAll Ages', 'M PARA', 'F31-40', 'MM85', 'M25-39']

ar['group'].value_counts()[:30]

Out:

M40-44 199157

M35-39 183738

M45-49 166796

M30-34 154732

M50-54 107307

M25-29 88980

M55-59 50659

F40-44 48036

F35-39 47414

F30-34 45838

F45-49 39618

MPRO 38445

F25-29 31718

F50-54 26253

M18-24 24534

FPRO 23810

M60-64 20773

M 12799

F55-59 12470

M65-69 8039

F18-24 7772

MJUNIOR 6605

F60-64 5067

M20-24 4580

FJUNIOR 4105

M30-39 3964

M40-49 3319

F 3306

M70-74 3072

F20-24 2522

Vous pouvez voir que ce sont des groupes de cinq ans, séparément pour les hommes et séparément pour les femmes, ainsi que les groupes professionnels MPRO et FPRO .Notre norme sera donc:ag = ['MPRO', 'M18-24', 'M25-29', 'M30-34', 'M35-39', 'M40-44', 'M45-49', 'M50-54', 'M55-59', 'M60-64', 'M65-69', 'M70-74', 'M75-79', 'M80-84', 'M85-90', 'FPRO', 'F18-24', 'F25-29', 'F30-34', 'F35-39', 'F40-44', 'F45-49', 'F50-54', 'F55-59', 'F60-64', 'F65-69', 'F70-74', 'F75-79', 'F80-84', 'F85-90']

Cet ensemble couvre près de 95% de tous les finisseurs.Bien sûr, nous ne pourrons pas amener tous les groupes à cette norme. Mais nous recherchons ceux qui leur sont similaires et en donnons au moins une partie. Tout d'abord, nous allons mettre en majuscule et supprimer les espaces. Voici ce qui s'est passé: convertissez-les en nos standards.['F25-29F', 'F30-34F', 'F30-34-34', 'F35-39F', 'F40-44F', 'F45-49F', 'F50-54F', 'F55-59F', 'FAG:FPRO', 'FK30-34', 'FK35-39', 'FK40-44', 'FK45-49', 'FOPEN50-54', 'FOPEN60-64', 'MAG:MPRO', 'MK30-34', 'MK30-39', 'MK35-39', 'MK40-44', 'MK40-49', 'MK50-59', 'M40-44', 'MM85-89', 'MOPEN25-29', 'MOPEN30-34', 'MOPEN35-39', 'MOPEN40-44', 'MOPEN45-49', 'MOPEN50-54', 'MOPEN70-74', 'MPRO:', 'MPROM', 'M0-44"']

fix = { 'F25-29F': 'F25-29', 'F30-34F' : 'F30-34', 'F30-34-34': 'F30-34', 'F35-39F': 'F35-39', 'F40-44F': 'F40-44', 'F45-49F': 'F45-49', 'F50-54F': 'F50-54', 'F55-59F': 'F55-59', 'FAG:FPRO': 'FPRO', 'FK30-34': 'F30-34', 'FK35-39': 'F35-39', 'FK40-44': 'F40-44', 'FK45-49': 'F45-49', 'FOPEN50-54': 'F50-54', 'FOPEN60-64': 'F60-64', 'MAG:MPRO': 'MPRO', 'MK30-34': 'M30-34', 'MK30-39': 'M30-39', 'MK35-39': 'M35-39', 'MK40-44': 'M40-44', 'MK40-49': 'M40-49', 'MK50-59': 'M50-59', 'M40-44': 'M40-44', 'MM85-89': 'M85-89', 'MOPEN25-29': 'M25-29', 'MOPEN30-34': 'M30-34', 'MOPEN35-39': 'M35-39', 'MOPEN40-44': 'M40-44', 'MOPEN45-49': 'M45-49', 'MOPEN50-54': 'M50-54', 'MOPEN70-74': 'M70- 74', 'MPRO:' :'MPRO', 'MPROM': 'MPRO', 'M0-44"' : 'M40-44'}

Maintenant, nous appliquons notre transformation au cadre de données principal ar , mais enregistrons d'abord les valeurs de groupe d' origine dans la nouvelle colonne brute de groupe .ar['group raw'] = ar['group']

Dans la colonne groupe , nous ne laissons que les valeurs conformes à notre norme.Nous pouvons maintenant apprécier nos efforts:len(ar[(ar['group'] != ar['group raw'])&(ar['group']!='')])

Out: 273

Juste un peu au niveau d'un million et demi. Mais vous ne le saurez pas avant d’essayer.Les 10 sélectionnés ressemblent à ceci: Enregistrez la nouvelle version du bloc de données, après l'avoir reconvertie dans le dictionnaire rd .pkl.dump(rd, open(r'D:\tri\details3.pkl', 'wb'))

Nom

Maintenant, prenons soin des noms. Voyons sélectivement 100 noms de races différentes:list(ar['name'].sample(100))

Out: ['Case, Christine', 'Van der westhuizen, Wouter', 'Grace, Scott', 'Sader, Markus', 'Schuller, Gunnar', 'Juul-Andersen, Jeppe', 'Nelson, Matthew', ' ', 'Westman, Pehr', 'Becker, Christoph', 'Bolton, Jarrad', 'Coto, Ricardo', 'Davies, Luke', 'Daniltchev, Alexandre', 'Escobar Labastida, Emmanuelle', 'Idzikowski, Jacek', 'Fairaislova Iveta', 'Fisher, Kulani', 'Didenko, Viktor', 'Osborne, Jane', 'Kadralinov, Zhalgas', 'Perkins, Chad', 'Caddell, Martha', 'Lynaire PARISH', 'Busing, Lynn', 'Nikitin, Evgeny', 'ANSON MONZON, ROBERTO', 'Kaub, Bernd', 'Bank, Morten', 'Kennedy, Ian', 'Kahl, Stephen', 'Vossough, Andreas', 'Gale, Karen', 'Mullally, Kristin', 'Alex FRASER', 'Dierkes, Manuela', 'Gillett, David', 'Green, Erica', 'Cunnew, Elliott', 'Sukk, Gaspar', 'Markina Veronika', 'Thomas KVARICS', 'Wu, Lewen', 'Van Enk, W.J.J', 'Escobar, Rosario', 'Healey, Pat', 'Scheef, Heike', 'Ancheta, Marlon', 'Heck, Andreas', 'Vargas Iii, Raul', 'Seferoglou, Maria', 'chris GUZMAN', 'Casey, Timothy', 'Olshanikov Konstantin', 'Rasmus Nerrand', 'Lehmann Bence', 'Amacker, Kirby', 'Parks, Chris', 'Tom, Troy', 'Karlsson, Ulf', 'Halfkann, Dorothee', 'Szabo, Gergely', 'Antipov Mikhail', 'Von Alvensleben, Alvo', 'Gruber, Peter', 'Leblanc, Jean-Philippe', 'Bouchard, Jean-Francois', 'Marchiotto MASSIMO', 'Green, Molly', 'Alder, Christoph', 'Morris, Huw', 'Deceur, Marc', 'Queenan, Derek', 'Krause, Carolin', 'Cockings, Antony', 'Ziehmer Chris', 'Stiene, John', 'Chmet Daniela', 'Chris RIORDAN', 'Wintle, Mel', ' ', 'GASPARINI CHRISTIAN', 'Westbrook, Christohper', 'Martens, Wim', 'Papson, Chris', 'Burdess, Shaun', 'Proctor, Shane', 'Cruzinha, Pedro', 'Hamard, Jacques', 'Petersen, Brett', 'Sahyoun, Sebastien', "O'Connell, Keith", 'Symoshenko, Zhan', 'Luternauer, Jan', 'Coronado, Basil', 'Smith, Alex', 'Dittberner, Felix', 'N?sman, Henrik', 'King, Malisa', 'PUHLMANN Andre']

C'est compliqué. Il existe une variété d'options pour les entrées: Prénom Nom de famille, Nom de famille Prénom, Nom de famille, Prénom, Nom de famille, Prénom , etc. Autrement dit, un ordre différent, un registre différent, quelque part il y a un séparateur - une virgule. Il existe également de nombreux protocoles dans lesquels va cyrillique. Il n'y a pas non plus d'uniformité, et de tels formats peuvent être trouvés: «Nom Prénom», «Prénom Nom», «Prénom Second prénom Nom», «Nom Prénom Deuxième prénom». Bien qu'en fait, le deuxième prénom se trouve également dans l'orthographe latine. Et ici, en passant, un autre problème se pose - la translittération. Il convient également de noter que même en l'absence de deuxième prénom, l'enregistrement peut ne pas être limité à deux mots. Par exemple, pour les Hispaniques, le nom plus le nom de famille se compose généralement de trois ou quatre mots. Les Néerlandais ont le préfixe Van, les Chinois et les Coréens ont également des noms composés généralement de trois mots. En général, vous devez en quelque sorte démêler tout ce rébus et le normaliser au maximum. En règle générale, au sein d'une course, le format du nom est le même pour tout le monde, mais même ici, il y a des erreurs que nous ne traiterons pas. Commençons par stocker les valeurs existantes dans le nouveau nom de colonne raw :ar['name raw'] = ar['name']

La grande majorité des protocoles sont en latin, donc la première chose que je voudrais faire est la translittération. Voyons quels caractères peuvent être inclus dans le nom du participant.set( ''.join(ar['name'].unique()))

Out: [' ', '!', '"', '#', '&', "'", '(', ')', '*', '+', ',', '-', '.', '/', '0', '1', '2', '3', '4', '5', '6', '7', '8', '9', ':', ';', '>', '?', '@', 'A', 'B', 'C', 'D', 'E', 'F', 'G', 'H', 'I', 'J', 'K', 'L', 'M', 'N', 'O', 'P', 'Q', 'R', 'S', 'T', 'U', 'V', 'W', 'X', 'Y', 'Z', '[', '\\', ']', '^', '_', '`', 'a', 'b', 'c', 'd', 'e', 'f', 'g', 'h', 'i', 'j', 'k', 'l', 'm', 'n', 'o', 'p', 'q', 'r', 's', 't', 'u', 'v', 'w', 'x', 'y', 'z', '|', '\x7f', '\xa0', '¤', '¦', '§', '', '«', '\xad', '', '°', '±', 'µ', '¶', '·', '»', '', 'І', '', '', '', '', '', '', '', '', '', '', '', '', '', '', '', '', '', '', '', '', '', '', '', '', '', '', '', '', '', '', '', '', '', '', '', '', '', '', '', '', '', '', '', '', '', '', '', '', '', '', '', '', '', '', '', '', '', '', '', '', '', '', '', '', 'є', 'і', 'ў', '–', '—', '‘', '’', '‚', '“', '”', '„', '†', '‡', '…', '‰', '›', '']

Qu'y a-t-il seulement! En plus des lettres et des espaces réels, il y a encore un tas de différents personnages bizarres. Parmi ceux-ci, la période «.», Le tiret «-» et l'apostrophe «» peuvent être considérés comme valides, c'est-à-dire non présents par erreur. De plus, il a été remarqué que dans de nombreux noms et prénoms allemands et norvégiens, il y a un point d'interrogation «?». Apparemment, ils remplacent les caractères de l'alphabet latin étendu - «?», «A», «o», «u»,? Voici quelques exemples: La virgule, bien qu'elle se produise très souvent, n'est qu'un séparateur, adopté à certaines races, elle tombera donc également dans la catégorie des inacceptables. Les chiffres ne doivent pas non plus apparaître dans les noms.Pierre-Alexandre Petit, Jean-louis Lafontaine, Faris Al-Sultan, Jean-Francois Evrard, Paul O'Mahony, Aidan O'Farrell, John O'Neill, Nick D'Alton, Ward D'Hulster, Hans P.J. Cami, Luis E. Benavides, Maximo Jr. Rueda, Prof. Dr. Tim-Nicolas Korf, Dr. Boris Scharlowsk, Eberhard Gro?mann, Magdalena Wei?, Gro?er Axel, Meyer-Szary Krystian, Morten Halkj?r, RASMUSSEN S?ren Balle

bs = [s for s in symbols if not (s.isalpha() or s in " . - ' ? ,")]

bs

Out: ['!', '"', '#', '&', '(', ')', '*', '+', '/', '0', '1', '2', '3', '4', '5', '6', '7', '8', '9', ':', ';', '>', '@', '[', '\\', ']', '^', '_', '`', '|', '\x7f', '\xa0', '¤', '¦', '§', '', '«', '\xad', '', '°', '±', '¶', '·', '»', '–', '—', '‘', '’', '‚', '“', '”', '„', '†', '‡', '…', '‰', '›', '']

Nous supprimerons temporairement tous ces caractères pour savoir combien d'entrées ils sont présents:for s in bs:

ar['name'] = ar['name'].str.replace(s, '')

corr = ar[ar['name'] != ar['name raw']]

Il existe 2 184 enregistrements de ce type, soit seulement 0,15% du nombre total - très peu. Jetons un coup d'œil à 100 d'entre eux:list(corr['name raw'].sample(100))

Out: ['Scha¶ffl, Ga?nter', 'Howard, Brian &', 'Chapiewski, Guilherme (Gc)', 'Derkach 1svd_mail_ru', 'Parker H1 Lauren', 'Leal le?n, Yaneri', 'TencA, David', 'Cortas La?pez, Alejandro', 'Strid, Bja¶rn', '(Crutchfield) Horan, Katie', 'Vigneron, Jean-Michel.Vigneron@gmail.Com', '\xa0', 'Telahr, J†rgen', 'St”rmer, Melanie', 'Nagai B1 Keiji', 'Rinc?n, Mariano', 'Arkalaki, Angela (Evangelia)', 'Barbaro B1 Bonin Anna G:Charlotte', 'Ra?esch, Ja¶rg', "CAVAZZI NICCOLO\\'", 'D„nzel, Thomas', 'Ziska, Steffen (Gerhard)', 'Kobilica B1 Alen', 'Mittelholcz, Bala', 'Jimanez Aguilar, Juan Antonio', 'Achenza H1 Giovanni', 'Reppe H2 Christiane', 'Filipovic B2 Lazar', 'Machuca Ka?hnel, Ruban Alejandro', 'Gellert (Silberprinz), Christian', 'Smith (Guide), Matt', 'Lenatz H1 Benjamin', 'Da¶llinger, Christian', 'Mc Carthy B1 Patrick Donnacha G:Bryan', 'Fa¶llmer, Chris', 'Warner (Rivera), Lisa', 'Wang, Ruijia (Ray)', 'Mc Carthy B1 Donnacha', 'Jones, Nige (Paddy)', 'Sch”ler, Christoph', '\xa0', 'Holthaus, Adelhard (Allard)', 'Mi;Arro, Ana', 'Dr: Koch Stefan', '\xa0', '\xa0', 'Ziska, Steffen (Gerhard)', 'Albarraca\xadn Gonza?lez, Juan Francisco', 'Ha¶fling, Imke', 'Johnston, Eddie (Edwin)', 'Mulcahy, Bob (James)', 'Gottschalk, Bj”rn', '\xa0', 'Gretsch H2 Kendall', 'Scorse, Christopher (Chris)', 'Kiel‚basa, Pawel', 'Kalan, Magnus', 'Roderick "eric" SIMBULAN', 'Russell;, Mark', 'ROPES AND GRAY TEAM 3', 'Andrade, H?¦CTOR DANIEL', 'Landmann H2 Joshua', 'Reyes Rodra\xadguez, Aithami', 'Ziska, Steffen (Gerhard)', 'Ziska, Steffen (Gerhard)', 'Heuza, Pierre', 'Snyder B1 Riley Brad G:Colin', 'Feldmann, Ja¶rg', 'Beveridge H1 Nic', 'FAGES`, perrine', 'Frank", Dieter', 'Saarema¤el, Indrek', 'Betancort Morales, Arida–y', 'Ridderberg, Marie_Louise', '\xa0', 'Ka¶nig, Johannes', 'W Van(der Klugt', 'Ziska, Steffen (Gerhard)', 'Johnson, Nick26', 'Heinz JOHNER03', 'Ga¶rg, Andra', 'Maruo B2 Atsuko', 'Moral Pedrero H1 Eva Maria', '\xa0', 'MATUS SANTIAGO Osc1r', 'Stenbrink, Bja¶rn', 'Wangkhan, Sm1.Thaworn', 'Pullerits, Ta¶nu', 'Clausner, 8588294149', 'Castro Miranda, Josa Ignacio', 'La¶fgren, Pontuz', 'Brown, Jann ( Janine )', 'Ziska, Steffen (Gerhard)', 'Koay, Sa¶ren', 'Ba¶hm, Heiko', 'Oleksiuk B2 Vita', 'G Van(de Grift', 'Scha¶neborn, Guido', 'Mandez, A?lvaro', 'Garca\xada Fla?rez, Daniel']

En conséquence, après de nombreuses recherches, il a été décidé: de remplacer tous les caractères alphabétiques, ainsi qu'un espace, un trait d'union, une apostrophe et un point d'interrogation, par une virgule, un point et un symbole et des espaces '\ xa0', et de remplacer tous les autres caractères par une chaîne vide, c'est-à-dire, supprimez simplement.ar['name'] = ar['name raw']

for s in symbols:

if s.isalpha() or s in " - ? '":

continue

if s in ".,\xa0":

ar['name'] = ar['name'].str.replace(s, ' ')

else:

ar['name'] = ar['name'].str.replace(s, '')

Ensuite, débarrassez-vous des espaces supplémentaires:ar['name'] = ar['name'].str.split().str.join(' ')

ar['name'] = ar['name'].str.strip()

Voyons ce qui se passe:ar.loc[corr.index].sample(10)

qmon = ar[(ar['name'].str.replace('?', '').str.strip() == '')&(ar['name']!='')]

Il y en a 3 429. Cela ressemble à ceci: Notre objectif de ramener les noms à la même norme est de faire en sorte que les mêmes noms se ressemblent, mais diffèrent de différentes manières. Dans le cas de noms composés uniquement de points d'interrogation, ils ne diffèrent que par le nombre de caractères, mais cela ne donne pas la pleine confiance que les noms avec le même numéro sont vraiment les mêmes. Par conséquent, nous les remplaçons tous par une chaîne vide et ne seront pas pris en compte à l'avenir.ar.loc[qmon.index, 'name'] = ''

Le nombre total d'entrées où le nom est la chaîne vide est de 3 454. Pas tellement - nous survivrons. Maintenant que nous nous sommes débarrassés des caractères inutiles, nous pouvons procéder à la translittération. Pour ce faire, mettez d'abord tout en minuscules afin de ne pas faire de double travail.ar['name'] = ar['name'].str.lower()

Ensuite, créez un dictionnaire:trans = {'':'a', '':'b', '':'v', '':'g', '':'d', '':'e', '':'e', '':'zh', '':'z', '':'i', '':'y', '':'k', '':'l', '':'m', '':'n', '':'o', '':'p', '':'r', '':'s', '':'t', '':'u', '':'f', '':'kh', '':'ts', '':'ch', '':'sh', '':'shch', '':'', '':'y', '':'', '':'e', '':'yu', '':'ya', 'є':'e', 'і': 'i','ў':'w','µ':'m'}

Il comprenait également des lettres de ce que l'on appelle l'alphabet cyrillique étendu - «є», «і», «ў» , qui sont utilisées dans les langues biélorusse et ukrainienne, ainsi que la lettre grecque «µ» . Appliquez la transformation:for s in trans:

ar['name'] = ar['name'].str.replace(s, trans[s])

Maintenant, à partir de la minuscule de travail, nous allons tout traduire dans le format familier, où le prénom et le nom commencent par une majuscule:ar['name'] = ar['name'].str.title()

Voyons ce qui se passe.ar[ar['name raw'].str.lower().str[0].isin(trans.keys())].sample(10)

set( ''.join(ar['name'].unique()))

Out: [' ', "'", '-', '?', 'A', 'B', 'C', 'D', 'E', 'F', 'G', 'H', 'I', 'J','K', 'L', 'M', 'N', 'O', 'P', 'Q', 'R', 'S', 'T', 'U', 'V', 'W', 'X', 'Y', 'Z', 'a', 'b', 'c', 'd', 'e', 'f', 'g', 'h', 'i', 'j', 'k', 'l', 'm', 'n', 'o', 'p', 'q', 'r', 's', 't', 'u', 'v', 'w', 'x', 'y', 'z']

Tout est correct. En conséquence, les corrections ont touché 1 253 882 ou 89% des enregistrements, le nombre de noms uniques est passé de 660 207 à 599 186, soit 61 000, soit près de 10%. Hou la la! Enregistrez dans un nouveau fichier, après avoir converti l'union des enregistrements ar dans le dictionnaire de protocole rd .pkl.dump(rd, open(r'D:\tri\details4.pkl', 'wb'))

Maintenant, nous devons rétablir l'ordre. Autrement dit, tous les enregistrements devraient ressembler à - Prénom Nom de famille ou Nom de famille Prénom . Lequel est à déterminer. Certes, en plus du nom et du prénom, certains protocoles contiennent également des prénoms. Et il peut arriver que la même personne soit écrite différemment dans différents protocoles - quelque part avec un deuxième prénom, quelque part sans. Cela interférera avec son identification, essayez donc de supprimer le deuxième prénom. Les patronymes pour les hommes ont généralement la terminaison «vih» et pour les femmes - «vna» . Mais il y a des exceptions. Par exemple - Ilyich, Ilyinichna, Nikitich, Nikitichna. Certes, il existe très peu d'exceptions de ce type. Comme déjà indiqué, le format des noms au sein d'un même protocole peut être considéré comme permanent. Par conséquent, pour vous débarrasser des patronymes, vous devez trouver la race dans laquelle ils sont présents. Pour ce faire, recherchez le nombre total de fragments "vich" et "vna" dans le nom de la colonneet les comparer avec le nombre total d'entrées dans chaque protocole. Si ces nombres sont proches, alors il y a un deuxième prénom, sinon non. Il n'est pas raisonnable de rechercher une conformité stricte, même dans les courses où les prénoms sont enregistrés, par exemple, les étrangers peuvent participer, et ils seront enregistrés sans lui. Il arrive aussi que le participant oublie ou ne veuille pas indiquer son deuxième prénom. D'autre part, il existe également des noms de famille se terminant par "vich", il y en a beaucoup au Bélarus et dans d'autres pays avec les langues du groupe slave. De plus, nous avons fait de la translittération. Il était possible de faire cette analyse avant la translittération, mais il y a alors une chance de manquer un protocole dans lequel il y a des prénoms, mais au départ il est déjà en latin. Alors tout va bien.Nous allons donc rechercher tous les protocoles dans lesquels le nombre de fragments «vich» et «vna» dans la colonnenom représente plus de 50% du nombre total d'entrées dans le protocole.wp = {}

for e in rd:

nvich = (''.join(rd[e]['name'])).count('vich')

nvna = (''.join(rd[e]['name'])).count('vna')

if nvich + nvna > 0.5*len(rd[e]):

wp[e] = rd[e]

Il existe 29 protocoles de ce type et il est intéressant de noter que si au lieu de 50% nous prenons 20% ou vice versa 70%, le résultat ne changera pas, il en sera de même 29. Nous avons donc fait le bon choix. En conséquence, moins de 20% - l'effet des noms de famille, plus de 70% - l'effet des enregistrements individuels sans prénoms. Après avoir vérifié le pays à l'aide d'un tableau croisé dynamique, il s'est avéré que 25 d'entre eux étaient en Russie, 4 en Abkhazie. Continuons. Nous ne traiterons que les enregistrements à trois composants, c'est-à-dire ceux où il y a (vraisemblablement) un nom de famille, un prénom, un deuxième prénom.sum_n3w = 0

sum_nnot3w = 0

for e in wp:

sum_n3w += len([n for n in wp[e]['name'] if len(n.split()) == 3])

sum_nnot3w += len(wp[e]) - n3w

La majorité de ces enregistrements est de 86%. Maintenant ceux dans lesquels les trois composants sont divisés en colonnes nom0, nom1, nom2 :for e in wp:

ind3 = [i for i in rd[e].index if len(rd[e].loc[i,'name'].split()) == 3]

rd[e]['name0'] = ''

rd[e]['name1'] = ''

rd[e]['name2'] = ''

rd[e].loc[ind3, 'name0'] = rd[e].loc[ind3,'name'].str.split().str[0]

rd[e].loc[ind3, 'name1'] = rd[e].loc[ind3,'name'].str.split().str[1]

rd[e].loc[ind3, 'name2'] = rd[e].loc[ind3,'name'].str.split().str[2]

Voici à quoi ressemble l'un des protocoles: Ici, en particulier, il est clair que l'enregistrement des deux composants n'a pas été traité. Maintenant, pour chaque protocole, vous devez déterminer quelle colonne a un deuxième prénom. Il n'y a que deux options - nom1, nom2 , car il ne peut pas être en premier lieu. Une fois déterminé, nous recueillerons déjà un nouveau nom sans lui.for e in wp:

n1=(''.join(rd[e]['name1'])).count('vich')+(''.join(rd[e]['name1'])).count('vna')

n2=(''.join(rd[e]['name2'])).count('vich')+(''.join(rd[e]['name2'])).count('vna')

if (n1 > n2):

rd[e]['new name'] = rd[e]['name0'] + ' ' + rd[e]['name2']

else:

rd[e]['new name'] = rd[e]['name0'] + ' ' + rd[e]['name1']

for e in wp:

ind = rd[e][rd[e]['new name'].str.strip() != ''].index

rd[e].loc[ind, 'name'] = rd[e].loc[ind, 'new name']

rd[e] = rd[e].drop(columns = ['name0','name1','name2','new name'])

pkl.dump(rd, open(r'D:\tri\details5.pkl', 'wb'))

Vous devez maintenant mettre les noms dans le même ordre. Autrement dit, il est nécessaire que dans tous les protocoles, le nom suivi en premier du nom de famille, ou vice versa - d'abord le nom de famille, puis le prénom, également dans tous les protocoles. Cela dépend de quoi de plus, nous allons maintenant le découvrir. La situation est légèrement compliquée par le fait que le nom complet peut comprendre plus de deux mots, même après avoir supprimé le deuxième prénom.ar['nwin'] = ar['name'].str.count(' ') + 1

ar.loc[ar['name'] == '','nwin'] = 0

100*ar['nwin'].value_counts()/len(ar)

Nombre de mots dans un nom Nombre d'enregistrements Part d'enregistrements (%) Bien sûr, la grande majorité (91%) sont deux mots - juste un nom et un nom de famille. Mais les entrées de trois et quatre mots sont également très nombreuses. Regardons la nationalité de ces enregistrements:ar[ar['nwin'] >= 3]['country'].value_counts()[:12]

Out:

ESP 28435

MEX 10561

USA 7608

DNK 7178

BRA 6321

NLD 5748

DEU 4310

PHL 3941

ZAF 3862

ITA 3691

BEL 3596

FRA 3323

Eh bien, en premier lieu, l'Espagne, en deuxième - le Mexique, un pays hispanique, plus loin que les États-Unis, où il y a aussi historiquement beaucoup d'Hispaniques. Le Brésil et les Philippines sont également des noms espagnols (et portugais). Le Danemark, les Pays-Bas, l'Allemagne, l'Afrique du Sud, l'Italie, la Belgique et la France sont une autre affaire, il y a simplement parfois une sorte de préfixe au nom de famille, donc il y a plus de deux mots. Dans tous ces cas, cependant, le nom lui-même se compose généralement d'un mot et le nom de famille de deux, trois. Bien sûr, il existe des exceptions à cette règle, mais nous ne les traiterons plus. Tout d'abord, pour chaque protocole, vous devez déterminer le type de commande: nom-prénom ou vice versa. Comment faire? L'idée suivante m'est venue à l'esprit: premièrement, la variété des noms de famille est généralement beaucoup plus grande que la variété des noms. Il devrait en être ainsi même dans le cadre d'un protocole. Deuxièmement,la longueur du prénom est généralement inférieure à la longueur du nom de famille (même pour les noms de famille non composites). Nous utiliserons une combinaison de ces critères pour déterminer la commande préliminaire.Sélectionnez le premier et le dernier mot du nom complet:ar['new name'] = ar['name']

ind = ar[ar['nwin'] < 2].index

ar.loc[ind, 'new name'] = '. .'

ar['wfin'] = ar['new name'].str.split().str[0]

ar['lwin'] = ar['new name'].str.split().str[-1]

Convertissez à nouveau le bloc de données ar combiné dans le dictionnaire rd afin que les nouvelles colonnes nwin, ns0, ns tombent dans le bloc de données de chaque race. Ensuite, nous déterminons le nombre de protocoles avec l'ordre «Prénom Nom» et le nombre de protocoles avec l'ordre inverse selon notre critère. Nous ne considérerons que les entrées dont le nom complet se compose de deux mots. Dans le même temps, enregistrez le nom (prénom) dans une nouvelle colonne:name_surname = {}

surname_name = {}

for e in rd:

d = rd[e][rd[e]['nwin'] == 2]

if len(d['fwin'].unique()) < len(d['lwin'].unique()) and len(''.join(d['fwin'])) < len(''.join(d['lwin'])):

name_surname[e] = d

rd[e]['first name'] = rd[e]['fwin']

if len(d['fwin'].unique()) > len(d['lwin'].unique()) and len(''.join(d['fwin'])) > len(''.join(d['lwin'])):

surname_name[e] = d

rd[e]['first name'] = rd[e]['lwin']

Il s'est avéré ce qui suit: l'ordre Prénom Nom - 244 protocoles, l'ordre Nom Prénom - 1 508 protocoles.En conséquence, nous aboutirons au format le plus courant. La somme s'est avérée inférieure au montant total, car nous avons vérifié le respect de deux critères à la fois, et même avec une stricte inégalité. Il existe des protocoles dans lesquels un seul des critères est rempli, ou c'est possible, mais il est peu probable que l'égalité ait lieu. Mais cela n'a absolument aucune importance puisque le format est défini.Maintenant, en supposant que nous avons déterminé la commande avec une précision suffisamment élevée, sans oublier qu'elle n'est pas exacte à 100%, nous utiliserons ces informations. Trouvez les noms les plus populaires dans la colonne Prénom :vc = ar['first name'].value_counts()

prenez ceux qui se sont rencontrés plus d'une centaine de fois:pfn=vc[vc>100]

il y en avait 1 673. Voici les cent premiers, classés par ordre décroissant de popularité: Maintenant, en utilisant cette liste, nous allons parcourir tous les protocoles et comparer où il y a plus de correspondances - dans le premier mot du nom ou dans le dernier. Nous ne considérerons que les noms de deux mots. S'il y a plus de correspondances avec le dernier mot, alors l'ordre est correct, si avec le premier, cela signifie le contraire. De plus, ici, nous sommes déjà plus confiants, vous pouvez donc utiliser ces connaissances, et nous ajouterons une liste de noms de leur prochain protocole à la liste initiale de noms populaires à chaque passage. Nous pré-trions les protocoles par la fréquence d'occurrence des noms de la liste initiale afin d'éviter les erreurs aléatoires et préparons une liste plus complète pour les protocoles dans lesquels il y a peu de correspondances et qui seront traités vers la fin du cycle.['Michael', 'David', 'Thomas', 'John', 'Daniel', 'Mark', 'Peter', 'Paul', 'Christian', 'Robert', 'Martin', 'James', 'Andrew', 'Chris', 'Richard', 'Andreas', 'Matthew', 'Brian', 'Patrick', 'Scott', 'Kevin', 'Stefan', 'Jason', 'Eric', 'Christopher', 'Alexander', 'Simon', 'Mike', 'Tim', 'Frank', 'Stephen', 'Steve', 'Andrea', 'Jonathan', 'Markus', 'Marco', 'Adam', 'Ryan', 'Jan', 'Tom', 'Marc', 'Carlos', 'Jennifer', 'Matt', 'Steven', 'Jeff', 'Sergey', 'William', 'Aleksandr', 'Sarah', 'Alex', 'Jose', 'Andrey', 'Benjamin', 'Sebastian', 'Ian', 'Anthony', 'Ben', 'Oliver', 'Antonio', 'Ivan', 'Sean', 'Manuel', 'Matthias', 'Nicolas', 'Dan', 'Craig', 'Dmitriy', 'Laura', 'Luis', 'Lisa', 'Kim', 'Anna', 'Nick', 'Rob', 'Maria', 'Greg', 'Aleksey', 'Javier', 'Michelle', 'Andre', 'Mario', 'Joseph', 'Christoph', 'Justin', 'Jim', 'Gary', 'Erik', 'Andy', 'Joe', 'Alberto', 'Roberto', 'Jens', 'Tobias', 'Lee', 'Nicholas', 'Dave', 'Tony', 'Olivier', 'Philippe']

sbpn = pd.DataFrame(columns = ['event', 'num pop names'], index=range(len(rd)))

for i in range(len(rd)):

e = list(rd.keys())[i]

sbpn.loc[i, 'event'] = e

sbpn.loc[i, 'num pop names'] = len(set(pfn).intersection(rd[e]['first name']))

sbnp=sbnp.sort_values(by = 'num pop names',ascending=False)

sbnp = sbnp.reset_index(drop=True)

tofix = []

for i in range(len(rd)):

e = sbpn.loc[i, 'event']

if len(set(list(rd[e]['fwin'])).intersection(pfn)) > len(set(list(rd[e]['lwin'])).intersection(pfn)):

tofix.append(e)

pfn = list(set(pfn + list(rd[e]['fwin'])))

else:

pfn = list(set(pfn + list(rd[e]['lwin'])))

Il y avait 235 protocoles. C'est à peu près la même chose que ce qui s'est passé dans la première approximation (244). Pour être sûr, j'ai regardé sélectivement les trois premiers enregistrements de chacun, en m'assurant que tout était correct. Vérifiez également que la première étape du tri a donné 36 fausses entrées du nom de classe Nom et 2 fausses du nom de classe Nom . J'ai regardé les trois premiers disques de chacun, en effet, la deuxième étape a parfaitement fonctionné. Maintenant, en fait, il reste à corriger ces protocoles où le mauvais ordre est trouvé:for e in tofix:

ind = rd[e][rd[e]['nwin'] > 1].index

rd[e].loc[ind,'name'] = rd[e].loc[ind,'name'].str.split(n=1).str[1] + ' ' + rd[e].loc[ind,'name'].str.split(n=1).str[0]

Ici, dans la division, nous avons limité le nombre de pièces en utilisant le paramètre n . La logique est la suivante: un nom est un mot, le premier d'un nom complet. Tout le reste est un nom de famille (peut comprendre plusieurs mots). Échangez-les.Maintenant, nous nous débarrassons des colonnes inutiles et économisons:for e in rd:

rd[e] = rd[e].drop(columns = ['new name', 'first name', 'fwin','lwin', 'nwin'])

pkl.dump(rd, open(r'D:\tri\details6.pkl', 'wb'))

Vérifiez le résultat. Une douzaine d'enregistrements fixes aléatoires: Au total, 108 000 enregistrements ont été corrigés. Le nombre de noms complets uniques est passé de 598 à 547 000. Bien! Une fois le formatage terminé.Partie 3. Récupération de données incomplètes

Passez maintenant à la récupération des données manquantes. Et il y en a.Pays

Commençons par le pays. Recherchez tous les enregistrements dans lesquels le pays n'est pas indiqué:arnc = ar[ar['country'] == '']

Il y en a 3 221, dont 10 au hasard:nnc = arnc['name'].unique()

Le nombre de noms uniques parmi les enregistrements sans pays est de 3 051. Voyons si ce nombre peut être réduit.Le fait est que dans le triathlon, les gens se limitent rarement à une seule course, ils participent généralement à des compétitions périodiquement, plusieurs fois par saison, d'année en année, s'entraînant constamment. Par conséquent, pour de nombreux noms dans les données, il y a très probablement plus d'un enregistrement. Pour restaurer les informations sur le pays, essayez de trouver des enregistrements du même nom parmi ceux dans lesquels le pays est indiqué.arwc = ar[ar['country'] != '']

nwc = arwc['name'].unique()

tofix = set(nnc).intersection(nwc)

Out: ['Kleber-Schad Ute Cathrin', 'Sellner Peter', 'Pfeiffer Christian', 'Scholl Thomas', 'Petersohn Sandra', 'Marchand Kurt', 'Janneck Britta', 'Angheben Riccardo', 'Thiele Yvonne', 'Kie?Wetter Martin', 'Schymik Gerhard', 'Clark Donald', 'Berod Brigitte', 'Theile Markus', 'Giuliattini Burbui Margherita', 'Wehrum Alexander', 'Kenny Oisin', 'Schwieger Peter', 'Grosse Bianca', 'Schafter Carsten', 'Breck Dirk', 'Mautes Christoph', 'Herrmann Andreas', 'Gilbert Kai', 'Steger Peter', 'Jirouskova Jana', 'Jehrke Michael', 'Valentine David', 'Reis Michael', 'Wanka Michael', 'Schomburg Jonas', 'Giehl Caprice', 'Zinser Carsten', 'Schumann Marcus', 'Magoni Livio', 'Lauden Yann', 'Mayer Dieter', 'Krisa Stefan', 'Haberecht Bernd', 'Schneider Achim', 'Gibanel Curto Antonio', 'Miranda Antonio', 'Juarez Pedro', 'Prelle Gerrit', 'Wuste Kay', 'Bullock Graeme', 'Hahner Martin', 'Kahl Maik', 'Schubnell Frank', 'Hastenteufel Marco', …]

Il y en avait 2 236, soit près des trois quarts. Maintenant, pour chaque nom de cette liste, vous devez déterminer le pays par les enregistrements où il se trouve. Mais il arrive que le même nom se retrouve dans plusieurs enregistrements et dans différents pays. Il s'agit soit de l'homonyme, soit de la personne qui a déménagé. Par conséquent, nous traitons d'abord ceux où tout est unique.fix = {}

for n in tofix:

nr = arwc[arwc['name'] == n]

if len(nr['country'].unique()) == 1:

fix[n] = nr['country'].iloc[0]

Fabriqué en boucle. Mais, franchement, cela fonctionne pendant longtemps - environ trois minutes. S'il y avait un ordre de grandeur de plus d'entrées, vous devriez probablement trouver une implémentation vectorielle. Il y avait 2 013 entrées, soit 90% du potentiel.Les noms pour lesquels différents pays peuvent apparaître dans différents enregistrements, prennent le pays qui apparaît le plus souvent.if n not in fix:

nr = arwc[arwc['name'] == n]

vc = nr['country'].value_counts()

if vc[0] > vc[1]:

fix[n] = vc.index[0]

Ainsi, des correspondances ont été trouvées pour 2 208 noms, soit 99% de tous les noms potentiels. Nous appliquons ces correspondances:{'Kleber-Schad Ute Cathrin': 'DEU', 'Sellner Peter': 'AUT', 'Pfeiffer Christian': 'AUT', 'Scholl Thomas': 'DEU', 'Petersohn Sandra': 'DEU', 'Marchand Kurt': 'BEL', 'Janneck Britta': 'DEU', 'Angheben Riccardo': 'ITA', 'Thiele Yvonne': 'DEU', 'Kie?Wetter Martin': 'DEU', 'Clark Donald': 'GBR', 'Berod Brigitte': 'FRA', 'Theile Markus': 'DEU', 'Giuliattini Burbui Margherita': 'ITA', 'Wehrum Alexander': 'DEU', 'Kenny Oisin': 'IRL', 'Schwieger Peter': 'DEU', 'Schafter Carsten': 'DEU', 'Breck Dirk': 'DEU', 'Mautes Christoph': 'DEU', 'Herrmann Andreas': 'DEU', 'Gilbert Kai': 'DEU', 'Steger Peter': 'AUT', 'Jirouskova Jana': 'CZE', 'Jehrke Michael': 'DEU', 'Wanka Michael': 'DEU', 'Giehl Caprice': 'DEU', 'Zinser Carsten': 'DEU', 'Schumann Marcus': 'DEU', 'Magoni Livio': 'ITA', 'Lauden Yann': 'FRA', 'Mayer Dieter': 'DEU', 'Krisa Stefan': 'DEU', 'Haberecht Bernd': 'DEU', 'Schneider Achim': 'DEU', 'Gibanel Curto Antonio': 'ESP', 'Juarez Pedro': 'ESP', 'Prelle Gerrit': 'DEU', 'Wuste Kay': 'DEU', 'Bullock Graeme': 'GBR', 'Hahner Martin': 'DEU', 'Kahl Maik': 'DEU', 'Schubnell Frank': 'DEU', 'Hastenteufel Marco': 'DEU', 'Tedde Roberto': 'ITA', 'Minervini Domenico': 'ITA', 'Respondek Markus': 'DEU', 'Kramer Arne': 'DEU', 'Schreck Alex': 'DEU', 'Bichler Matthias': 'DEU', …}

for n in fix:

ind = arnc[arnc['name'] == n].index

ar.loc[ind, 'country'] = fix[n]

pkl.dump(rd, open(r'D:\tri\details7.pkl', 'wb'))

Sol

Comme dans le cas des pays, il existe des enregistrements dans lesquels le sexe du participant n'est pas indiqué.ar[ar['sex'] == '']

Il y en a 2 538. Relativement peu, mais encore une fois, essayez d'en faire encore moins. Enregistrez les valeurs d'origine dans une nouvelle colonne.ar['sex raw'] =ar['sex']

Contrairement aux pays où nous avons récupéré des informations par nom à partir d'autres protocoles, tout est un peu plus compliqué ici. Le fait est que les données sont pleines d'erreurs et il existe de nombreux noms (total 2 101) avec des marques des deux sexes.arws = ar[(ar['sex'] != '')&(ar['name'] != '')]

snds = arws[arws.duplicated(subset='name',keep=False)]

snds = snds.drop_duplicates(subset=['name','sex'], keep = 'first')

snds = snds.sort_values(by='name')

snds = snds[snds.duplicated(subset = 'name', keep=False)]

snds

rss = [rd[e] for e in rd if len(rd[e][rd[e]['sex'] != '']['sex'].unique()) == 1]

Il y en a 633. Il semblerait que cela soit tout à fait possible, juste un protocole séparément pour les femmes, séparément pour les hommes. Mais le fait est que presque tous ces protocoles contiennent des groupes d'âge des deux sexes (les groupes d'âge masculins commencent par la lettre M , féminin - par la lettre F ). Par exemple: Il est prévu que le nom du groupe d'âge commence par la lettre M pour les hommes et par la lettre F pour les femmes. Dans les deux exemples précédents, malgré les erreurs dans la colonne sexe'ITU World Cup Tiszaujvaros Olympic 2002'