La complexité de la présentation des données pour le deep learning augmente chaque jour. Les réseaux de neurones graphiques ( GNN ) sont devenus l'une des percées de ces dernières années. Mais pourquoi les graphiques gagnent-ils de plus en plus en popularité dans l'apprentissage automatique?

Le but ultime de mon récit est la présentation générale des graphiques dans les techniques d'apprentissage automatique. L'article ne prétend pas être un travail scientifique qui décrit pleinement la pleine puissance des graphiques, mais ne fait qu'introduire le lecteur dans ce monde étonnant et complexe. La publication est parfaite, à la fois pour les professionnels endurcis au combat qui ne sont pas encore familiarisés avec la présentation de graphiques en apprentissage profond, et pour les débutants dans ce domaine.

introduction

La mise en évidence automatique des fonctionnalités importantes nécessaires pour résoudre un problème est l'une des principales raisons du succès de l'apprentissage automatique. Mais traditionnellement, lorsque vous travaillez avec des graphiques, les approches d'apprentissage automatique reposent sur des heuristiques définies par l'utilisateur pour extraire les fonctionnalités de codage des informations structurelles des graphiques. Néanmoins, la tendance des dernières années a changé: des approches émergent de plus en plus dans lesquelles ils apprennent automatiquement à coder la structure du graphique dans des investissements de faible dimension en utilisant des méthodes d'apprentissage en profondeur et de réduction de dimension non linéaire.

Dans l'apprentissage automatique sur les graphiques, deux problèmes centraux peuvent être distingués: l'inclusion d'informations sur la structure du graphique dans le modèle (c'est-à-dire un moyen simple de coder ces informations dans le vecteur d'entités) et la réduction de la dimension du vecteur d'entités.

( ), . , , .

?

, , : ?

— . , , ( ) [1], [2], ( [3], [4] [5]), [6] [7].

CV/ML , , . , , [8].

, . . , , , .

, (embeddings), . , , , , (), . , , . , .

, . , , . , , , .

, (direct encoding), . . , , -. , , , .

DeepWalk node2vec . , . , .

( ). (DNGR SDNE), , [9].

, , , — ( ) , .

(.1). :

, , , ( , ). .

, . , ( , ). , , , , .

, , . , , . (, )

- , , / . ; ( ) , ( ). , .

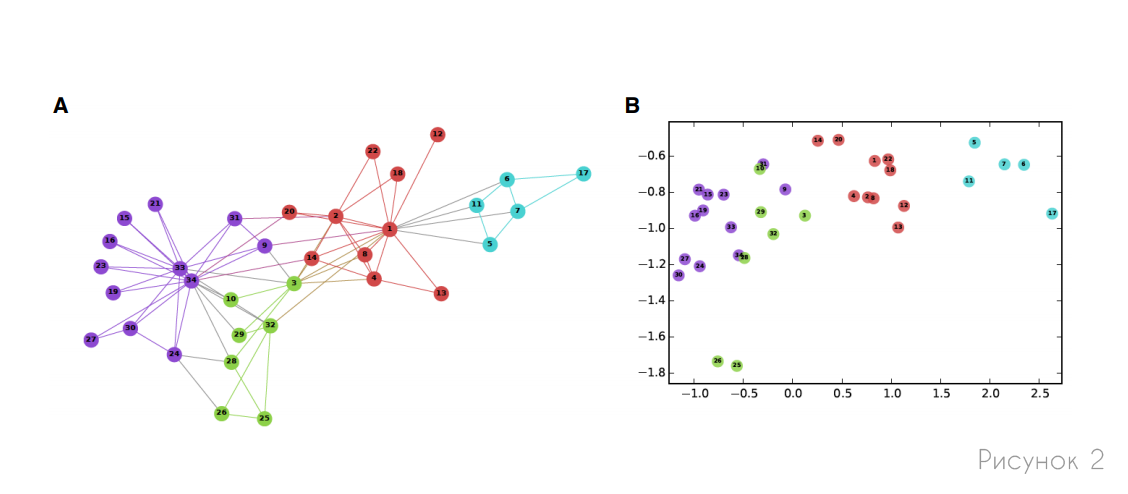

, , , . , (, ) . 2 , , .

, — , , ( ):

— , :

. , , . , , . , :

— , . , , 1, 0. . ( 1) :

— , (.. ) .

, -, , . , , , , , .

seq2seq , , . , seq2seq, GNN [10].

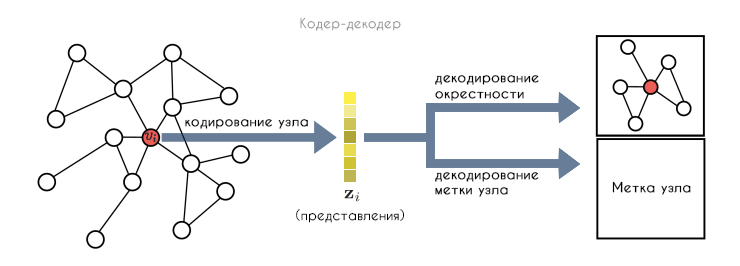

, :

- : , .

- ENC, . , .

- DEC, .

- , , .

. , . , .

, , . , , (.3). , , , .

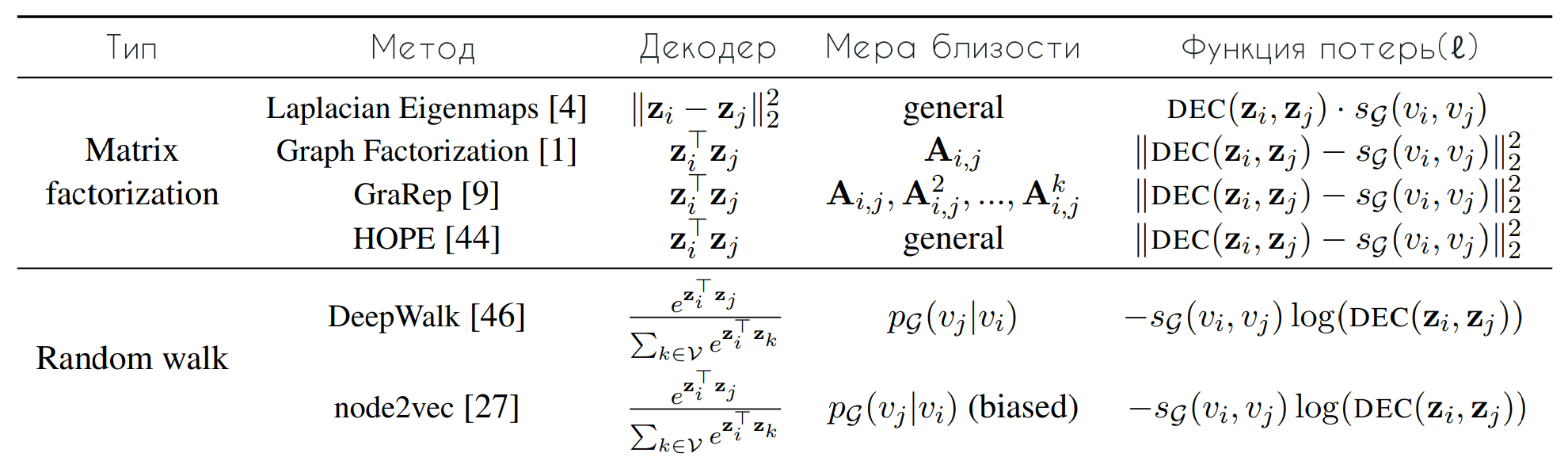

DeepWalk node2vec, , , . , , . , , :

— , , . , . , :

, (.. . — ( (2) ). , DeepWalk node2vec (3). DeepWalk softmax , . , node2vec (3), : , , " ".

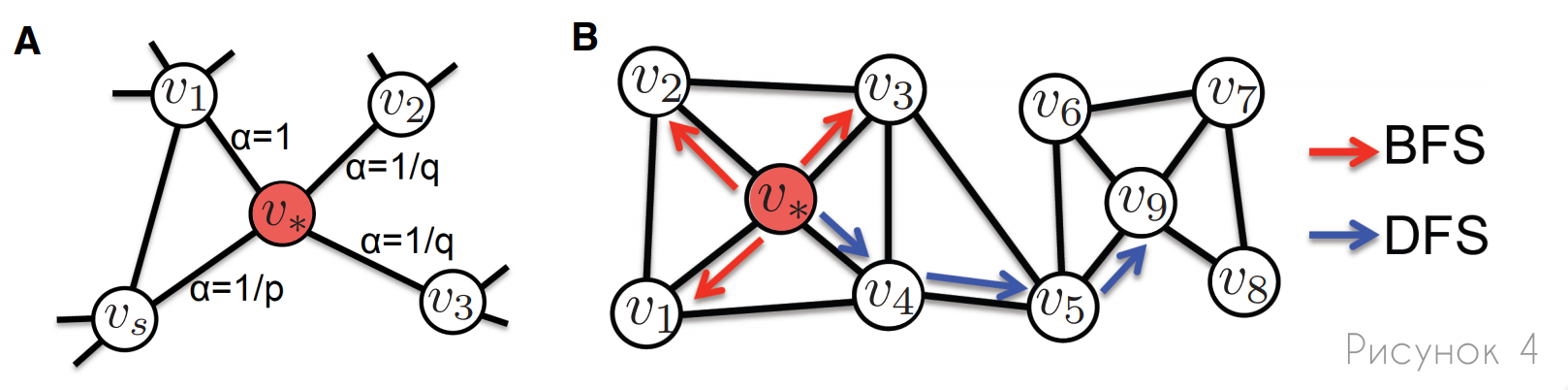

, node2vec DeepWalk , , . , node2vec : , (.4). , . , node2vec , .

A: , node2vec , p q. , , (α) , .

B: , (BFS) (DFS). , BFS, , , . , , DFS, .

, . , :

- (.. ). , , .

- . (, ), .

- . , , ( , ). , , , , .

/ . -, , , .

(DNGR) (SDNE) , : , . , — , (.5). DNGR SDNE , .

, ( — ). . DNGR SDNE , , :

, :

, , ( ), , . SDNE, DNGR, : , (.5).

SDNE DNGR , , , . DNGR , , DeepWalk node2vec. SDNE , .

, SDNE DNGR , ( ), - . , .

, . . , , , [9], . , .

. , , , , , , .

, , , .

. (. ), ( ). . , , , , , , — , , , . , , , .

. , , - , , . , , , , .

. , , , . , , , . , .

. , , . , , . , , , . , , , , .

, — . , , .

[1] — W. L. Hamilton, Z. Ying, and J. Leskovec, "Inductive representation learning on large graphs," NIPS 2017, pp. 1024–1034, 2017.

[2] — T. N. Kipf and M. Welling, "Semi-supervised classification with graph convolutional networks," ICLR 2017, 2017.

[3] — A. Sanchez-Gonzalez, N. Heess, J. T. Springenberg, J. Merel, M. Riedmiller, R. Hadsell, and P. Battaglia, "Graph networks as learnable physics engines for inference and control," arXiv

preprint arXiv:1806.01242, 2018.

[4] — P. Battaglia, R. Pascanu, M. Lai, D. J. Rezende et al., "Interaction networks for learning about objects, relations and physics," in NIPS 2016, 2016, pp. 4502–4510.

[5] — A. Fout, J. Byrd, B. Shariat, and A. Ben-Hur, "Protein interface prediction using graph convolutional networks," in NIPS 2017, 2017, pp. 6530–6539.

[6] — T. Hamaguchi, H. Oiwa, M. Shimbo, and Y. Matsumoto, "Knowledge transfer for out-of-knowledge-base entities: A graph neural network approach," in IJCAI 2017, 2017, pp. 1802–1808.

[7] — H. Dai, E. B. Khalil, Y. Zhang, B. Dilkina, and L. Song, "Learning combinatorial optimization algorithms over graphs," arXiv preprint arXiv:1704.01665, 2017.

[8] — X. Liang, X. Shen, J. Feng, F. Lin, S. Yan, "Semantic Object Parsing with Graph LSTM", arXiv:1603.07063v1 [cs.CV] 23 Mar 2016.

[9] — Z. Wu, S. Pan, F. Chen, G. Long, C. Zhang, Philip S. Yu, "A Comprehensive Survey on Graph Neural Networks", arXiv:1901.00596v4 [cs.LG] 4 Dec 2019.

[10] - P. Veličković, G. Cucurull, A. Casanova, A. Romero, P. Liò, Y. Bengio, «Graph Attention Networks», arXiv: 1710.10903v3 [stat.ML] 4 février 2018.

Références

Graph Neural Networks: A Review of Methods and Applications

Representation Learning on Graphs: Methods and Applications