capítulos anteriores

40. Problemas de generalización: de la muestra de entrenamiento a la validación

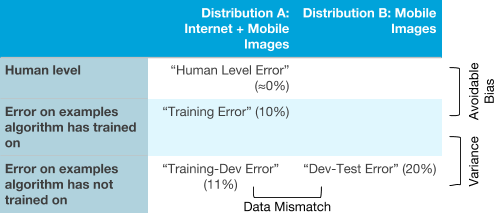

Suponga que aplica ML en condiciones donde la distribución de muestras de capacitación y validación es diferente. Por ejemplo, una muestra de capacitación contiene imágenes de Internet + imágenes de una aplicación móvil, y muestras de prueba y validación solo de una aplicación móvil. Sin embargo, el algoritmo no funciona muy bien: tiene un error mucho mayor en las muestras de validación y prueba de lo que quisiéramos. Aquí hay algunas razones posibles:

- El algoritmo funciona mal en la muestra de prueba y esto se debe al problema de un alto sesgo (evitable) en la distribución de la muestra de entrenamiento.

- El algoritmo es de alta calidad en el conjunto de entrenamiento, pero no puede generalizar su trabajo a datos que tengan una distribución similar con el conjunto de entrenamiento, que no había visto antes. Este es un caso de alta dispersión.

- El algoritmo generaliza bien su trabajo a los nuevos datos de la misma distribución que la muestra de entrenamiento, pero no puede hacer frente (generalizar) a la distribución de las muestras de validación y prueba que se obtienen de otra distribución. Esto indica la inconsistencia de datos que surge debido a la diferencia en la distribución de la muestra de entrenamiento de las distribuciones de validación y muestras de prueba.

Por ejemplo, supongamos que el nivel humano de reconocimiento de los gatos es casi ideal. Su algoritmo al respecto muestra:

- 1% de error en la muestra de entrenamiento

- 1.5% de error para los datos tomados de la misma distribución que la muestra de entrenamiento, pero que no se mostraron al algoritmo durante el entrenamiento

- Error del 10% en validación y muestras de prueba

. , . , .

, , , . , , : , , « », .

:

- . , ( + ). , ( ).

- : , ( + ). , ; , .

- : , , , . (, )

- : . ( )

, :

5-7 « ».

41. ,

( ≈0%) , , , 0%.

, :

? , . , , .

, :

, . .. . .

. , , , .

:

. , .

, , :

, . Y : , , , , . , .

. ( , ), , . , ( B) , . . , ( A B).

Habiendo determinado con qué tipos de errores tiene más dificultades el algoritmo, es posible decidir de manera más razonable si enfocarse en reducir el sesgo, reducir la dispersión, o si necesita ser desconcertado por la lucha contra la inconsistencia de datos.

continuación