Los procesos de las neuronas humanas mostraron una capacidad inesperada para calcular

Las dendritas, procesos de algunas neuronas en el cerebro humano, pueden realizar cálculos lógicos que, como se pensaba anteriormente, solo pueden hacer redes neuronales completas.

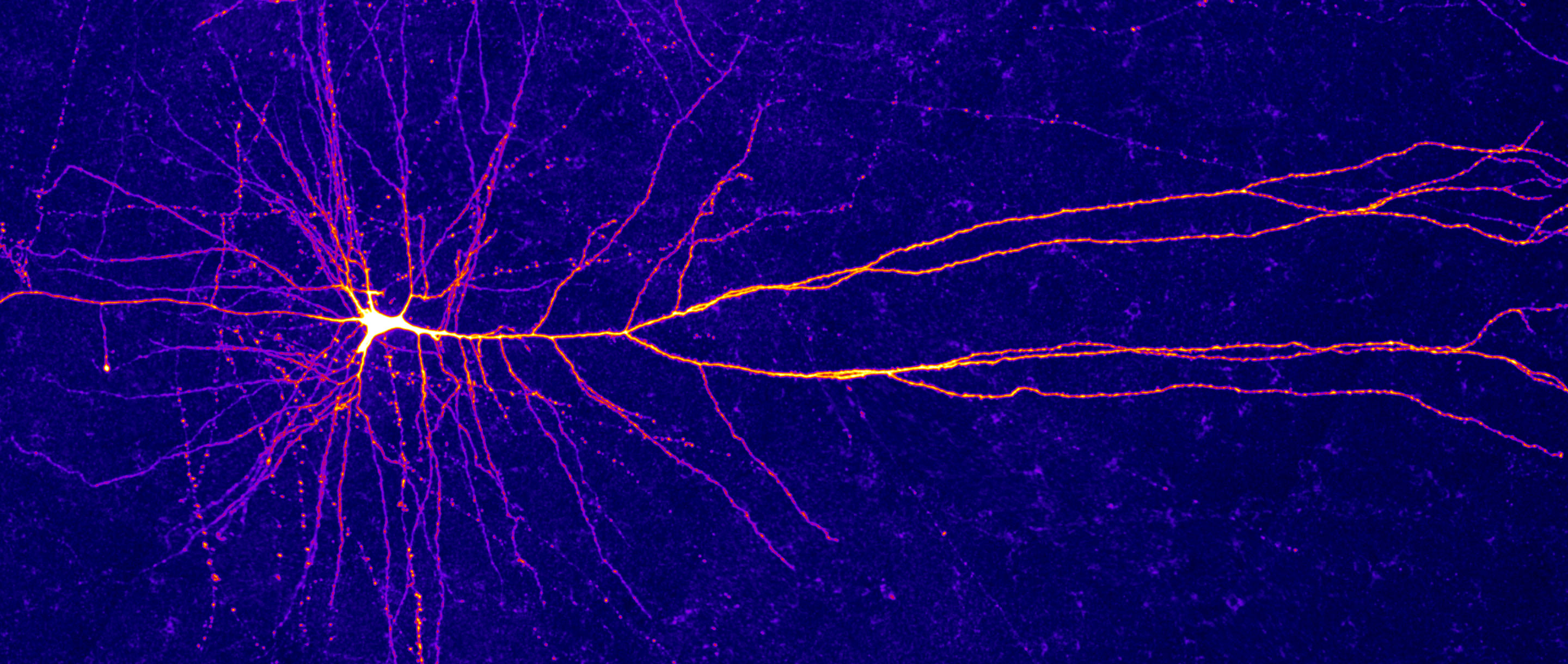

Las finas dendritas que se asemejan a las raíces de una planta divergen en todas las direcciones del cuerpo celular de esta neurona cortical. Las dendritas individuales pueden procesar de forma independiente las señales recibidas de las neuronas vecinas antes de transferirlas a la entrada de la célula.A menudo se nos dice que la capacidad del cerebro para procesar información reside en los billones de conexiones que conectan sus neuronas a la red. Pero en las últimas décadas, cada vez más investigaciones han cambiado gradualmente la atención a las neuronas individuales, que asumen una responsabilidad mucho mayor de computación de lo que se había imaginado anteriormente.El más reciente de estos muchos testimonios está asociado con el descubrimiento por parte de los científicos de un nuevo tipo de señal eléctrica que pasa a través de los niveles superiores de la corteza cerebral humana. En estudios de laboratorio y en modelos, ya se ha demostrado que pequeños compartimentos de dendritas, procesos de neuronas de la corteza cerebral, son capaces de realizar operaciones complejas desde el campo de la lógica matemática. Sin embargo, ahora parece que los compartimentos dendríticos individuales también pueden realizar una operación especial, un " OR exclusivo " (XOR), que, como se pensaba anteriormente, no estaba disponible para las neuronas individuales."Creo que se extraen de poca profundidad en el área de lo que realmente está involucrado en las neuronas," - dijo Albert Gedeón , un post-doctorado en la Universidad de Humboldt de Berlín, el autor principal de la revista Science publicó obras , que describe este descubrimiento.Este descubrimiento demuestra la necesidad cada vez mayor de que las neuronas individuales se consideren procesadores de información complejos en los estudios del sistema nervioso. "El cerebro puede ser mucho más complejo de lo que pensábamos", dijo Conrad Cording ., un neurocientífico computacional de la Universidad de Pennsylvania que no participó en este trabajo. Quizás el descubrimiento también pueda incitar a los informáticos a cambiar las estrategias de trabajo de las redes neuronales artificiales, en las que las neuronas siempre se han considerado como simples interruptores.

Las finas dendritas que se asemejan a las raíces de una planta divergen en todas las direcciones del cuerpo celular de esta neurona cortical. Las dendritas individuales pueden procesar de forma independiente las señales recibidas de las neuronas vecinas antes de transferirlas a la entrada de la célula.A menudo se nos dice que la capacidad del cerebro para procesar información reside en los billones de conexiones que conectan sus neuronas a la red. Pero en las últimas décadas, cada vez más investigaciones han cambiado gradualmente la atención a las neuronas individuales, que asumen una responsabilidad mucho mayor de computación de lo que se había imaginado anteriormente.El más reciente de estos muchos testimonios está asociado con el descubrimiento por parte de los científicos de un nuevo tipo de señal eléctrica que pasa a través de los niveles superiores de la corteza cerebral humana. En estudios de laboratorio y en modelos, ya se ha demostrado que pequeños compartimentos de dendritas, procesos de neuronas de la corteza cerebral, son capaces de realizar operaciones complejas desde el campo de la lógica matemática. Sin embargo, ahora parece que los compartimentos dendríticos individuales también pueden realizar una operación especial, un " OR exclusivo " (XOR), que, como se pensaba anteriormente, no estaba disponible para las neuronas individuales."Creo que se extraen de poca profundidad en el área de lo que realmente está involucrado en las neuronas," - dijo Albert Gedeón , un post-doctorado en la Universidad de Humboldt de Berlín, el autor principal de la revista Science publicó obras , que describe este descubrimiento.Este descubrimiento demuestra la necesidad cada vez mayor de que las neuronas individuales se consideren procesadores de información complejos en los estudios del sistema nervioso. "El cerebro puede ser mucho más complejo de lo que pensábamos", dijo Conrad Cording ., un neurocientífico computacional de la Universidad de Pennsylvania que no participó en este trabajo. Quizás el descubrimiento también pueda incitar a los informáticos a cambiar las estrategias de trabajo de las redes neuronales artificiales, en las que las neuronas siempre se han considerado como simples interruptores.Limitaciones del modelo estúpido de neuronas

En los años 1940 y 50, una cierta idea comenzó a dominar en neurobiología: el papel "tonto" de una neurona como un integrador simple, un punto de red que resume todas las entradas. Los procesos de ramificación de la célula, las dendritas, reciben miles de señales de las neuronas vecinas, algunas de las cuales son emocionantes, otras, inhibitorias. En el cuerpo de una neurona, todas estas señales se pesan y se suman, y si la suma excede un cierto umbral, la neurona produce una secuencia de impulsos eléctricos (de hecho, potenciales eléctricos) que controlan la estimulación de las neuronas vecinas.Casi al mismo tiempo, los investigadores se dieron cuenta de que una sola neurona podría funcionar como una puerta lógica, como las que componen los circuitos digitales (aunque aún no está claro cómo el cerebro realiza estos cálculos al procesar la información). La neurona era, de hecho, la "puerta AND", ya que se activaba solo después de recibir la cantidad necesaria de datos de entrada.Por lo tanto, una red de neuronas teóricamente podría realizar cualquier cálculo. Sin embargo, ese modelo neuronal era limitado. Sus metáforas computacionales eran demasiado simplistas, y durante décadas, las unidades experimentales carecían de la capacidad de registrar la actividad de varios componentes de una neurona. "Esencialmente exprimió una neurona hasta un punto en el espacio", dijo Barlett Mel ., Neurocientífico computacional en la Universidad del Sur de California. "No tenía manifestaciones internas de actividad". El modelo ignoró el hecho de que miles de señales que ingresan a la neurona se encontraban en diferentes puntos de sus diversas dendritas. Ella ignoró la idea (confirmada posteriormente) de que las dendritas individuales pueden funcionar de diferentes maneras. E ignoró la posibilidad de que varias estructuras internas de la neurona pudieran realizar varios cálculos.Sin embargo, en la década de 1980, las cosas comenzaron a cambiar. Los modelos del neurocientífico Christoph Koch y otros, que posteriormente confirmaron en experimentos, demostraronesa neurona no produce una señal de voltaje única o uniforme. En cambio, las señales disminuyeron, pasando a lo largo de la dendrita hacia la neurona, y a menudo no contribuyeron a la salida celular final.Tal aislamiento de señales significa que las dendritas individuales pueden procesar información independientemente una de la otra. "Esto era contrario a la hipótesis de la neurona puntual, en la que la neurona simplemente apilaba todo independientemente de la ubicación", dijo Mel.Esto provocó que Koch y otros biólogos, incluido Gordon Shepherdde la Facultad de Medicina de Yale, para modelar cómo la estructura de las dendritas en principio podría permitir que una neurona funcione no como una simple puerta lógica, sino como un complejo sistema de procesamiento de señales de múltiples componentes. Simularon árboles dendríticos, en los que se ubican muchas operaciones lógicas que funcionan a través de mecanismos hipotéticos.Más tarde, Mel y sus colegas estudiaron con más detalle cómo se podía controlar una célula con varias señales entrantes en dendritas separadas. Lo que encontraron les sorprendió: las dendritas generaban picos locales, tenían sus propias curvas de entrada / salida no lineales y sus propios umbrales de activación que diferían de la neurona en su conjunto. Las dendritas en sí mismas podrían funcionar como puertas "I", o colocar otros dispositivos informáticos en sí mismas.Tiza con un ex estudiante graduadoYota Poiratsi (ahora neurocientífica que trabaja en el Instituto de Biología Molecular y Biotecnología en Grecia) se dio cuenta de que esto significa que una sola neurona puede considerarse una red de dos capas . Las dendritas sirven como módulos informáticos auxiliares no lineales que recopilan datos de entrada y proporcionan datos de salida intermedios. Luego, estas señales se combinan en el cuerpo de la célula, lo que determina cómo responderá la neurona en su conjunto. Yota Poiratsi, neurocientífica computacional en el Instituto de Biología Molecular y Biotecnología en GreciaNo estaba claro si la actividad a nivel de las dendritas influía en la activación de una neurona y la actividad de las neuronas vecinas. Pero, en cualquier caso, dicho procesamiento local puede preparar o configurar el sistema para que responda a las señales entrantes futuras de manera diferente, como dice Shepherd.Sea como fuere, "la tendencia era esta: está bien, ten cuidado, la neurona puede ser más capaz, pensamos", dijo Mel.Shepherd está de acuerdo. "Una cantidad significativa de cómputo que tiene lugar en la corteza está en un nivel que no alcanza el umbral", dijo. "Un sistema de una sola neurona puede ser más que solo el único integrador". Puede haber dos capas, o incluso más ". En teoría, casi todas las operaciones computacionales pueden ser realizadas por una neurona con un número suficiente de dendritas, cada una de las cuales es capaz de realizar su propia operación no lineal.En un trabajo reciente en la revista Science, los investigadores llevaron esta idea aún más lejos. Sugirieron que un solo compartimento de dendrita podría realizar estas operaciones complejas por sí solo.

Yota Poiratsi, neurocientífica computacional en el Instituto de Biología Molecular y Biotecnología en GreciaNo estaba claro si la actividad a nivel de las dendritas influía en la activación de una neurona y la actividad de las neuronas vecinas. Pero, en cualquier caso, dicho procesamiento local puede preparar o configurar el sistema para que responda a las señales entrantes futuras de manera diferente, como dice Shepherd.Sea como fuere, "la tendencia era esta: está bien, ten cuidado, la neurona puede ser más capaz, pensamos", dijo Mel.Shepherd está de acuerdo. "Una cantidad significativa de cómputo que tiene lugar en la corteza está en un nivel que no alcanza el umbral", dijo. "Un sistema de una sola neurona puede ser más que solo el único integrador". Puede haber dos capas, o incluso más ". En teoría, casi todas las operaciones computacionales pueden ser realizadas por una neurona con un número suficiente de dendritas, cada una de las cuales es capaz de realizar su propia operación no lineal.En un trabajo reciente en la revista Science, los investigadores llevaron esta idea aún más lejos. Sugirieron que un solo compartimento de dendrita podría realizar estas operaciones complejas por sí solo.Explosiones inesperadas y viejos obstáculos

Matthew Larkum , un neurocientífico de Humboldt, y su equipo, comenzaron a estudiar las dendritas desde diferentes perspectivas. La actividad de las dendritas se estudió principalmente utilizando roedores como ejemplo, y los investigadores estaban interesados en cómo la propagación de la señal puede diferir en las neuronas humanas, cuyas dendritas son mucho más largas. Se pusieron a disposición secciones del tejido cerebral de la segunda y tercera capa de la corteza, que contiene neuronas especialmente grandes con una gran cantidad de dendritas. Y cuando comenzaron a estimular estas dendritas con la ayuda de la corriente eléctrica, notaron algo extraño.Vieron explosiones inesperadas y repetitivas, que eran completamente diferentes a otras señales neuronales conocidas. Eran especialmente rápidos y cortos, como potenciales de acción., y surgió debido a los iones de calcio. Esto fue interesante porque los potenciales de acción habituales son generados por los iones de sodio y potasio. Aunque las señales generadas por el calcio ya se observaron en las dendritas de roedores, estas explosiones duraron mucho más.Aún más extraño, un aumento en la intensidad de la estimulación eléctrica redujo la tasa de respuesta de las neuronas. "De repente, nosotros, estimulando más, comenzamos a recibir menos", dijo Gidon. "Nos llamó la atención".Para comprender lo que pueden hacer estos nuevos tipos de explosiones, los científicos se unieron con Poiratsi y un investigador de su laboratorio griego, Atanasia Paputzi , para crear un modelo que refleje el comportamiento de las neuronas.El modelo mostró que las dendritas producen ráfagas en respuesta a dos señales de entrada por separado, pero no producen si estas señales se combinan. Este es el equivalente de un cálculo no lineal, conocido como OR exclusivo, o XOR, dando 1 solo si uno, y solo una de las entradas es 1.Este descubrimiento resonó de inmediato entre los científicos informáticos. Durante muchos años, se creía que una neurona no podía contar la función XOR. En el libro de 1969, Perceptrons, los científicos informáticos Marvin Minsky y Seymour Papert proporcionaron evidencia de que las redes neuronales artificiales de una sola capa no podían calcular XOR. Esta conclusión fue un golpe tan grande que muchos informáticos explicaron por este hecho el estancamiento en el que se ubicaron las redes neuronales hasta la década de 1980.Los investigadores de redes neuronales finalmente encontraron formas de superar el obstáculo encontrado por Minsky y Papert, y los neurocientíficos encontraron ejemplos de estas soluciones en la naturaleza. Por ejemplo, Poiratsi ya sabía que una sola neurona puede calcular XOR: solo dos dendritas son capaces de hacerlo. Pero en nuevos experimentos, él y sus colegas propusieron un mecanismo biofísico plausible para realizar dicho cálculo en una única dendrita."Para mí, este es otro grado de flexibilidad del sistema", dijo Poiratsi. "Muestra que el sistema tiene muchas formas de hacer los cálculos". Sin embargo, ella señala que si una sola neurona ya es capaz de resolver este problema, "¿por qué entonces el sistema debería hacer trucos creando módulos más complejos dentro de la neurona?"Procesadores dentro de procesadores

Por supuesto, no todas las neuronas son así. Gidon dice que en otras partes del cerebro hay bastantes neuronas más pequeñas y puntiagudas. Probablemente, tal complejidad de neuronas existe por una razón. Entonces, ¿por qué partes de las neuronas necesitan la capacidad de hacer lo que una neurona es capaz de hacer, o una pequeña red de neuronas? La opción obvia es una neurona que se comporta como una red multicapa, puede procesar más información y, en consecuencia, es mejor aprender y almacenar más. "Quizás tengamos una red profunda completa en una neurona separada", dijo Poiratsi. "Y este es un aparato mucho más poderoso para enseñar tareas complejas".Quizás Cording agrega: “La única neurona capaz de calcular funciones verdaderamente complejas. Por ejemplo, él podría reconocer independientemente el objeto ". Según Poiratsi, la presencia de neuronas individuales tan poderosas puede ayudar al cerebro a ahorrar energía.El grupo Larkum planea buscar señales similares en las dendritas de roedores y otros animales para determinar si estas habilidades computacionales son exclusivas de los humanos. También quieren ir más allá del modelo para relacionar la actividad observada de las neuronas con el comportamiento real. Poiratsi espera comparar los cálculos de dendritas con lo que está sucediendo en las redes de neuronas para comprender qué ventajas pueden surgir en el primer caso. Esto incluirá verificar otras operaciones lógicas y explorar cómo pueden contribuir al aprendizaje o al recuerdo. "Hasta que lo marquemos todo, no podemos apreciar la importancia del descubrimiento", dijo Poiratsi.Aunque todavía queda mucho trabajo por hacer, los investigadores creen que estos descubrimientos demuestran la necesidad de repensar el enfoque del modelado cerebral. Quizás no sea suficiente concentrarse solo en la conexión de varias neuronas y regiones cerebrales.Los nuevos resultados también deberían plantear nuevas preguntas en las áreas de aprendizaje automático e inteligencia artificial. Las redes neuronales artificiales trabajan con neuronas puntuales, considerándolas como nodos que suman la entrada y transmiten la suma a través de la función de activación. "Muy pocas personas tomaron en serio la idea de que una sola neurona podría ser un dispositivo informático sofisticado", dijo Gary Marcus , un científico cognitivo de la Universidad de Nueva York que ha sido muy escéptico sobre algunas de las afirmaciones de aprendizaje profundo.Aunque el trabajo de la revista Science es solo un descubrimiento en la rica historia de los trabajos que demuestran esta idea, los científicos informáticos pueden reaccionar de manera más activa porque funciona con el problema XOR, que durante tanto tiempo ha atormentado la investigación en redes neuronales. "Parece estar diciendo que tenemos que pensar seriamente en ello", dijo Marcus. "Todo este juego, obtener razonamiento inteligente de neuronas estúpidas, puede estar equivocado"."Y demuestra muy claramente este punto de vista", agregó. "Esta actuación ahogará todo el ruido de fondo".Source: https://habr.com/ru/post/undefined/

All Articles