Die Computer-Vision-Technologie ermöglicht es in der heutigen Realität, Leben und Geschäft einfacher, billiger und sicherer zu machen. Nach Ansicht verschiedener Experten wird sich dieser Markt in den kommenden Jahren nur in Richtung Wachstum bewegen, was die Entwicklung geeigneter Technologien in Richtung Produktivität und Qualität ermöglicht. Einer der beliebtesten Abschnitte ist die Objekterkennung (Objekterkennung) - die Definition eines Objekts im Bild oder im Videostream.Die Zeiten, in denen die Erkennung von Objekten ausschließlich durch klassisches maschinelles Lernen (Kaskaden, SVM ...) gelöst wurde, sind bereits vorbei - jetzt herrschen in diesem Bereich Ansätze vor, die auf Deep Learning basieren. 2014 wurde ein Ansatz vorgeschlagen, der die spätere Forschung und Entwicklung in diesem Bereich maßgeblich beeinflusst - das R-CNN-Modell. Seine nachfolgenden Verbesserungen (in Form von Fast R-CNN und Faster R-CNN) machten es zu einem der genauesten, was bis heute zum Grund für seine Verwendung geworden ist.Neben R-CNN gibt es viele weitere Ansätze, die nach Objekten suchen: die Yolo-Familie, SSD, RetinaNet, CenterNet ... Einige von ihnen bieten einen alternativen Ansatz, während andere den aktuellen Ansatz zur Erhöhung des Leistungsindikators entwickeln. Eine Diskussion über fast jeden von ihnen kann aufgrund der Fülle an Chips und Tricks in einem separaten Artikel veröffentlicht werden :)Zum Studium schlage ich eine Reihe von Artikeln mit der Analyse von zweistufigen Objekterkennungsmodellen vor. Die Fähigkeit, ihr Gerät zu verstehen, vermittelt ein Verständnis der Grundideen, die in anderen Implementierungen verwendet werden. In diesem Beitrag werden wir die grundlegendsten und dementsprechend die erste von ihnen betrachten - R-CNN.

Die Computer-Vision-Technologie ermöglicht es in der heutigen Realität, Leben und Geschäft einfacher, billiger und sicherer zu machen. Nach Ansicht verschiedener Experten wird sich dieser Markt in den kommenden Jahren nur in Richtung Wachstum bewegen, was die Entwicklung geeigneter Technologien in Richtung Produktivität und Qualität ermöglicht. Einer der beliebtesten Abschnitte ist die Objekterkennung (Objekterkennung) - die Definition eines Objekts im Bild oder im Videostream.Die Zeiten, in denen die Erkennung von Objekten ausschließlich durch klassisches maschinelles Lernen (Kaskaden, SVM ...) gelöst wurde, sind bereits vorbei - jetzt herrschen in diesem Bereich Ansätze vor, die auf Deep Learning basieren. 2014 wurde ein Ansatz vorgeschlagen, der die spätere Forschung und Entwicklung in diesem Bereich maßgeblich beeinflusst - das R-CNN-Modell. Seine nachfolgenden Verbesserungen (in Form von Fast R-CNN und Faster R-CNN) machten es zu einem der genauesten, was bis heute zum Grund für seine Verwendung geworden ist.Neben R-CNN gibt es viele weitere Ansätze, die nach Objekten suchen: die Yolo-Familie, SSD, RetinaNet, CenterNet ... Einige von ihnen bieten einen alternativen Ansatz, während andere den aktuellen Ansatz zur Erhöhung des Leistungsindikators entwickeln. Eine Diskussion über fast jeden von ihnen kann aufgrund der Fülle an Chips und Tricks in einem separaten Artikel veröffentlicht werden :)Zum Studium schlage ich eine Reihe von Artikeln mit der Analyse von zweistufigen Objekterkennungsmodellen vor. Die Fähigkeit, ihr Gerät zu verstehen, vermittelt ein Verständnis der Grundideen, die in anderen Implementierungen verwendet werden. In diesem Beitrag werden wir die grundlegendsten und dementsprechend die erste von ihnen betrachten - R-CNN.Terminologie

Der Begrenzungsrahmen - die Koordinaten, die einen bestimmten Bereich eines Bildes begrenzen - meist in Form eines Rechtecks. Es kann durch 4 Koordinaten in zwei Formaten dargestellt werden: zentriert () und regelmäßig ()Hypothese (Vorschlag), P - ein bestimmter Bereich des Bildes (angegeben mit dem Begrenzungsrahmen), in dem sich das Objekt angeblich befindet.End-to-End-Schulung - Schulung, bei der Rohbilder am Netzwerkeingang ankommen und vorgefertigte Antworten ausgegeben werden.IoU (Intersection-over-Union) - Metrik des Schnittgrads zwischen zwei Begrenzungsrahmen.R-CNN

Einer der ersten Ansätze zur Bestimmung der Position eines Objekts in einem Bild ist R-CNN (Region Convolution Neural Network). Die Architektur besteht aus mehreren aufeinander folgenden Schritten und ist in Abbildung 1 dargestellt:- Definieren einer Reihe von Hypothesen.

- Extrahieren von Merkmalen aus potenziellen Regionen unter Verwendung eines Faltungs-Neuronalen Netzwerks und Codieren dieser in einen Vektor.

- Die Klassifizierung eines Objekts innerhalb einer Hypothese basierend auf dem Vektor aus Schritt 2.

- Verbesserung (Anpassung) der Koordinaten der Hypothese.

- Alles wiederholt sich ab Schritt 2, bis alle Hypothesen aus Schritt 1 verarbeitet sind.

Betrachten Sie jeden Schritt genauer.

Hypothesensuche

Mit einem bestimmten Bild am Eingang zerfällt es als erstes in kleine Hypothesen unterschiedlicher Größe. Die Autoren dieses Artikels verwenden die selektive Suche - auf oberster Ebene können Sie eine Reihe von Hypothesen zusammenstellen (die Klasse des Objekts spielt noch keine Rolle), basierend auf der Segmentierung, um die Grenzen von Objekten nach Pixelintensität, Farbdifferenz, Kontrast und Textur zu bestimmen. Gleichzeitig stellen die Autoren fest, dass jeder ähnliche Algorithmus verwendet werden kann. So fallen ca. 2.000 verschiedene Regionen auf, die sich teilweise überlappen. Für eine genauere nachfolgende Verarbeitung wird jede Hypothese in allen vier Richtungen um 16 Pixel erweitert - als würde sie einen Kontext hinzufügen .Gesamt:- Eingabe: Originalbild.

- Ausgabe: Eine Reihe von Hypothesen unterschiedlicher Größe und Seitenverhältnisse.

Bildcodierung

Jede Hypothese aus dem vorherigen Schritt tritt unabhängig und getrennt voneinander in die Eingabe des Faltungs-Neuronalen Netzwerks ein. Da es die Architektur von AlexNet ohne die letzte Softmax-Schicht nutzt. Die Hauptaufgabe des Netzwerks besteht darin, das eingehende Bild in eine Vektordarstellung zu codieren, die aus der letzten vollständig verbundenen FC7- Schicht extrahiert wird. Die Ausgabe ist also eine 4096-dimensionale Vektordarstellung.Sie können feststellen, dass die Eingabe von AlexNet eine Dimension von 3 × 227 × 227 hat und die Größe der Hypothese nahezu jedes Seitenverhältnis und jede Größe haben kann. Dieses Problem wird umgangen, indem die Eingabe einfach auf die gewünschte Größe komprimiert oder gedehnt wird.Gesamt:- Eingabe: Jede im vorherigen Schritt vorgeschlagene Hypothese.

- Ausgabe: Vektordarstellung für jede Hypothese.

Einstufung

Nachdem der die Hypothese charakterisierende Vektor erhalten wurde, wird seine weitere Verarbeitung möglich. Um festzustellen, welches Objekt sich in der beabsichtigten Region befindet, verwenden die Autoren die klassische SVM-basierte Klassifizierungsmethode für Trennebenen (Support Vector Machine - eine Support Vector Machine, die mithilfe des Scharnierverlusts modelliert werden kann ). Und das sollte es auch sein individuell (hier, bezeichnet die Anzahl der definierten Klassen von Objekten, und eine Einheit wird hinzugefügt, um den Hintergrund separat zu bestimmen) von Modellen, die nach dem OvR-Prinzip trainiert wurden (Eins gegen Ruhe - eins gegen alle, eine der Methoden der Klassifizierung mehrerer Klassen). Tatsächlich wird das Problem der binären Klassifizierung gelöst - gibt es eine konkrete Klasse eines Objekts innerhalb der vorgeschlagenen Region oder nicht? Der Ausweg ist also-dimensionaler Vektor, der das Vertrauen in eine bestimmte Klasse des in der Hypothese enthaltenen Objekts darstellt (der Hintergrund wird historisch durch die Nullklasse bezeichnet,)Gesamt:- Eingabe: Der Vektor jeder der vorgeschlagenen Hypothesen aus der vorletzten Schicht des Netzwerks (im Fall von AlexNet ist dies FC7).

- Ausgabe: Nach dem sequentiellen Starten jeder Hypothese erhalten wir eine Dimensionsmatrix Darstellen der Klasse des Objekts für jede Hypothese.

Angabe von Hypothesenkoordinaten

Die in Schritt 1 erhaltenen Hypothesen enthalten nicht immer die richtigen Koordinaten (z. B. kann ein Objekt erfolglos "beschnitten" werden), daher ist es sinnvoll, sie zusätzlich zu korrigieren. Laut den Autoren bringt dies zusätzliche 3-4% zu den Metriken. Hypothesen, die ein Objekt enthalten (das Vorhandensein eines Objekts wird im Klassifizierungsschritt bestimmt), werden also zusätzlich durch lineare Regression verarbeitet. Das heißt, Hypothesen mit der Klasse "Hintergrund" erfordern keine zusätzliche Verarbeitung von Regionen, da dort tatsächlich kein Objekt vorhanden ist ...Jedes Objekt, das für seine Klasse spezifisch ist, hat bestimmte Größen und Seitenverhältnisse. Daher ist es logisch, für jede Klasse einen eigenen Regressor zu verwenden .Im Gegensatz zum vorherigen Schritt verwenden die Autoren keinen Vektor aus der FC7- Ebene, damit die Eingabe am besten funktioniertund Feature-Maps, die aus dem letzten MaxPooling-Layer extrahiert wurden (in AlexNet, Dimension 256 × 6 × 6). Die Erklärung lautet wie folgt: Der Vektor speichert Informationen über das Vorhandensein eines Objekts mit einigen charakteristischen Details, und die Feature-Map speichert am besten Informationen über den Standort von Objekten.Gesamt:- Eingabe: Eine Zuordnung von Attributen aus der letzten MaxPooling-Ebene für jede Hypothese, die ein beliebiges Objekt außer dem Hintergrund enthält.

- Ausgabe: Korrekturen an den Koordinaten des Begrenzungsrahmens der Hypothese.

Hilfstricks

Bevor wir mit den Details des Modelltrainings fortfahren, werden wir zwei notwendige Tricks betrachten, die wir später benötigen werden.Bezeichnung positiver und negativer Hypothesen

Beim Unterrichten mit einem Lehrer ist immer ein gewisses Gleichgewicht zwischen den Klassen erforderlich. Das Gegenteil kann zu einer schlechten Klassifizierungsgenauigkeit führen. Wenn beispielsweise in einer Stichprobe mit zwei Klassen die erste nur in wenigen Prozent der Fälle auftritt, ist es für das Netzwerk schwierig zu lernen, wie sie ermittelt wird, da sie als Ausreißer interpretiert werden kann. Bei Objekterkennungsaufgaben gibt es genau ein solches Problem - im Bild mit einem einzelnen Objekt enthalten nur wenige Hypothesen (ab ~ 2000) genau dieses Objekt () und alle anderen sind der Hintergrund ()Nehmen wir die notwendige Notation: Hypothesen, die Objekte enthalten, werden als positiv (positiv) und ohne Objekte (die nur den Hintergrund oder einen unbedeutenden Teil des Objekts enthalten) als negativ (negativ) bezeichnet.Um anschließend den Schnittpunkt zwischen den beiden Bildbereichen zu bestimmen, wird die Metrik Schnittpunkt über Union verwendet . Es wird als recht einfach angesehen: Die Schnittfläche zweier Regionen wird durch die Gesamtfläche der Regionen geteilt. In der Abbildung unten sehen Sie Abbildungen von Beispielen für die Metrikzählung. Bei positiven Hypothesen ist alles klar - wenn die Klasse falsch definiert ist, müssen Sie mit einer Geldstrafe belegt werden. Aber was ist mit dem Negativen? Es gibt viel mehr als positive ... Zunächst stellen wir fest, dass nicht alle negativen Hypothesen gleich schwer zu erkennen sind. Beispielsweise sind Fälle, die nur den Hintergrund enthalten ( leicht negativ ), viel einfacher zu klassifizieren als Fälle, die ein anderes Objekt oder einen kleinen Teil des gewünschten Objekts enthalten ( hart negativ ).In der Praxis werden leichtes Negativ und hartes Negativ durch den Schnittpunkt des Begrenzungsrahmens (gerade verwendete Schnittmenge über Union) mit der korrekten Position des Objekts im Bild bestimmt. Wenn es beispielsweise keine Kreuzung gibt oder diese extrem klein ist, ist dies leicht negativ () wenn groß schwer negativ oder positiv ist.Der Hard Negative Mining- Ansatz schlägt vor, nur hartes Negativ für das Training zu verwenden, da wir, nachdem wir gelernt haben, sie zu erkennen, automatisch die beste Arbeit mit einfachen negativen Hypothesen erzielen. Eine solche Ideologie wird jedoch nur in nachfolgenden Implementierungen angewendet (beginnend mit Fast R-CNN).

Bei positiven Hypothesen ist alles klar - wenn die Klasse falsch definiert ist, müssen Sie mit einer Geldstrafe belegt werden. Aber was ist mit dem Negativen? Es gibt viel mehr als positive ... Zunächst stellen wir fest, dass nicht alle negativen Hypothesen gleich schwer zu erkennen sind. Beispielsweise sind Fälle, die nur den Hintergrund enthalten ( leicht negativ ), viel einfacher zu klassifizieren als Fälle, die ein anderes Objekt oder einen kleinen Teil des gewünschten Objekts enthalten ( hart negativ ).In der Praxis werden leichtes Negativ und hartes Negativ durch den Schnittpunkt des Begrenzungsrahmens (gerade verwendete Schnittmenge über Union) mit der korrekten Position des Objekts im Bild bestimmt. Wenn es beispielsweise keine Kreuzung gibt oder diese extrem klein ist, ist dies leicht negativ () wenn groß schwer negativ oder positiv ist.Der Hard Negative Mining- Ansatz schlägt vor, nur hartes Negativ für das Training zu verwenden, da wir, nachdem wir gelernt haben, sie zu erkennen, automatisch die beste Arbeit mit einfachen negativen Hypothesen erzielen. Eine solche Ideologie wird jedoch nur in nachfolgenden Implementierungen angewendet (beginnend mit Fast R-CNN).Nicht maximale Unterdrückung

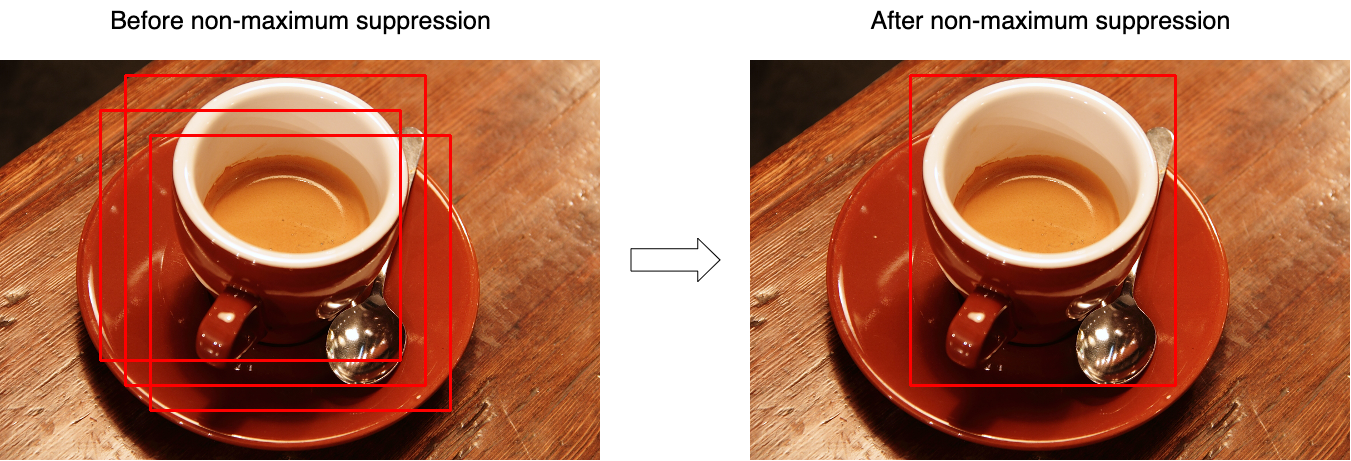

Sehr oft stellt sich heraus, dass das Modell mehrere Hypothesen mit großer Sicherheit identifiziert, die auf dasselbe Objekt verweisen. Mit NMS ( Non-Maximum Suppression ) können Sie solche Fälle behandeln und nur einen, besten Begrenzungsrahmen belassen. Vergessen Sie jedoch nicht den Fall, dass das Bild zwei verschiedene Objekte derselben Klasse enthalten kann. Fig. 3 zeigt die Auswirkung der Operation vor (links) und nach (rechts) der Operation des Algorithmus. Betrachten Sie den Algorithmus für die Arbeit an einer Klasse (in Wirklichkeit wird er auf jede Klasse separat angewendet):

Betrachten Sie den Algorithmus für die Arbeit an einer Klasse (in Wirklichkeit wird er auf jede Klasse separat angewendet):- Am Eingang nimmt die Funktion eine Reihe von Hypothesen für eine Klasse und einen Schwellenwert, der den maximalen Schnittpunkt zwischen Hypothesen festlegt.

- Hypothesen werden nach ihrem "Vertrauen" sortiert.

- Im Zyklus wird die erste Hypothese ausgewählt (sie hat den höchsten Konfidenzwert) und der Ergebnismenge hinzugefügt.

- Im Zyklus wird die nächste, zweite Hypothese ausgewählt (unter den nach Schritt 3 verbleibenden).

- Wenn der Schnittpunkt zwischen den ausgewählten Hypothesen größer als der ausgewählte Schwellenwert ist (der Schnittpunkt wird auf der Grundlage des Schnittpunkts der Union berechnet), wird die zweite Hypothese verworfen und ist in der Ergebnismenge nicht weiter vorhanden.

- Alles wiederholt sich von Schritt 3 bis die Hypothesen vollständig aufgezählt sind.

Der Pseudocode sieht folgendermaßen aus:function nms(hypotheses, threshold):

sorted = sort(hypotheses.values, key=hypotheses.scores)

result = []

for first in sorted:

result.join(first)

without_first = sorted / first

for second in without_first:

if IoU(first, second) > threshold:

sorted.remove(second)

return result

Ausbildung

Der Hypothesenisolationsblock ist nicht lernbar.Da das Netzwerk in mehrere voneinander getrennte Blöcke unterteilt ist, kann es nicht durchgängig trainiert werden. Lernen ist also ein sequentieller Prozess.Vector View Training

Das auf ImageNet vorab trainierte Netzwerk wird als Grundlage verwendet - solche Netzwerke können bereits wichtige Funktionen aus eingehenden Bildern extrahieren - und es muss noch trainiert werden, um mit den erforderlichen Klassen zu arbeiten. Ändern Sie dazu die Dimension der Ausgabeebene inund trainiere eine bereits modifizierte Version. Die ersten Ebenen können blockiert werden, da sie die primären (für alle Bilder nahezu identischen) Merkmale extrahieren und die nachfolgenden während des Trainings an die Merkmale der gewünschten Klassen anpassen. Die Konvergenz wird also viel schneller erreicht. Wenn das Training jedoch immer noch schlecht läuft, können Sie die primären Ebenen freischalten. Da ist es notwendig, die vorhandenen Gewichte genau einzustellen. Es wird nicht empfohlen, eine hohe Lernrate (Lernrate) zu verwenden - Sie können vorhandene Gewichte sehr schnell abwischen.Wenn das Netzwerk gelernt hat, Objekte gut zu klassifizieren, wird die letzte Schicht mit SoftMax-Aktivierung verworfen und die FC7-Schicht wird zur Ausgabe, deren Ausgabe wiederum als Vektordarstellung der Hypothese interpretiert werden kann.Positiv in diesem Schritt sind Hypothesen, die sich mit der korrekten Position des Objekts (IoU) um mehr als 0,5 überschneiden. Alle anderen gelten als negativ. Zur Aktualisierung der Skalen wird ein 128-Mini-Batch verwendet, der aus 32 positiven und 96 negativen Hypothesen besteht.Klassifikator Training

Ich möchte Sie daran erinnern, dass für die Klassifizierung jeder Hypothese verwendet wird SVM-Modelle, die die Eingabe der Vektordarstellung der Hypothese erhalten und auf dem Prinzip von einem gegen den anderen (One-vs-Rest) basieren, bestimmen die Klasse des Objekts. Sie werden mit einer Ausnahme als gewöhnliche SVM-Modelle trainiert - in diesem Schritt unterscheidet sich die Definition von Positiven und Negativen geringfügig. Hier werden die Hypothesen als Negative genommen, deren Schnittpunkt mit der richtigen Position weniger als 0,3 beträgt.Regress Training

Bezeichnen:- - die korrekten Koordinaten des Objekts;

- - korrigierte Position der Hypothesenkoordinaten (muss mit übereinstimmen );

- - Korrekturen der Koordinaten korrigieren;

- - Koordinaten der Hypothese;

Regressoren (einer für jede Klasse) repräsentieren also vier Funktionen:- , - Bestimmen Sie die Korrekturen an den Mittelkoordinaten () Um den Effekt der Unabhängigkeit von der Originalgröße zu erzielen, sollte die Korrektur normalisiert werden.

- und - Bestimmen Sie die Korrekturen für Breite und Höhe im logarithmischen Raum (der logarithmische Raum wird für die numerische Stabilität und Division verwendet - um die Richtung der Korrektur zu bestimmen).

Bezeichnen mit Feature-Map erhalten von Netzwerkschicht (erinnern Sie sich, sie hat eine Dimension von 256 × 6 × 6, dann wird sie einfach gestreckt), wenn eine Hypothese durch Anwenden auf das Netzwerk auf die Koordinaten beschränkt wird . Wir werden nach einer Transformation suchen beim ^ g xwie:\ begin {align}

Außerdem

(Hier ) ist eine lineare Funktion und der Vektor wird mit dem Optimierungsproblem (Ridge Regression) gesucht:

Um die Korrekturen an den Koordinaten zu bestimmen, sammeln wir Paare zwischen der korrekten Position der Hypothesen und ihren aktuellen Zustand und definieren Sie die Werte wie:\ begin {align} Die Notation in den Formeln in diesem Artikel kann zum Verständnis von der Notation des Originalartikels abweichen. Da es ~ 2000 Hypothesen zur Ausgabe des Netzwerks gibt, werden sie unter Verwendung der nicht maximalen Unterdrückung kombiniert. Die Autoren des Artikels weisen auch darauf hin, dass die Genauigkeit um ~ 4-4,5% sinkt (VOC 2007-Datensatz), wenn Sie anstelle von SVM die SoftMax-Ebene verwenden (die im zweiten Schritt ausgeklappt wurde). Sie stellen jedoch fest, dass die beste „Anpassung“ der Skalen wahrscheinlich zur Beseitigung beiträgt von einem solchen Problem.

Abschließend heben wir die Hauptnachteile dieses Ansatzes hervor:

- Die in Schritt 1 vorgeschlagenen Hypothesen können sich teilweise duplizieren - verschiedene Hypothesen können aus identischen Teilen bestehen, und jede dieser Hypothesen wurde separat von einem neuronalen Netzwerk verarbeitet. Es stellt sich heraus, dass sich die meisten Netzwerkstarts mehr oder weniger unnötig duplizieren.

- Es kann nicht für den Echtzeitbetrieb verwendet werden, da ~ 53 Sekunden für die Übergabe von 1 Bild (Frame) (NVIDIA Titan Black GPU) aufgewendet werden.

- Der Algorithmus zur Hypothesenextraktion wird in keiner Weise gelehrt, und daher ist eine weitere Verbesserung der Qualität fast unmöglich (niemand hat schlechte Hypothesen annulliert).

Dies analysiert das allererste R-CNN-Modell. Weiterführende Implementierungen (in Form von Fast R-CNN und Faster R-CNN) werden in einem separaten Artikel behandelt .Referenzliste

1. R. Girshick, J. Donahue, T. Darrell und J. Malik. "Umfangreiche Feature-Hierarchien für eine genaue Objekterkennung und semantische Segmentierung." In CVPR, 2014. arXiv: 1311.25242. R. Girshick, J. Donahue, T. Darrell und J. Malik. "Regionale Faltungsnetzwerke für die genaue Objekterkennung und -segmentierung." TPAMI, 2015 Gepostetvon: Sergey Mikhaylin, Spezialist für maschinelles Lernen, Jet Infosystems