Die Komplexität der Präsentation von Daten für tiefes Lernen wächst von Tag zu Tag. Graph Neural Networks ( GNNs ) sind zu einem der Durchbrüche der letzten Jahre geworden. Aber warum genau werden Grafiken beim maschinellen Lernen immer beliebter?

Das ultimative Ziel meiner Erzählung ist eine allgemeine Darstellung von Graphen in maschinellen Lerntechniken. Der Artikel gibt nicht vor, eine wissenschaftliche Arbeit zu sein, die die volle Kraft von Graphen vollständig beschreibt, sondern führt den Leser nur in diese erstaunliche und komplexe Welt ein. Die Veröffentlichung ist perfekt, sowohl für kampferprobte Profis, die noch nicht mit der Darstellung von Grafiken im Deep Learning vertraut sind, als auch für Anfänger auf diesem Gebiet.

Einführung

Das automatische Hervorheben wichtiger Funktionen zur Lösung eines Problems ist einer der Hauptgründe für den erfolgreichen Einsatz von maschinellem Lernen. Bei der Arbeit mit Diagrammen stützten sich Ansätze des maschinellen Lernens traditionell auf benutzerdefinierte Heuristiken, um die Codierungsmerkmale von Strukturdiagramminformationen zu extrahieren. Trotzdem hat sich der Trend der letzten Jahre geändert: Es entstehen zunehmend Ansätze, bei denen sie automatisch lernen, die Graphstruktur in niedrigdimensionalen Investitionen mithilfe von Methoden des tiefen Lernens und der nichtlinearen Dimensionsreduktion zu codieren.

Beim maschinellen Lernen in Graphen können zwei zentrale Probleme unterschieden werden: die Einbeziehung von Informationen über die Struktur des Graphen in das Modell (d. H. Eine einfache Methode zum Codieren dieser Informationen in den Merkmalsvektor) und die Verringerung der Dimension des Merkmalsvektors.

( ), . , , .

?

, , : ?

— . , , ( ) [1], [2], ( [3], [4] [5]), [6] [7].

CV/ML , , . , , [8].

, . . , , , .

, (embeddings), . , , , , (), . , , . , .

, . , , . , , , .

, (direct encoding), . . , , -. , , , .

DeepWalk node2vec . , . , .

( ). (DNGR SDNE), , [9].

, , , — ( ) , .

(.1). :

, , , ( , ). .

, . , ( , ). , , , , .

, , . , , . (, )

- , , / . ; ( ) , ( ). , .

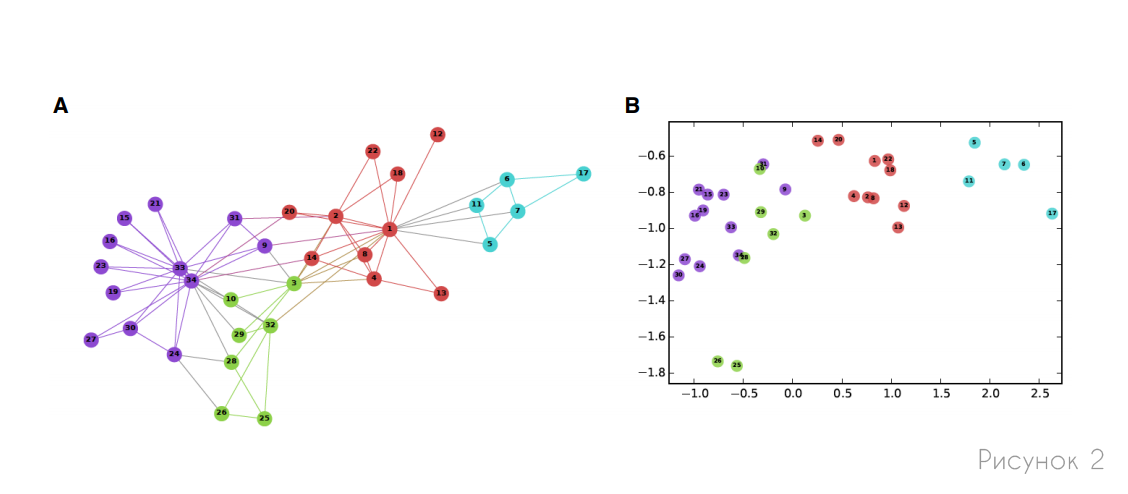

, , , . , (, ) . 2 , , .

, — , , ( ):

— , :

. , , . , , . , :

— , . , , 1, 0. . ( 1) :

— , (.. ) .

, -, , . , , , , , .

seq2seq , , . , seq2seq, GNN [10].

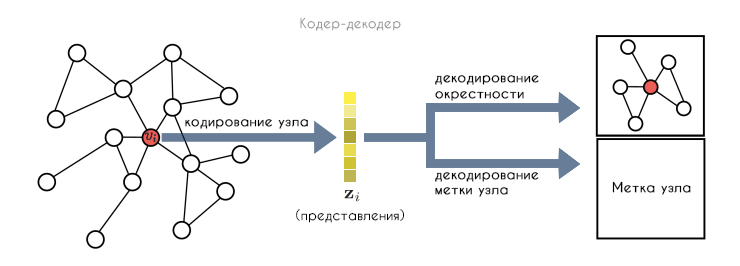

, :

- : , .

- ENC, . , .

- DEC, .

- , , .

. , . , .

, , . , , (.3). , , , .

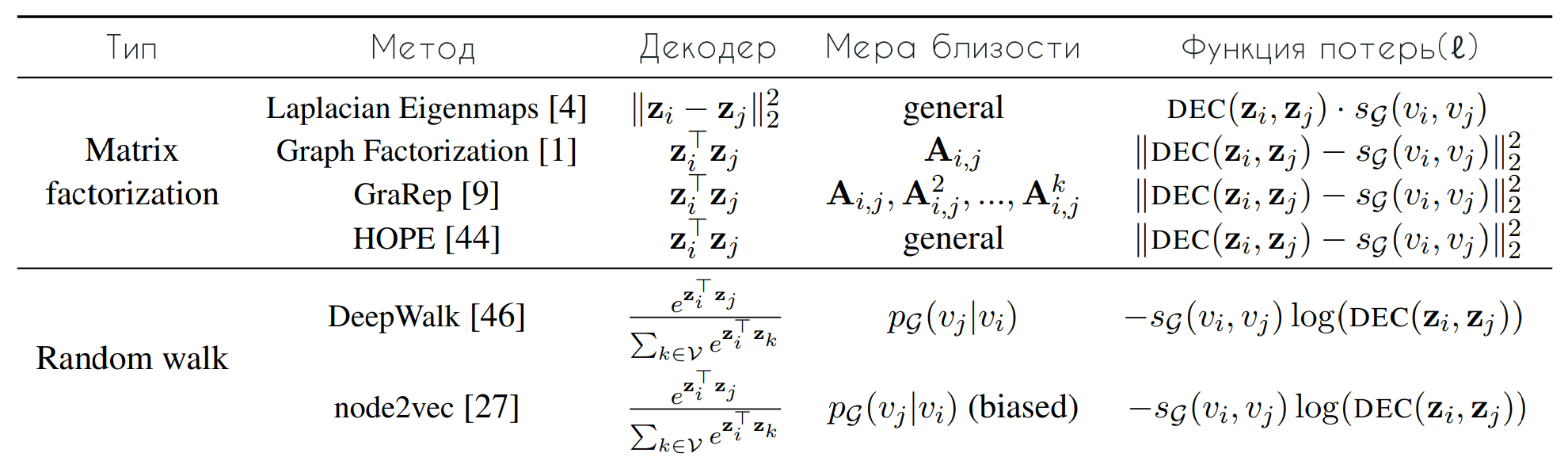

DeepWalk node2vec, , , . , , . , , :

— , , . , . , :

, (.. . — ( (2) ). , DeepWalk node2vec (3). DeepWalk softmax , . , node2vec (3), : , , " ".

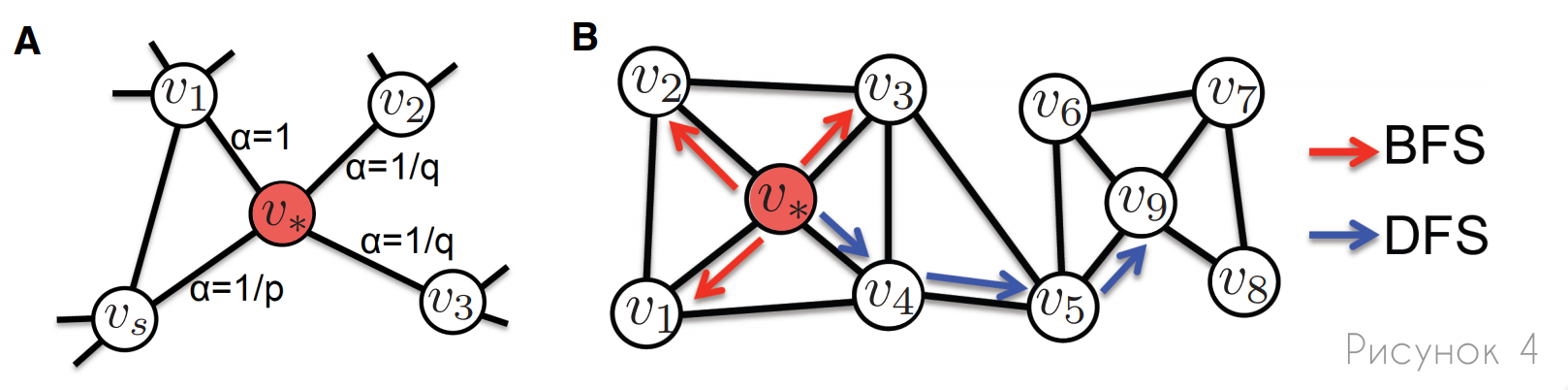

, node2vec DeepWalk , , . , node2vec : , (.4). , . , node2vec , .

A: , node2vec , p q. , , (α) , .

B: , (BFS) (DFS). , BFS, , , . , , DFS, .

, . , :

- (.. ). , , .

- . (, ), .

- . , , ( , ). , , , , .

/ . -, , , .

(DNGR) (SDNE) , : , . , — , (.5). DNGR SDNE , .

, ( — ). . DNGR SDNE , , :

, :

, , ( ), , . SDNE, DNGR, : , (.5).

SDNE DNGR , , , . DNGR , , DeepWalk node2vec. SDNE , .

, SDNE DNGR , ( ), - . , .

, . . , , , [9], . , .

. , , , , , , .

, , , .

. (. ), ( ). . , , , , , , — , , , . , , , .

. , , - , , . , , , , .

. , , , . , , , . , .

. , , . , , . , , , . , , , , .

, — . , , .

[1] — W. L. Hamilton, Z. Ying, and J. Leskovec, "Inductive representation learning on large graphs," NIPS 2017, pp. 1024–1034, 2017.

[2] — T. N. Kipf and M. Welling, "Semi-supervised classification with graph convolutional networks," ICLR 2017, 2017.

[3] — A. Sanchez-Gonzalez, N. Heess, J. T. Springenberg, J. Merel, M. Riedmiller, R. Hadsell, and P. Battaglia, "Graph networks as learnable physics engines for inference and control," arXiv

preprint arXiv:1806.01242, 2018.

[4] — P. Battaglia, R. Pascanu, M. Lai, D. J. Rezende et al., "Interaction networks for learning about objects, relations and physics," in NIPS 2016, 2016, pp. 4502–4510.

[5] — A. Fout, J. Byrd, B. Shariat, and A. Ben-Hur, "Protein interface prediction using graph convolutional networks," in NIPS 2017, 2017, pp. 6530–6539.

[6] — T. Hamaguchi, H. Oiwa, M. Shimbo, and Y. Matsumoto, "Knowledge transfer for out-of-knowledge-base entities: A graph neural network approach," in IJCAI 2017, 2017, pp. 1802–1808.

[7] — H. Dai, E. B. Khalil, Y. Zhang, B. Dilkina, and L. Song, "Learning combinatorial optimization algorithms over graphs," arXiv preprint arXiv:1704.01665, 2017.

[8] — X. Liang, X. Shen, J. Feng, F. Lin, S. Yan, "Semantic Object Parsing with Graph LSTM", arXiv:1603.07063v1 [cs.CV] 23 Mar 2016.

[9] — Z. Wu, S. Pan, F. Chen, G. Long, C. Zhang, Philip S. Yu, "A Comprehensive Survey on Graph Neural Networks", arXiv:1901.00596v4 [cs.LG] 4 Dec 2019.

[10] - P. Veličković, G. Cucurull, A. Casanova, A. Romero, P. Liò, Y. Bengio, "Graph Attention Networks", arXiv: 1710.10903v3 [stat.ML] 4. Februar 2018.

Verweise

Graph Neuronale Netze: Ein Überblick über Methoden und Anwendungen

Repräsentationslernen in Graphen: Methoden und Anwendungen