كان عام 2018 نقطة تحول في تطوير نماذج التعلم الآلي التي تهدف إلى حل مشاكل معالجة النصوص (أو ، بشكل أكثر دقة ، معالجة اللغة الطبيعية (NLP)). إن الفهم المفاهيمي لكيفية تقديم الكلمات والجمل من أجل الاستخراج الأكثر دقة لمعانيها الدلالية والعلاقات بينهما ينمو بسرعة. علاوة على ذلك ، يشجع مجتمع البرمجة اللغوية العصبية (NLP) الأدوات القوية للغاية التي يمكن تنزيلها واستخدامها مجانًا في نماذجها وخطوط الأنابيب الخاصة بها. تسمى نقطة التحول هذه أيضًا لحظة ImageNet في البرمجة اللغوية العصبية ، في إشارة إلى اللحظة قبل عدة سنوات ، عندما ساهمت تطورات مماثلة بشكل كبير في تطوير التعلم الآلي في مجال مشاكل رؤية الكمبيوتر.

(ULM-FiT ليس له علاقة بـ Korzhik ، ولكن لم يحدث شيء أفضل)

– BERT', , NLP. BERT – , NLP-. , , BERT', . , , , .

BERT'. 1: ( ); 2: .

BERT , NLP-, , : Semi-supervised Sequence learning ( – Andrew Dai Quoc Le), ELMo ( – Matthew Peters AI2 UW CSE), ULMFiT ( – fast.ai Jeremy Howard Sebastian Ruder), OpenAI Transformer ( – OpenAI Radford, Narasimhan, Salimans, Sutskever) (Vaswani et al).

, , BERT'. , , .

:

BERT – . :

, , (classifier) BERT' . (fine-tuning), Semi-supervised Sequence Learning ULMFiT.

, : , . . («» « »).

BERT':

- (sentiment analysis)

- (fact-checking):

- : . : «» (Claim) « » (Not Claim)

- / :

- : (Claim sentence). : «» «»

- Full Fact – , . , , ( , , , )

- :

, BERT', , .

BERT' :

- BERT BASE () – OpenAI Transformer;

- BERT LARGE () – , (state of the art), .

, BERT – . . , – BERT’ , .

BERT' ( « » (Transformer Blocks)): 12 24 . (768 1024 ) «» (attention heads)(12 16 ), , (6 , 512 , 8 «» ).

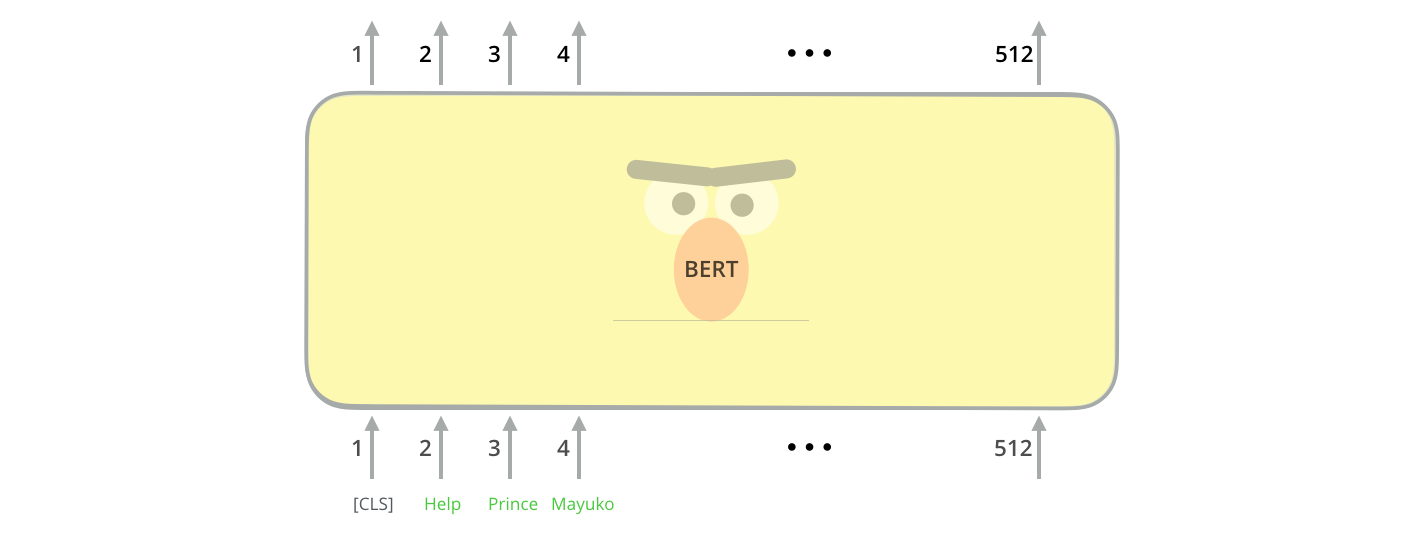

[CLS] , . CLS .

, , BERT , . (self-attention) , .

, ( , ). .

hidden_size (768 BERT'). , , ( [CLS]).

. , .

(, «», « », « », «» .), .

, , , VGGNet .

. , NLP- , : Word2Vec GloVe. , , , .

, . Word2Vec , ( ), , (.. , «» – «» «» – «»), (, , «» «» , «» «»).

, , , . , Word2Vec GloVe. GloVe «stick» ( – 200):

«stick» GloVe – 200 ( 2 ).

.

ELMo:

GloVe, «stick» . « », – NLP- ( Peters et. al., 2017, McCann et. al., 2017 Peters et. al., 2018 ELMo). – « «stick» , . , – , , ?». (contextualized word-embeddings).

.

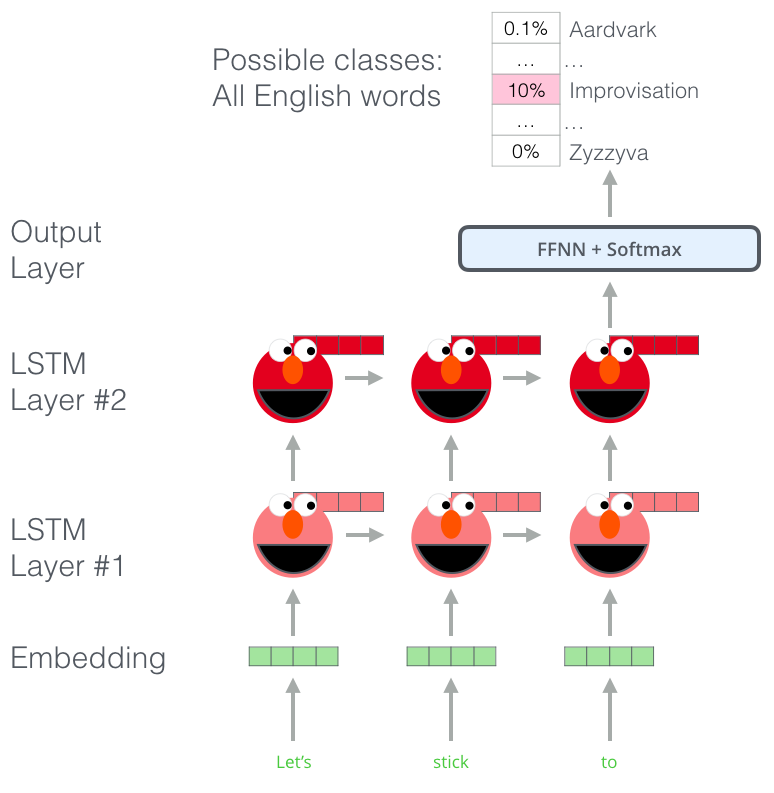

, , ELMo , . (bi-directional LSTM), .

ELMo NLP. ELMo LSTM , , .

ELMo?

ELMo – , (language modeling). , , .

ELMo: «Let's stick to», – . . , . , , , , «hang», «out» ( «hang out»), «camera».

, LSTM - ELMo. , .

, ELMo LSTM – , «» , .

ELMo

ELMo ( ) ( ).

ULM-FiT: NLP

ULM-FiT , – . ULM-FiT .

NLP , , , .

, , , , NLP- LSTM. .

- . ? , (.. , )?

, , NLP-. . : , ( ).

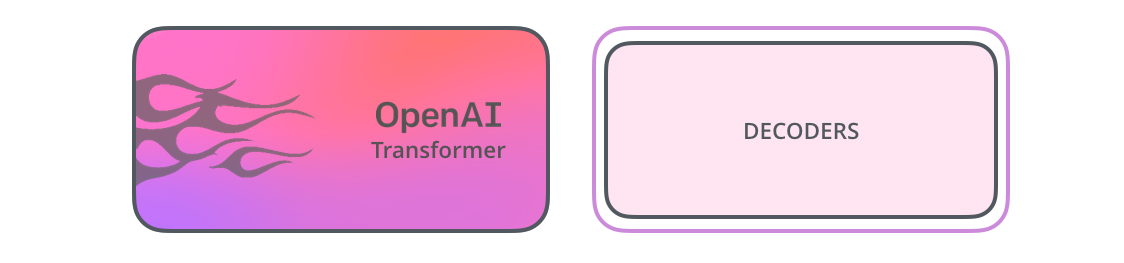

OpenAI Transformer

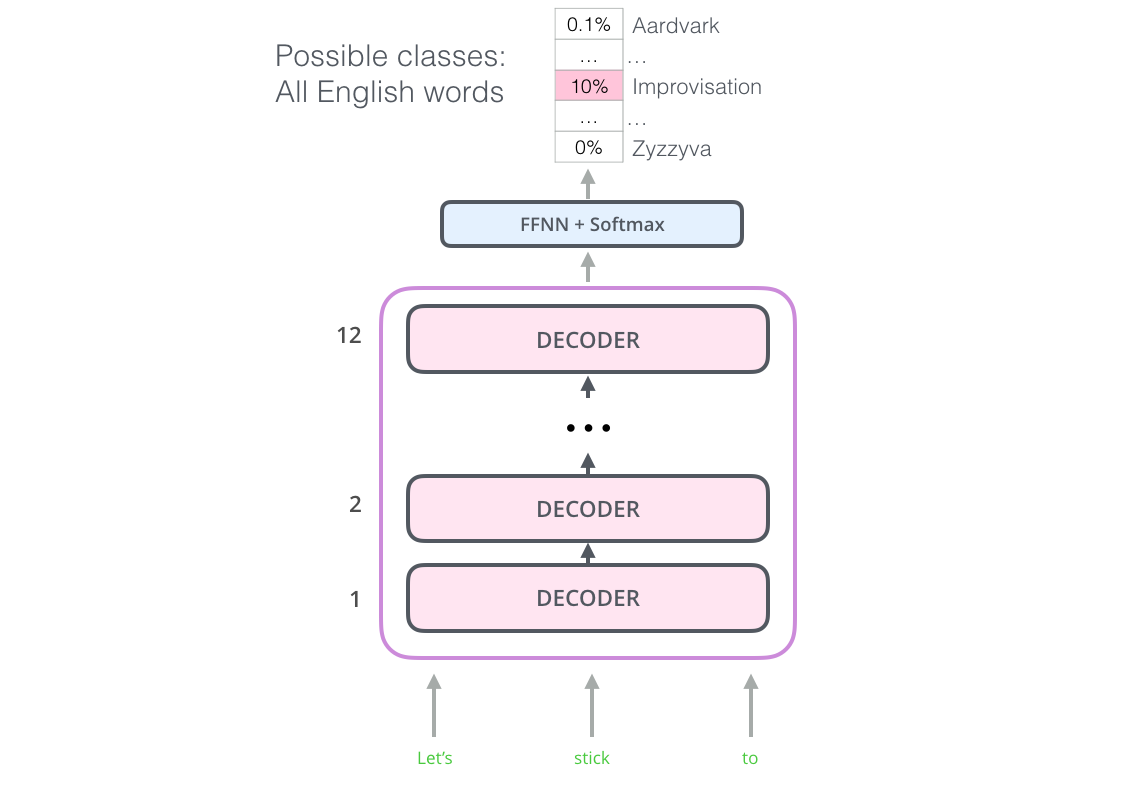

12 . - , . , ( ).

: , . 7 . , .. , – , , .

OpenAI Transformer 7000

, OpenAI Transformer , . ( «» « »):

OpenAI , . :

, ?

BERT:

OpenAI Transformer , . - LSTM . ELMo , OpenAI Transformer . , , ( – « , »)?

« », – .

(masked language model)

« », – .

« !» – . – « , .»

« », – .

BERT «» 15% .

– , BERT , « » (masked language model) ( «-»).

15% , BERT , . .

OpenAI Transformer, , - (, ? , ?).

, BERT , : ( ); , ?

, BERT – . , .. BERT WordPieces, – .

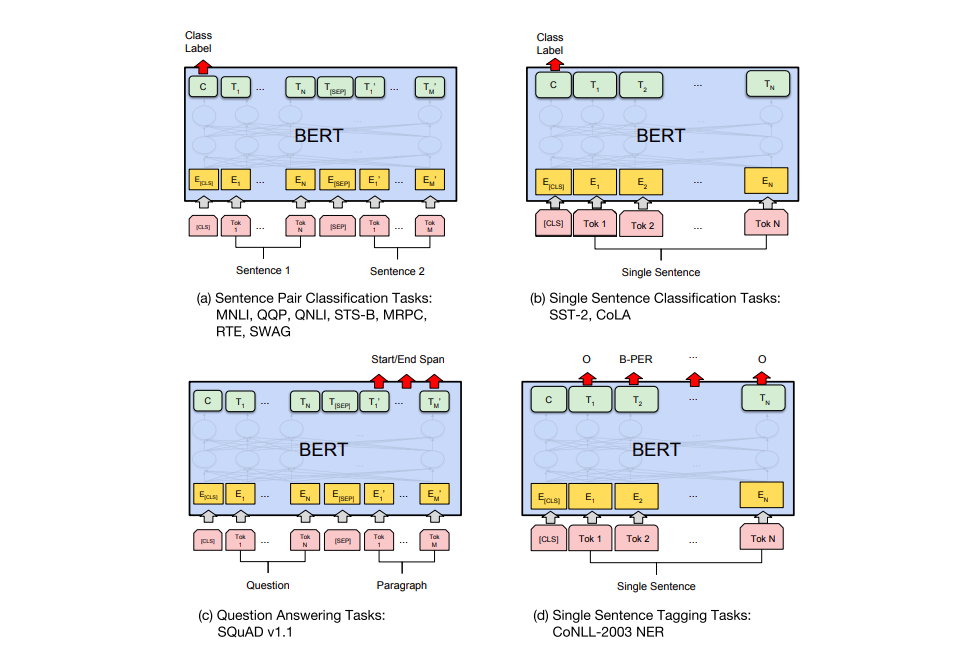

BERT' .

a) : MNLI, QQP, QNLI, STS-B, MRPC, RTE, SWAG; b) : SST-2, CoLA; c) - : SQuAD v1.1; d) : CoNLL-2003 NER.

BERT

– BERT. ELMo, BERT' . – , , , , (named-entity recognition).

? . 6 ( , 96,4):

- BERT'

BERT – BERT FineTuning with Cloud TPUs, Google Colab. Cloud TPU, , .. BERT' TPU, CPU GPU.

– BERT':

PyTorch- BERT'. AllenNLP BERT'a .