مقارنة موجزة بين بنية SDS أو إيجاد منصة تخزين مناسبة (GlusterVsCephVsVirtuozzoStorage)

تمت كتابة هذه المقالة لمساعدتك في اختيار الحل المناسب لنفسك وفهم الاختلافات بين SDS مثل Gluster و Ceph و Vstorage (Virtuozzo).يستخدم النص روابط لمقالات مع إفشاء أكثر تفصيلاً لمشاكل معينة ، لذا فإن الأوصاف ستكون مختصرة قدر الإمكان باستخدام النقاط الرئيسية دون الحاجة إلى معلومات أساسية وخلفية عن المياه غير ضرورية يمكنك الحصول عليها بشكل مستقل على الإنترنت إذا كنت ترغب في ذلك.في الواقع ، بالطبع ، الموضوعات التي تتناولها تتطلب أطنانًا من النصوص ، ولكن في العالم الحديث لا يرغب الكثير من الناس في القراءة كثيرًا))) ، حتى تتمكن من القراءة والاختيار بسرعة ، وإذا كان من غير الواضح اتباع الروابط أو الكلمات غير المفهومة في google))) ، وهذه المقالة بمثابة غلاف شفاف لهذه المواضيع العميقة ، توضح الحشوة - النقاط الرئيسية الرئيسية لكل قرار.بريق

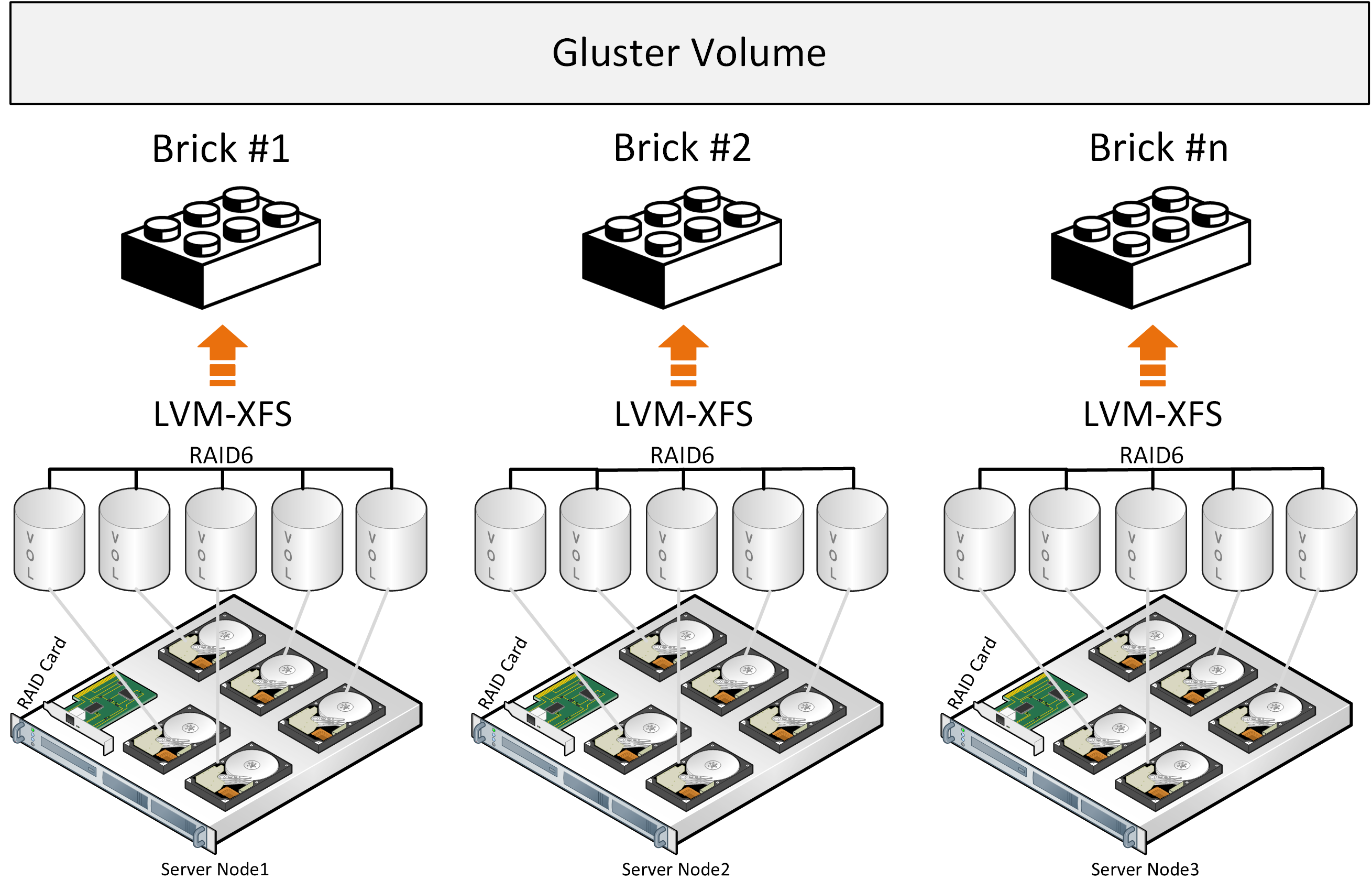

لنبدأ مع Gluster ، والذي يستخدم بنشاط من قبل الشركات المصنعة للمنصات شديدة التقارب مع SDS استنادًا إلى مصدر مفتوح للبيئات الافتراضية ويمكن العثور عليه على موقع RedHat في قسم التخزين ، حيث يُعرض عليك الاختيار من بين خيارين من SDS: Gluster أو Ceph.يتكون Gluster من مجموعة من المترجمين - الخدمات التي تقوم بكل عمل توزيع الملفات ، إلخ. الطوب - خدمة تخدم قرصًا واحدًا ، وحدة تخزين - وحدة تخزين (تجمع) - والتي تجمع بين هذه الطوب. بعد ذلك تأتي خدمة توزيع الملفات في مجموعات بسبب الوظيفة DHT (جدول التجزئة الموزع). لن نقوم بتضمين خدمة المشاركة في الوصف لأن الروابط أدناه سوف تصف المشاكل المرتبطة بها. عند التسجيل ، يتم وضع الملف بالكامل في الطوب ويتم كتابة نسخته بالتوازي على الطوب على الخادم الثاني. علاوة على ذلك ، سيتم بالفعل كتابة الملف الثاني إلى المجموعة الثانية من brik (أو أكثر) على خوادم مختلفة.إذا كانت الملفات بنفس الحجم تقريبًا ويتكون الحجم من مجموعة واحدة فقط ، فإن كل شيء على ما يرام ، ولكن في ظل ظروف أخرى ، ستنشأ المشاكل التالية من الأوصاف:

عند التسجيل ، يتم وضع الملف بالكامل في الطوب ويتم كتابة نسخته بالتوازي على الطوب على الخادم الثاني. علاوة على ذلك ، سيتم بالفعل كتابة الملف الثاني إلى المجموعة الثانية من brik (أو أكثر) على خوادم مختلفة.إذا كانت الملفات بنفس الحجم تقريبًا ويتكون الحجم من مجموعة واحدة فقط ، فإن كل شيء على ما يرام ، ولكن في ظل ظروف أخرى ، ستنشأ المشاكل التالية من الأوصاف:- المكان في المجموعات غير مستخدم بالتساوي ، يعتمد على حجم الملفات وإذا لم تكن هناك مساحة كافية في المجموعة لكتابة الملف ، فسوف تحصل على خطأ ، ولن تتم كتابة الملف ولن يتم إعادة توزيعه على مجموعة أخرى ؛

- عند كتابة ملف واحد ، يذهب IO إلى مجموعة واحدة فقط ، والباقي خاملاً ؛

- لا يمكنك الحصول على الإدخال / الإخراج لوحدة التخزين بالكامل عند كتابة ملف واحد ؛

- , , .

من الوصف الرسمي للهندسة المعمارية ، يتفهم المرء أيضًا بشكل لا إرادي أن اللمعان يعمل كمخزن ملفات أعلى RAID للأجهزة الكلاسيكية. كانت هناك محاولات لتطوير ملفات Sharding إلى كتل ، ولكن هذه وظيفة إضافية تضع خسائر الأداء على نهج معماري قائم ، بالإضافة إلى استخدام المكونات الموزعة بحرية مع قيود الأداء مثل Fuse. لا توجد خدمات بيانات تعريف ، مما يحد من إمكانات التخزين والتوزيع للملفات عند توزيع الملفات في كتل. يمكن ملاحظة أداء أفضل من خلال التكوين "Distributed Replicated" ، ويجب أن يكون عدد العقد 6 على الأقل لإنشاء نسخة متماثلة موثوقة من 3 مع التوزيع الأمثل للحمل.ترتبط هذه الاستنتاجات أيضًا بوصف تجربة استخدام Gluster وعند مقارنتها مع Ceph ، وهناك أيضًا وصف للتجربة في الوصول إلى فهم هذا التكوين " الأكثر تكرارا وأكثر إنتاجية " الذي يتم توزيعه. تُظهر الصورة توزيع الحمل عند تسجيل ملفين ، حيث يتم وضع نسخ من الملف الأول على الخوادم الثلاثة الأولى ، والتي يتم دمجها في مجموعة المجلد 0 وتقع ثلاث نسخ من الملف الثاني في المجلد الثاني للمجموعة 1 من الخوادم الثلاثة. لكل خادم قرص واحد.الاستنتاج العام هو أنه يمكنك استخدام Gluster ، ولكن مع إدراك أنه ستكون هناك قيود في الأداء والتسامح مع الأخطاء ، مما يخلق صعوبات في ظل ظروف معينة من حل متقارب للغاية ، حيث هناك حاجة أيضًا إلى الموارد لأحمال الحوسبة في البيئات الافتراضية.

تُظهر الصورة توزيع الحمل عند تسجيل ملفين ، حيث يتم وضع نسخ من الملف الأول على الخوادم الثلاثة الأولى ، والتي يتم دمجها في مجموعة المجلد 0 وتقع ثلاث نسخ من الملف الثاني في المجلد الثاني للمجموعة 1 من الخوادم الثلاثة. لكل خادم قرص واحد.الاستنتاج العام هو أنه يمكنك استخدام Gluster ، ولكن مع إدراك أنه ستكون هناك قيود في الأداء والتسامح مع الأخطاء ، مما يخلق صعوبات في ظل ظروف معينة من حل متقارب للغاية ، حيث هناك حاجة أيضًا إلى الموارد لأحمال الحوسبة في البيئات الافتراضية.

هناك أيضًا بعض مؤشرات أداء Gluster التي يمكن تحقيقها في ظل ظروف معينة عن طريق الحد من التسامح مع الخطأ.

سيف

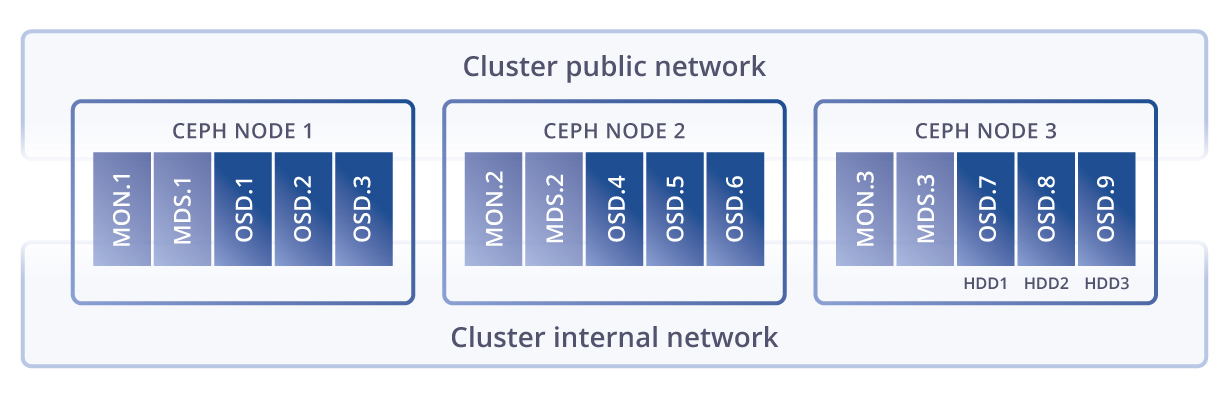

eph , . Glusterfs Ceph, Ceph , .

eph Gluster , . , , (), latency .

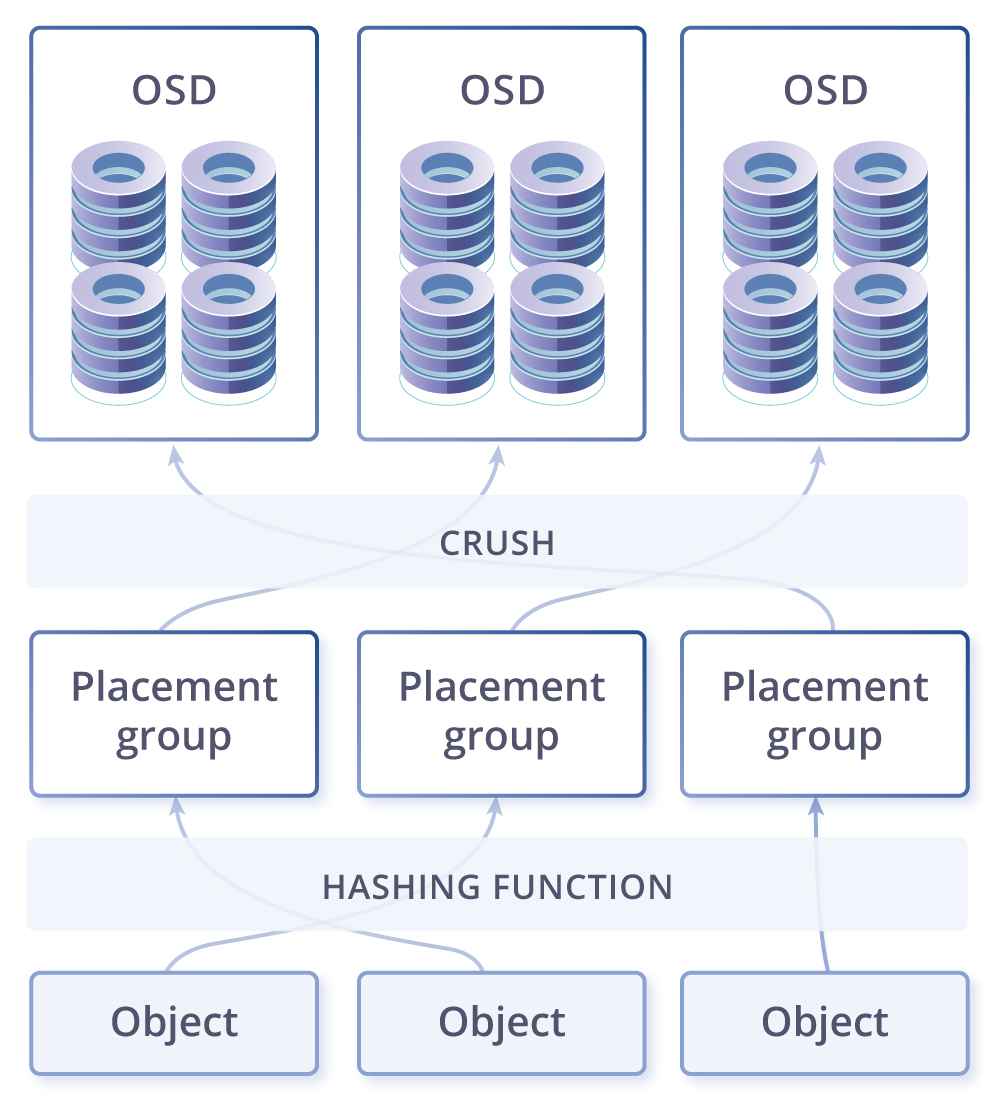

CRUSH, . PG — ( ) . PG , CRUSH . PG — -, . , , PG . OSD – .

. -. - , . , , - - ( ). , -, — , . .

- , , . . , – ( , ). – , . - , ( ), , , Ceph PG self-healing . , Ceph ( ), , .

-, . Ceph Gluster . – , linux, , , .

Vstorage

Virtuozzo storage(Vstorage), , , , . , .

kvm-qemu, , : FUSE(, open source), MDS (Metadata service), Chunk service, . , SSD, (erase coding raid6) all flash. EC(erase coding) : . eph EC , , Virtuozzo Storage “log-structured file system”, . EC , . – , .

, , , .

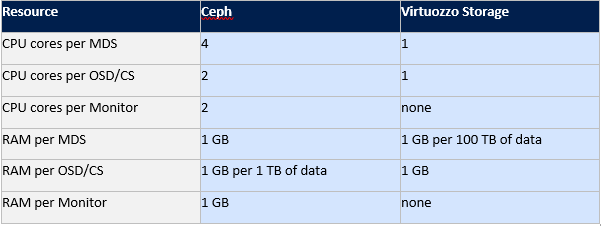

eph Virtuozzo storage.

Gluster Ceph , , Virtuozzo . Vstorage .

, , .

: ( FUSE), (MDS) ( CS), MDS , . . , 256.

, - , 256. , .… SSD , ( ), SSD, SSD, HDD, . SSD . , SSD , Latency , SSD, . , IOPS Vstorage , , , , ..

SSD, , , HDD. (MDS) , Paxos. FUSE, , , .

, , , . . SDS, fuse fast path Virtuozzo Storage. fuse open source , IOPS- . , eph Gluster.

: Virtuozzo Storage, Ceph Gluster.

, Virtuozzo Storage: , Fuse fast path, , compute(/), , . Ceph, Gluster, , .

تتضمن الخطط رغبة في كتابة مقارنة بين vSAN و Space Direct Storage و Vstorage و Nutanix Storage واختبار Vstorage على HPE ومعدات Huawei ، بالإضافة إلى سيناريوهات تكامل Vstorage مع أنظمة تخزين الأجهزة الخارجية ، لذلك إذا أعجبك المقال ، فسيكون من الجيد الحصول على تعليقات منك ، والتي يمكن أن تعزز الدافع لمقالات جديدة بناءً على تعليقاتك واقتراحاتك. Source: https://habr.com/ru/post/undefined/

All Articles